新智元报道

编辑:David 好困

看起来,继 Gary Marcus 之后,LeCun 的「一生之敌」可能又要多上一个了!

最近,LSTM 之父Jürgen Schmidhuber 一言不合又跟 LeCun 干上了!

其实之前稍微熟悉这位暴脾气大爷的同学都知道,特立独行的Jürgen Schmidhuber 和机器学习社区的几位大佬级人物之间都有过不愉快。

尤其是当「那三个人」一起拿了个图灵奖,而 Schmidhuber 却没有之后,这位老爷子就更气了……

(被遮住的那位是吴恩达)

说到底 Schmidhuber 一直认为,现在这几个 ML 领军人物,什么 Bengio、Hinton、LeCun,包括「GAN」之父 Goodfellow 等人,他们的很多所谓「开创性成果」都是自己先提出来的,而这些人在论文中根本就没提过他。

为此,Schmidhuber 曾经专门撰文把 Bengio、Hinton、LeCun 于 2015 年发在 Nature 上的综述性文章「Deep Learning」一文拿出来批判过一番。

主要是说这篇文章里的成果,哪些东西是他先提的,哪些东西是别的前辈先提的,反正不是这仨作者先提的。

怎么又吵起来了?

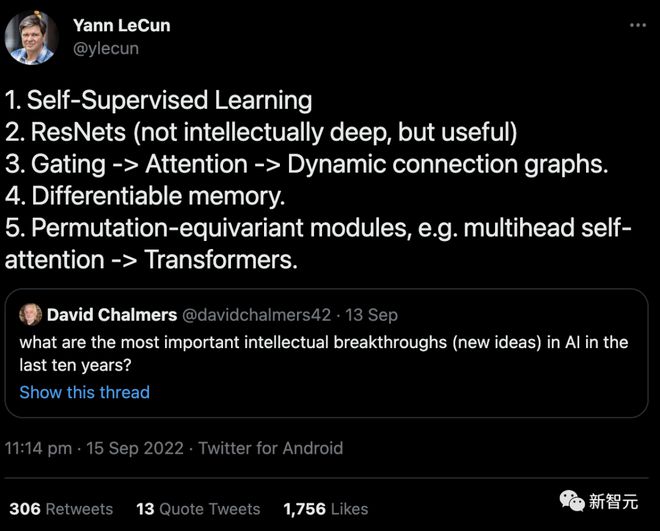

回到这次事件起因,实际上是 LeCun 在 9 月份发的一条推文。

内容是对 David Chalmers 教授提问的回答:「在过去十年中,AI 最重要的智力突破(新想法)是什么?」

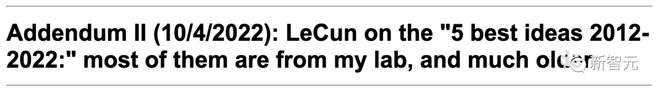

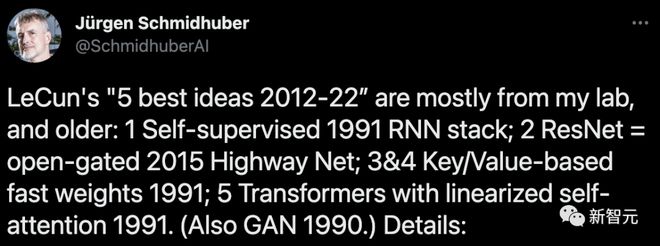

10 月 4 日,Schmidhuber 在他的博客上撰文怒斥:这 5 个「best idea」大部分都来自于我的实验室,而且提出的时间要远远早于「10 年」这个时间节点。

文中 Schmidhuber 详细列举了六大证据来支撑自己的论述。

但估计是因为看到的人太少,Schmidhuber 又在 11 月 22 日发推,重新把这个「冷饭」炒了一遍。

然而,相比于上一次还算激烈的争辩,这回 LeCun 连理都没理……

LSTM 之父摆出「六大证据」

1. 通过神经网络(NN)自动生成标注的「自监督学习」:至少可以追溯到我 1990-91 年的工作。

(I) 通过预测编码在一个循环神经网络(RNN)中进行自监督的目标生成,来学习在多个时间尺度和抽象层次上压缩数据序列。

在这里,一个「自动机」RNN 学会了「预测下一个输入」的前置任务,并将传入数据流中的意外观察作为目标发送给「分块机」RNN,后者学习更高层次的规律性,随后通过适当的训练目标将其获得的预测知识提炼回自动机中。

这大大促进了以前无法解决的序列分类的下游深度学习任务。

(II) 通过 GAN 类型的内在动机进行自监督的标注生成,其中一个世界模型 NN 学习预测对抗性的、标注生成的、实验发明的控制器 NN 的行为后果。

此外,我于 1990 年发表的论文标题中,就已经出现了「自监督」的说法。

但是吧,在更早期(1978 年)的论文中,也用到了这个词……

2. 「ResNets」:实际上就是我早期提出的 Highway Nets。但 LeCun 却认为 ResNets 的智力「不深」,这让我非常伤心。

在我提出 Highway Nets 之前,前馈网络最多只有几十层(20-30 层),而 Highway Nets 是第一个真正的深度前馈神经网络,有数百层。

在 1990 年代,我的 LSTM 给有监督的递归 NN 带来了基本无限的深度。在 2000 年代,LSTM 启发的 Highway Nets 给前馈 NN 带来了深度。

由此带来的是,LSTM 已经成为 20 世纪被引用最多的 NN,而 Highway Nets(ResNet)是 21 世纪被引用最多的 NN。

可以说,它们代表了深度学习的精髓,而深度学习就是关于 NN 的深度。

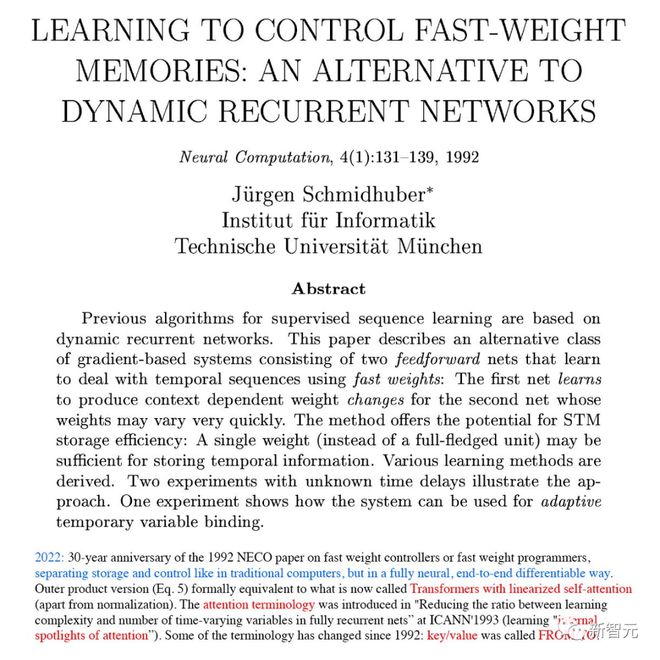

3. 「门控->注意力->动态连通图」:至少可以追溯到我的 Fast Weight Programmers 和 1991-93 年的 Key-Value Memory Networks(其中的「Key-Value」被称为「FROM-TO」)。

1993 年,我引入了现在使用的术语「注意力」。

不过值得注意的是,NN 中的第一个乘法门可以追溯到 1965 年 Ivakhnenko & Lapa 的深度学习机。

4. 「Differentiable memory」:同样可以追溯到我的 Fast Weight Programmers 或 1991 年的 Key-Value Memory Networks。

像传统计算机中那样分离存储和控制,但以端到端差分、自适应、完全神经的方式(而不是以混合方式)。

5. 「置换等变模块,例如多头自注意力->Transformer」:我在 1991 年发表了带有线性化自注意的 Transformer。相应的「注意力」术语(internal spotlights of attention)可以追溯到 1993 年。

6. 「GAN 是过去 10 年中最好的机器学习理念」

你提到的这个 GAN(2014 年)的原理,实际上是我在 1990 年以人工智能好奇心的名义提出的。

上一次,还是在几个月之前

其实这已经不是 Schmidhuber 和 LeCun 之间今年第一次发生争执了。

在六七月间,两人就关于 LeCun 发表的一篇「自主机器智能未来方向」的展望报告有来有回地吵了一番。

6 月 27 日,Yann LeCun 发表了自己积蓄几年的论文「A Path Towards Autonomous Machine Intelligence」,并称其为「指明 AI 未来发展方向之作」。

这篇论文系统讲述了关于「机器如何能像动物和人类一样学习」的问题,长达 60 多页。

LeCun 表示,此文不仅是自己关于未来5-10 年内关于 AI 发展大方向的思考,也是自己未来几年打算研究的内容,并希望能够启发 AI 界的更多人来一起研究。

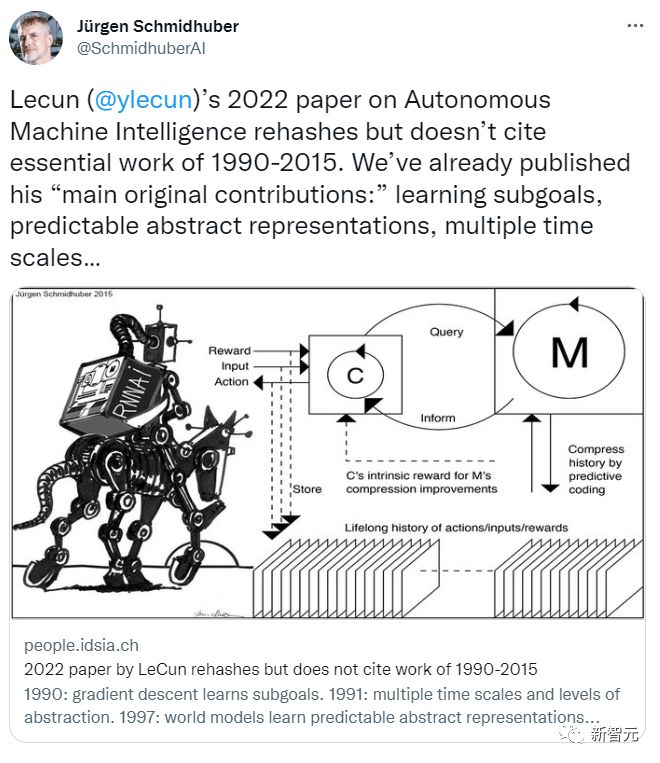

而 Schmidhuber 大概提前十几天就得知这个消息,并拿到了这篇论文,当即就写了一篇文章反驳。

按照 Schmidhuber 自己在博客上文章的说法,当时事情是这样的:

2022 年 6 月 14 日,一家科学媒体发布消息,说 LeCun 在 6 月 27 日要发布一篇报告,给我发了一份报告的草稿(当时还在保密期),并要求我发表评论。

我写了一篇评论,告诉他们这基本上是我们以前工作的翻版,而 LeCun 的文章中并没有提到。

然而,我的意见被置若罔闻。

实际上,早在他这篇东西发表以前,我们就提出了 LeCun 在这篇文中所谓的「主要原创贡献」的大部分内容,主要有:

(1) 「认知架构,其中所有模块都是可分的,而且许多模块是可训练的」(我们在 1990 年提出)。

(2) 「预测世界模型的分层结构,在多个抽象层次和多个时间尺度上学习表征」 (我们在 1991 年提出)。

(3) 「自我监督的学习范式,产生同时具有信息性和可预测性的表征」(我们的模型自 1997 年起就用于强化学习和世界建模了)

(4) 「用于不确定性下的分层规划」的预测模型,包括基于梯度的神经子目标生成器(1990 年)、抽象概念空间的推理(1997 年)、「主要通过观察学习行动」的神经网络(2015 年),以及学习思考(2015 年),都是我们先提出的。

7 月 14 日,Yann LeCun 回应,说讨论要有建设性,他是这么说的:

我不想陷入一场关于「某个概念是谁发明的」这种无谓争论中,也不想在你的回应文章中列出的 160 个参考文献中深究。我认为更有建设性的做法是,指出你认为可能包含我列出的 4 项贡献中的观点和方法的 4 篇出版物。 正如我在论文的开头所说,有许多概念已经存在了很长时间,你和我都不是这些概念的发明人:比如,可微调世界模型的概念,可以追溯到早期的优化控制工作。 训练世界模型利用神经网络学习世界模型的系统识别,这个想法可以追溯到 80 年代末,由 Michael Jordan, Bernie Widrow, Robinson & Fallside, Kumpathi Narendra, Paul Werbos 进行的工作,都比你的工作早。

在我看来,这个稻草人式的回答似乎是 LeCun 在转移话题,对他的所谓「主要原创贡献」中贪他人之功的问题避而不谈。

我在 7 月 14 日回复:

关于你说的「你我都没有发明的东西」:你的论文声称,用神经网络进行系统识别可以追溯到 20 世纪 90 年代初。然而,在你的之前的回应中,你似乎同意我的观点:这方面的第一篇论文出现在 1980 年代。

至于你的「主要原创贡献」,实际上都用了我早年间的工作成果。

(一) 关于你提出的「认知架构,其中所有模块都是可分化的,且许多模块都是可训练的」,「通过内在动机驱动行为」:

我在 1990 年就提出了用于在线学习和规划的可分化架构,这是第一个具有 「内在动机」的控制器,用以改善世界模型,它既是生成性的,也是对抗性的;你文中引用的 2014 年的 GAN 是这个模型的一个衍生版本。

(二)关于你提出的 「在多个抽象层次和时间尺度上学习表征的预测性世界模型的分层结构」:

这是由我 1991 年的神经历史压缩机实现的。它使用预测编码,以自监督的方式学习长序列数据的分层内部表征,大大促进了下游的学习。使用我 1991 年的神经网络提炼程序,这些表征可以被折叠成一个单一的循环神经网络(RNN)。

(三)关于你在控制方面的「自监督学习范式,产生同时具有信息性和可预测性的表征」:

这一点我在 1997 年提出构建的系统中已经提出。它不是预测未来输入的所有细节,而是可以提出任意的抽象问题,并在你所说的「表征空间」中给出可计算的答案。在这个系统中,两个名为「左脑」和「右脑」的学习模型,选择奖励最大化的对手进行零和博弈,偶尔还会在这种计算实验的结果上打赌。

(四)关于你的可用于不确定情况下的分层规划预测性可微分模型,你的文章里是这么写的:

「一个尚未回答的问题是,配置器如何学习将一个复杂的任务分解为一连串可以由智能体单独完成的子目标。我将把这个问题留给未来的调查。」

就别说什么未来了,实际上我在 30 多年前就发表过这样的文章:

一个控制器神经网络负责获得额外的命令输入,其形式为(开始,目标)。一个评估器神经网络负责学习预测从开始到目标的预期成本。一个基于可微调循环神经网络的子目标生成器看到了这个(开始,目标)的输入,并使用评估器神经网络,通过梯度下降学习一系列成本最小的中间子目标。

(五)你还强调了 「主要通过观察来学习行为」的神经网络。实际上我们很早就解决了这个问题,比 2015 年这篇文章,讨论了部分可观察环境中强化学习(RL)的一般问题。

世界模型M可能擅长预测一些事情,但对其他事情不确定。控制器C通过学习通过自我发明的问题序列(激活模式)来查询并解释答案(更多的激活模式)来最大化其目标函数。

C 可以从学习从M中提取任何类型的算法信息中获益,比如用于分层规划和推理,利用M中编码的被动观察等等。

不重要的彩蛋

有趣的是,线上售卖的一款文化衫就同时把这四位大佬列在了一起,而且还只要 13 刀。

不知道 Schmidhuber 看到之后,会有什么想法。

参考资料:

https://twitter.com/SchmidhuberAI/status/1594964463727570945

https://people.idsia.ch/~juergen/lecun-rehash-1990-2022.html#addendum2