新智元报道

编辑:编辑部

2022 超全的 AI 圈研究合集在这!知名博主 Louis Bouchard 自制视频讲解加短篇分析,对小白也超级友好。

虽然世界仍在复苏,但研究并没有放慢其狂热的步伐,尤其是在人工智能领域。

此外,今年人们对 AI 伦理、偏见、治理和透明度都有了新的重视。

人工智能和我们对人脑的理解及其与人工智能的联系在不断发展,在不久的将来,这些改善我们生活质量的应用将大放光彩。

知名博主 Louis Bouchard 也在自己的博客中盘点了 2022 年 32 项(!)AI 技术突破。

接下来让我们一起看看,这些令人惊艳的研究都有哪些吧!

文章地址:https://www.louisbouchard.ai/2022-ai-recap/

LaMA:基于傅里叶卷积的分辨率稳健的大型掩码修复

你肯定经历过这种情况:你和你的朋友拍了一张很棒的照片。结果,你发现有人在你身后,毁了你要发到朋友圈或者小红书的照片。但现在,这不再是问题。

基于傅里叶卷积的分辨率稳健的大型掩码修复方法,可以让使用者轻松清除图像中不需要的内容。不论是人,还是垃圾桶都能轻松消失。

它就像是你口袋里的专业 ps 设计师,只需轻轻一按,就能轻松清除。

虽然看似简单,但图像修复是许多 AI 研究人员长期以来一直需要解决的问题。

论文链接:https://arxiv.org/abs/2109.07161

项目地址:https://github.com/saic-mdal/lama

Colab Demo:https://colab.research.google.com/github/saic-mdal/lama/blob/master/colab/LaMa_inpainting.ipynb

视频讲解:https://youtu.be/Ia79AvGzveQ

短篇分析:https://www.louisbouchard.ai/lama/

STIT:基于 GAN 的真实视频人脸编辑

你肯定有过这样的经历:在看电影时,会发现电影中的演员看起来要比本人年轻得多。

《双子杀手》中的威尔·史密斯

之前,这需要专业人员花费数百甚至数千小时的工作,手动编辑这些演员出现的场景。但利用 AI,你可以在几分钟内完成。

事实上,许多技术可以让你增加笑容,让你看起来更年轻或更老,所有这些都是使用基于人工智能的算法自动完成的。它在视频中被称为基于 AI 的面部操作(AI-based face manipulations),代表了 2022 年的最新技术水平。

论文链接:https://arxiv.org/abs/2201.08361

项目地址:https://github.com/rotemtzaban/STIT

视频讲解:https://youtu.be/mqItu9XoUgk

短篇分析:https://www.louisbouchard.ai/stitch-it-in-time/

NeROIC:利用在线图库的神经渲染

神经渲染可以通过物体、人物或场景的图片,在空间中生成逼真的 3D 模型。

有了这项技术,你只需拥有某物体的几张图片,就可以要求机器了解这些图片中的物体,并模拟出它在空间中的样子。

通过图像来理解物体的物理形状,这对人类来说很容易,因为我们了解真实的世界。但对于只能看到像素的机器来说,这是一个完全不同的挑战。

生成的模型如何融入新场景?如果照片的光照条件和角度不同,生成的模型也会因此变化,该怎么办?这些都是 Snapchat 和南加州大学在这项新研究中需要解决的问题。

论文链接:https://arxiv.org/abs/2201.02533

项目地址:https://github.com/snap-research/NeROIC

视频讲解:https://youtu.be/88Pl9zD1Z78

短篇分析:https://www.louisbouchard.ai/neroic/

SpeechPainter:文本条件下的语音修复

对于图像来说,基于机器学习的修复技术不仅可以移除其中的内容,而且还能根据背景信息填充图像的缺失部分。

对于视频修复来说,其挑战在于不仅要保持帧与帧之间的一致性,而且要避免生成错误的伪影。同时,当你成功地将一个人从视频中「踢出去」之后,还需要把他/她的声音也一并删除才行。

为此,谷歌的研究人员提出了一种全新的语音修复方法,可以纠正视频中的语法、发音,甚至消除背景噪音。

论文链接:https://arxiv.org/abs/2202.07273

视频讲解:https://youtu.be/zIIc4bRf5Hg

短篇分析:https://www.louisbouchard.ai/speech-inpainting-with-ai/

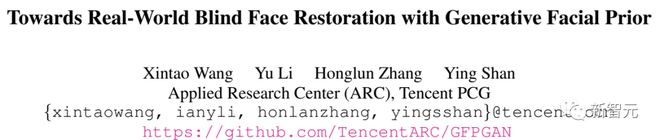

GFP-GAN:利用生成性面部先验,实现真实世界的盲脸修复

你是否有一些珍藏的旧照片,因为年代久远而画质模糊?不用担心,有了盲脸修复技术(Blind Face Restoration),你的回忆会被历久弥新。

这个全新且免费的 AI 模型可以在一瞬间修复你的大部分旧照片。即使修复前的照片画质非常低,它也能很好地工作。这在之前通常是一个相当大的挑战。

更酷的是,你可以按照自己喜欢的方式进行尝试。他们已经开源了代码,创建了一个演示和在线应用程序供大家试用。相信这项技术一定让你大吃一惊!

论文链接:https://arxiv.org/abs/2101.04061

项目地址:https://github.com/TencentARC/GFPGAN

Colab Demo:https://colab.research.google.com/drive/1sVsoBd9AjckIXThgtZhGrHRfFI6UUYOo

在线应用:https://huggingface.co/spaces/akhaliq/GFPGAN

视频讲解:https://youtu.be/nLDVtzcSeqM

短篇分析:https://www.louisbouchard.ai/gfp-gan/

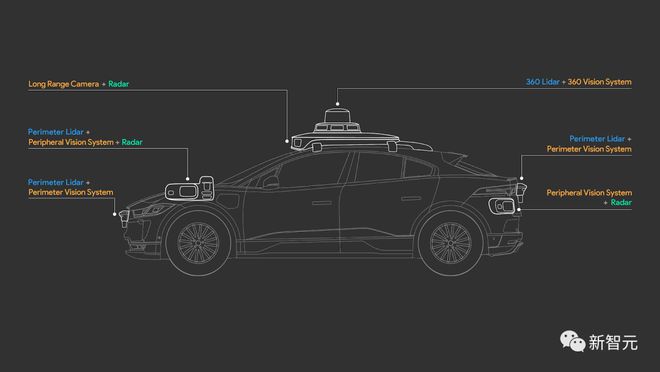

4D-Net:多模态对齐的学习

自动驾驶汽车如何「眼观六路」?

你可能听说过车企正在使用的 LiDAR 传感器或其他奇怪的相机。但它们是如何工作的,它们如何观察这个世界,以及它们与我们相比究竟看到了什么不同?

论文链接:https://arxiv.org/abs/2109.01066

与特斯拉只使用摄像头来了解世界不同,大多数自动驾驶汽车厂商,比如 Waymo,使用的是普通摄像头和 3D LiDAR 传感器。

它们不会像普通相机那样生成图像,而是生成 3D 点云,利用 RGB 传感信息,测量物体之间的距离,计算它们投射到物体的脉冲激光的传播时间。

尽管如此,我们如何有效地结合这些信息并让车辆理解它?车辆最终会看到什么?自动驾驶是否足够安全?Waymo 和谷歌的一篇新研究论文将会解答这些谜题。

视频讲解:https://youtu.be/0nJMnw1Ldks

短篇分析:https://www.louisbouchard.ai/waymo-lidar/

Instant NeRF:基于多分辨率哈希编码的即时神经图元

如何通过照片模拟世界的样子?

使用 AI 模型,人们可以将拍摄的图像变成高质量的 3D 模型。这项具有挑战性的任务,让研究人员通过 2D 图像,创建物体或人在三维世界中的样子。

通过基于哈希编码的神经图元(graphical primitives),英伟达实现 5 秒训练 NeRF,并获得了更好的效果。 在不到两年的研究中,将 NeRF 的训练速度提高了 1000 多倍。

论文链接:https://arxiv.org/abs/2201.05989

项目地址:https://github.com/NVlabs/instant-ngp

视频讲解:https://youtu.be/UHQZBQOVAIU

短篇分析:https://www.louisbouchard.ai/nvidia-photos-into-3d-scenes/

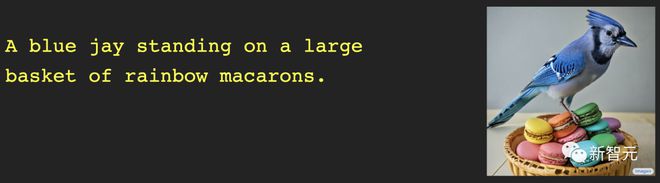

DALL·E 2:基于 CLIP 特征的文本生成图像模型

去年,OpenAI 发布了文本-图像生成模型 DALL·E。现在,升级版 DALL·E 2 又来了。

DALL·E 2 不仅可以从文本生成逼真的图像,其输出的分辨率是前者的四倍!

不过,性能方面的提升好像不足以令 OpenAI 满足,为此他们还让 DALL·E 2 学会了一项新技能:图像修复。

也就是说,你可以用 DALL·E 2 编辑图像,或者添加任何想要的新元素,比如在背景中加上一只火烈鸟。

论文链接:https://arxiv.org/abs/2204.06125

视频讲解:https://youtu.be/rdGVbPI42sA

短篇分析:https://www.louisbouchard.ai/openais-new-model-dall-e-2-is-amazing/

MyStyle:个性化生成先验

谷歌和特拉维夫大学提出了一个非常强大的 DeepFake 技术。拥有了它,你几乎无所不能。

只需给一个人拍上百张照片,就可以对其图像进行编码,并修复、编辑或创建出任何想要的样子。

这既令人惊奇又令人恐惧,尤其是当你看到生成的结果时。

论文链接:https://arxiv.org/abs/2203.17272

项目地址:https://mystyle-personalized-prior.github.io/

视频讲解:https://youtu.be/BNWAEvFfFvQ

短篇分析:https://www.louisbouchard.ai/mystyle/

OPT:开放预训练的 Transformer 语言模型

GPT-3 如此强大的原因,在于其架构和大小。

它有 1750 亿个参数,是人类大脑中神经元数量的两倍!如此巨大的神经网络使该模型几乎学习了整个互联网的内容,了解我们如何书写、交换和理解文本。

就在人们惊叹于 GPT-3 的强大功能时,Meta 向开源社区迈出了一大步。他们发布了一个同样强大的模型,并且,该模型已经完全开源了!

该模型不仅也有超过千亿级别的参数,并且,与 GPT-3 相比,OPT-175B 更加开放及便于访问。

论文链接:https://arxiv.org/abs/2205.01068

项目地址:https://github.com/facebookresearch/metaseq

视频链接:https://youtu.be/Ejg0OunCi9U

短篇分析:https://www.louisbouchard.ai/opt-meta/

BlobGAN:空间离散的场景表征

对于如何描述一个场景,Adobe 研究团队给出了一个新的方法:BlobGAN。

BlobGAN 使用「斑点」(blob)来描述场景中的对象。研究人员可以移动这些斑点,将它们变大、变小,甚至可以删除,这对图像中斑点所代表的物体都会产生同样的效果。

正如作者在他们的结果中分享的那样,你可以通过复制斑点,在数据集中创建新的图像。

现在,BlobGAN 的代码已经开源,感兴趣的小伙伴,抓紧快上手试试吧!

论文链接:https://arxiv.org/abs/2205.02837

项目地址:https://github.com/dave-epstein/blobgan

视频讲解:https://youtu.be/mnEzjpiA_4E

短篇分析:https://www.louisbouchard.ai/blobgan/

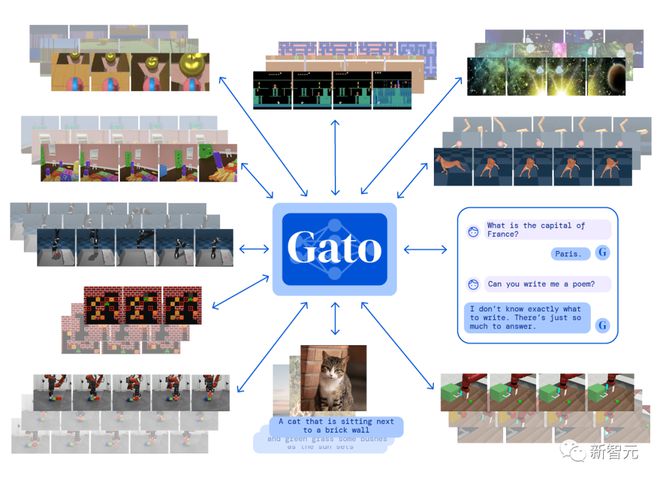

Gato:通才智能体

DeepMind 构建了一个单一的「通用」智能体 Gato。可以玩 Atari 游戏、做字幕图像、与人聊天、还能控制机械臂!

更令人震惊的是,它只训练一次并使用相同的权重,便能完成所有任务。

Gato 是一个多模态智能体。这意味着它既可以为图像创建标题,也能作为聊天机器人回答问题。

虽然 GPT-3 也能陪你聊天,但很明显,Gato 可以做到更多。毕竟,能聊天的 AI 常有,能陪玩游戏的不常有。

论文链接:https://arxiv.org/abs/2205.06175

视频讲解:https://youtu.be/xZKSWNv6Esc

短篇分析:https://www.louisbouchard.ai/deepmind-gato/

Imagen:具有深度语言理解的文本到图像的扩散模型

如果你认为 DALL·E 2 很优秀,那么不妨看看这个来自 Google Brain 的新模型——Imagen——可以做些什么。

DALL·E很神奇,但生成的图像往往缺乏真实感,这就是谷歌团队研发的 Imagen 所要解决的问题。

根据比较文本到图像模型的基准,Imagen 在大型语言模型的文本嵌入对文本-图像的合成方面成效显著。生成的图像既天马行空,又真实可信。

论文链接:https://arxiv.org/abs/2205.11487

项目地址:https://imagen.research.google/

视频讲解:https://youtu.be/qhtYPhPWCsI

短篇分析:https://www.louisbouchard.ai/google-brain-imagen/

DALL·E Mini

一组小扎的惊悚图曾在 Twitter 上风靡一阵。这组 San 值狂掉的作品,出自 DALL·E mini 之手。

作为 DALL·E家族的「青春版」,DALL·E mini 是胜在免费开源。代码已留,下一个被魔改的人物又会是谁呢?

项目地址:https://github.com/borisdayma/dalle-mini

在线体验:https://huggingface.co/spaces/dalle-mini/dalle-mini

视频讲解:https://youtu.be/K3bZXXjW788

短篇分析:https://www.louisbouchard.ai/dalle-mini/

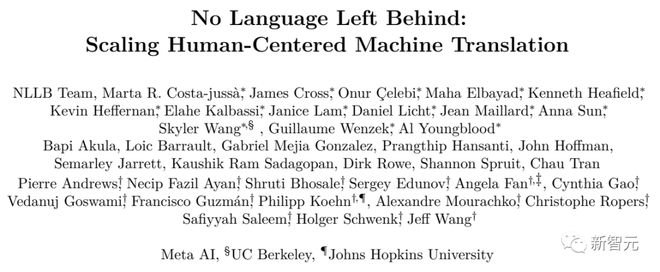

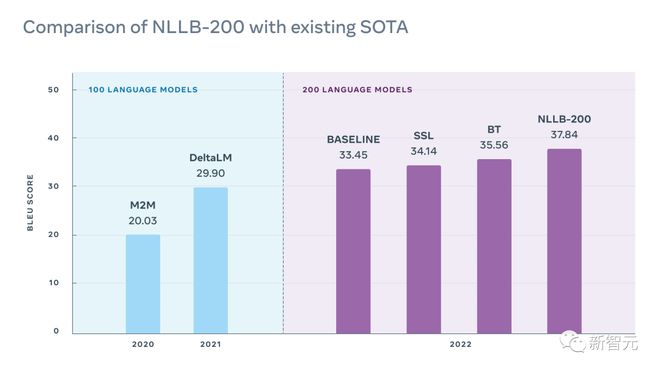

NLLB:不落下任何一种语言

Meta AI 发布的这款 NLLB-200 模型,模型命名理念来自「不落下任何一种语言」(No Language Left Behind),在 200 多种语言上实现了任意互译。

研究的亮点在于:研究者让大多数低资源语言训练提升多个数量级,同时实现了 200+ 语言翻译的 SOTA 结果。

论文链接:https://research.facebook.com/publications/no-language-left-behind/

项目地址:https://github.com/facebookresearch/fairseq/tree/nllb

在线体验:https://nllb.metademolab.com/

视频讲解:https://youtu.be/2G4NeG17Eis

短篇分析:https://www.louisbouchard.ai/no-language-left-behind/

Dual-Shutter 光学振动传感系统

声音也能被看见?

这篇获得 CVPR 2022 最佳论文荣誉奖的研究,提出了一种新颖的 Dual-Shutter 方法,通过使用「慢速」相机(130FPS)同时检测多个场景源的高速(高达 63kHz)表面振动,并通过捕获由音频源引起的振动来实现。

由此便可以实现乐器的分离、噪音的消除等各种需求。

项目地址:https://imaging.cs.cmu.edu/vibration/

视频讲解:https://youtu.be/n1M8ZVspJcs

短篇分析:https://www.louisbouchard.ai/cvpr-2022-best-paper/

Make-A-Scene:基于场景且有人类先验的文本到图像生成

Make-A-Scene 不仅仅是「另一个 DALL·E」。

虽然 DALL·E可以根据文本提示生成随机图像,这确实很酷,但同时也限制了用户对生成结果的控制。

而 Meta 的目标是推动创意表达,将这种文本到图像的趋势与之前的草图到图像模型相结合,从而产生「Make-A-Scene」:文本和草图条件图像生成之间的奇妙融合。

论文链接:https://arxiv.org/abs/2203.13131

视频讲解:https://youtu.be/K3bZXXjW788

短篇分析:https://www.louisbouchard.ai/make-a-scene/

BANMo:从任意视频中构建目标 3D 动画模型

基于 Meta 的这项研究,你只需给定捕获可变形对象的任意视频,比如上传几个小猫小狗的视频,BANMo 便可通过将来自数千张图像的 2D 线索整合到规范空间中,进而重建一个可编辑的动画 3D 模型,且无需预定义形状模板。

论文链接:https://arxiv.org/abs/2112.12761

项目地址:https://github.com/facebookresearch/banmo

视频讲解:https://youtu.be/jDTy-liFoCQ

短篇分析:https://www.louisbouchard.ai/banmo/

用潜在扩散模型进行高分辨率图像合成

今年大火的图像生成模型 DALL·E、Imagen 以及强势出圈的 Stable Diffusion,这些强大的图像生成模型有什么共同点?除了高计算成本、大量训练时间之外,它们都基于相同的扩散机制。

扩散模型最近在大多数图像任务中取得了 SOTA 结果,包括使用 DALL·E的文本到图像,还有许多其他与图像生成相关的任务,如图像修复、风格转换或图像超分辨率。

论文链接:https://arxiv.org/abs/2112.10752

项目地址:https://github.com/CompVis/latent-diffusion

视频讲解:https://youtu.be/RGBNdD3Wn-g

短篇分析:https://www.louisbouchard.ai/latent-diffusion-models/

PSG:基于场景的图像生成模型

AI 可以帮你准确识别图像中的物体,但是理解物体与环境之间的关系则没有那么轻松。

为此,来自南洋理工对研究人员提出了一种基于全景分割的全场景图生成(panoptic scene graph generation,即 PSG)任务。

相比于传统基于检测框的场景图生成,PSG 任务要求全面地输出图像中的所有关系(包括物体与物体间关系,物体与背景间关系,背景与背景间关系),并用准确的分割块来定位物体。

论文链接:https://arxiv.org/abs/2207.11247

在线应用:https://huggingface.co/spaces/ECCV2022/PSG

视频讲解:https://youtu.be/cSsE_H_0Cr8

短篇分析:https://www.louisbouchard.ai/psg/

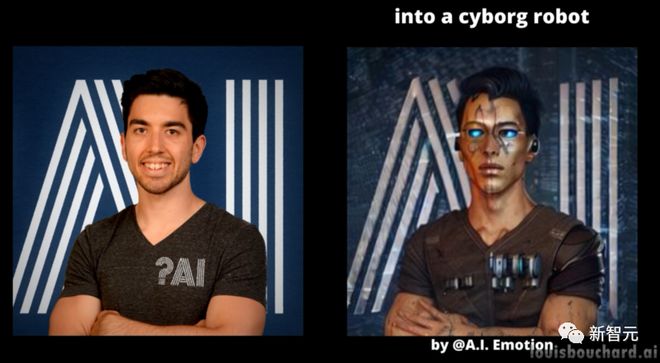

利用文本反转实现文本到图像的个性化生成

今年各大厂的图像生成模型可谓是八仙过海各显神通,但是如何让模型生成特定风格的图像作品呢?

来自特拉维夫大学的学者和英伟达合作推出了一款个性化图像生成模型,可以 DIY 你想要得到的图像。

论文链接:https://arxiv.org/abs/2208.01618

项目地址:https://textual-inversion.github.io/

视频讲解:https://youtu.be/f3oXa7_SYek

短篇分析:https://www.louisbouchard.ai/imageworthoneword/

用于通用视频识别的语言图像预训练模型

视觉文本模型的学习毫无疑问已经取得了巨大成功,然而如何将这种新的语言图像预训练方法扩展到视频领域仍然是一个悬而未决的问题。

来自微软和中科院的学者提出了一种简单而有效的方法使预训练的语言图像模型直接适应视频识别,而不是从头开始预训练新模型。

论文链接:https://arxiv.org/abs/2208.02816

项目地址:https://github.com/microsoft/VideoX/tree/master/X-CLIP

视频讲解:https://youtu.be/seb4lmVPEe8

短篇分析:https://www.louisbouchard.ai/general-video-recognition/

Make-A-Video:一键文本生成视频模型

画家在画布上尽情作画,如此清晰流畅的画面,你能想到视频的每一帧都是 AI 生成的吗?

MetaAI 推出的 Make-A-Video,只需简单输入几个文字,便可在几秒内生成不同风格的视频,说成「视频版 DALL·E」也不为过。

论文链接:https://arxiv.org/abs/2209.14792

视频讲解:https://youtu.be/MWwESVyHWto

短篇分析:https://www.louisbouchard.ai/make-a-video/

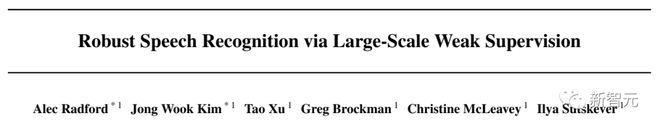

Whisper:大规模弱监督语音识别模型

你有没有想过有一个翻译软件可以快速翻译视频中的语音,甚至是那些你自己都听不懂的语言?

OpenAI 开源的 Whisper 恰好就能做到这一点。

Whisper 在超过 68 万小时的多语种数据上训练,能识别嘈杂背景下的多语种声音并转化为文字,此外还可胜任专业术语的翻译。

论文链接:https://arxiv.org/abs/2212.04356

项目地址:https://github.com/openai/whisper

视频讲解:https://youtu.be/uFOkMme19Zs

短篇解析:https://www.louisbouchard.ai/whisper/

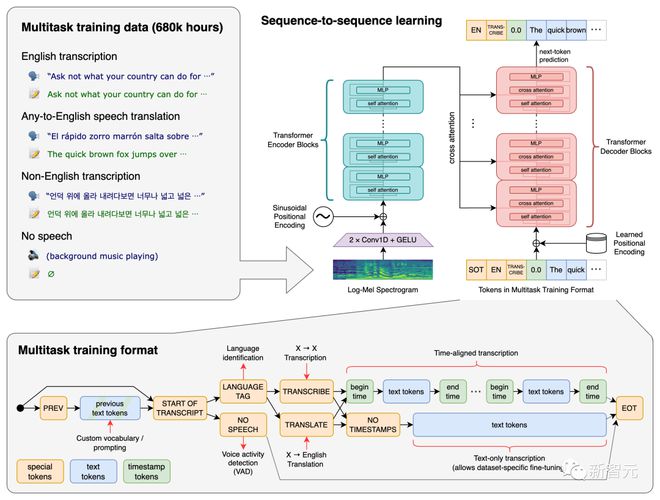

DreamFusion:用 2D 图像生成 3D 模型

文本能生成图像、视频,还有 3D 模型~

谷歌推出的 DreamFusion 通过使用预训练的 2D 文本到图像扩散模型可一键生成 3D 模型,在数十亿图像文本对上训练的扩散模型推动了文本到 3D 模型合成的最新突破。

论文链接:https://arxiv.org/abs/2209.14988

视频讲解:https://youtu.be/epuU0VRIcjE

短篇解析:https://www.louisbouchard.ai/dreamfusion/

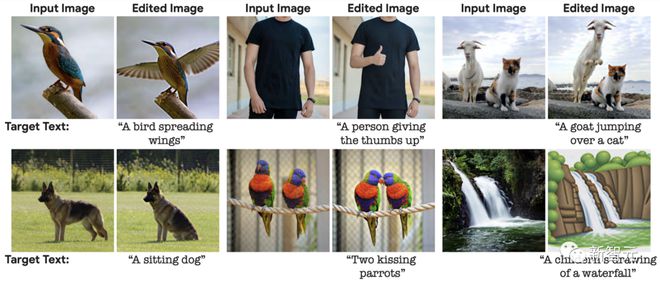

Imagic:基于扩散模型的真实图像编辑方法

使用 DALL·E等文本图像生成模型,只需输入一行文字便能得到想要的图片,但 AI 生成的图像有时候并不那么完美。

来自谷歌、以色列理工学院、魏茨曼科学研究所的研究者介绍了一种基于扩散模型的真实图像编辑方法——Imagic,只用文字就能实现真实照片的 PS。

例如,我们可以改变一个人的姿势和构图同时保留其原始特征,或者我想让一只站立的狗坐下,让一只鸟展开翅膀。

论文链接:https://arxiv.org/abs/2210.09276

项目地址:https://imagic-editing.github.io/

视频讲解:https://youtu.be/gbpPQ5kVJhM

短篇分析:https://www.louisbouchard.ai/imagic/

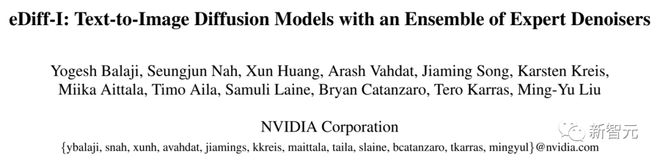

eDiffi:更高品质的文本图像合成模型

比 DALL·E和 Stable Diffusion 更强的图像合成模型来了!

这就是英伟达的 eDiffi,它可以更准确地生成更高品质的图像,此外加入画笔模具,可以为你的作品增加更多创造性和灵活性。

论文链接:https://arxiv.org/abs/2211.01324

项目地址:https://deepimagination.cc/eDiff-I/

视频讲解:https://youtu.be/grwp-ht_ixo

短篇分析:https://www.louisbouchard.ai/ediffi/

Infinite Nature:从单幅图像中学习自然场景的无限视图生成

你有没有想过,随手拍一张照片然后就像打开一扇门一样飞进图片里呢?

来自谷歌和康奈尔大学的学者将这一想象变为了现实,这就是 InfiniteNature-Zero,他可从单幅图像中生成无限制的自然场景视图。

论文链接:https://arxiv.org/abs/2207.11148

项目地址:https://infinite-nature.github.io/

视频讲解:https://youtu.be/FQzGhukV-l0

短篇分析:https://www.louisbouchard.ai/infinitenature-zero

Galactica:用于科学的大语言模型

Meta 开发的 Galactica 是一种大型语言模型,其大小与 GPT-3 相当,但它擅长的领域是科学知识。

该模型可编写政府白皮书、新闻评论、维基百科页面和代码,它还知道如何引用以及如何编写方程式。这对人工智能和科学来说是一件大事。

论文链接:https://arxiv.org/abs/2211.09085

视频讲解:https://youtu.be/2GfxkCWWzLU

短篇分析:https://www.louisbouchard.ai/galactica/

RAD-NeRF:基于音频空间分解的实时人像合成模型

自从 DeepFake 和 NeRF 的出现,AI 换脸似乎已经是司空见惯了,但有个问题,AI 换的脸有时会因为对不上嘴型而露馅。

RAD-NeRF 的出现可以解决这一问题,它可以对视频中所出现的说话者进行实时的人像合成,此外还支持自定义头像。

论文链接:https://arxiv.org/abs/2211.12368

项目地址:https://me.kiui.moe/radnerf/

视频讲解:https://youtu.be/JUqnLN6Q4B0

短篇分析:https://www.louisbouchard.ai/rad-nerf/

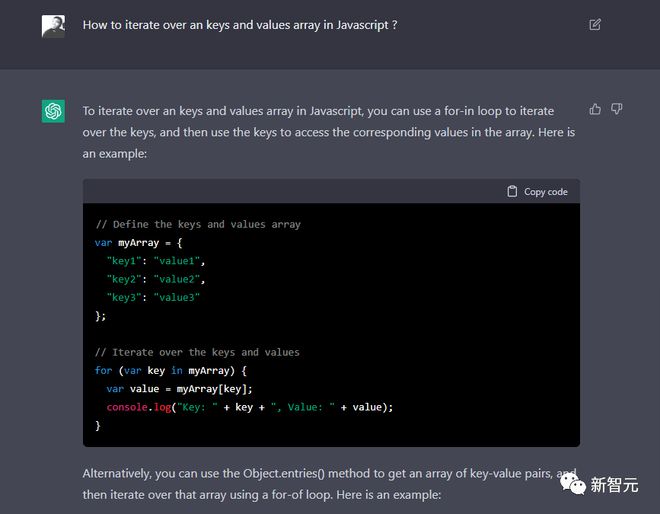

2022 年度 AI 的重磅作品怎么能少了 ChatGPT,这个已经火遍全网并已经被网友开发出写小黄文、敲代码等各种应用的万能模型,如果你还不了解它,那就快来看看!

视频讲解:https://youtu.be/AsFgn8vU-tQ

短篇分析:https://www.louisbouchard.ai/chatgpt/

可直接用于生产使用的视频人脸 re-aging

虽然当下计算机视觉模型可以对人脸的年龄进行生成、风格迁移等,但这也只是看起来炫酷,在实际应用中却几乎零作用,现有的技术通常存在着面部特征丢失、分辨率低和在后续视频帧中结果不稳定的问题,往往需要人工二次编辑。

最近迪士尼发布了第一个可实用的、完全自动化的、可用于生产使用的视频图像中 re-age 人脸的方法 FRAN(Face Re-Aging Network),正式宣告电影中靠化妆师改变演员年龄视觉效果的技术落幕。

论文链接:https://dl.acm.org/doi/pdf/10.1145/3550454.3555520

项目地址:https://studios.disneyresearch.com/2022/11/30/production-ready-face-re-aging-for-visual-effects/

视频讲解:https://youtu.be/WC03N0NFfwk

短篇分析:https://www.louisbouchard.ai/disney-re-age/

参考资料: