哪些机构或国家(地区)发表的 AI 研究是最具影响力的?

为了弄清这个问题,美国 Zeta Alpha 平台统计了 2020-2022 三年之间全世界引用次数前 100 的 AI 论文,得出了一些很有意思的结果。

比如:

“当红明星”OpenAI,在论文引用次数最多的机构中名列第9。

然而,在论文发表数量最多的机构榜单上,根本找不到它的名字。

再比如,来自工业界的谷歌 Meta 微软总是在各项数据都名列前茅,然而总的看下来,学术界也并没有落后工业界。

此外,此前关于“中国 AI 研究的产出数量和质量可能超过美国”的观点在这份报告中似乎也被破解——

更多以及具体的数据,我们一个一个来看。

中国第二,OpenAI、DeepMind 质量取胜

在具体分析之前,Zeta Alpha 先统计出了 2020-2022 每年引用次数最多的论文,它们分别是:

2022 年:

1、AlphaFold Protein Structure Database: Massively expanding the structural coverage of protein-sequence space with high-accuracy models

引用次数:1372

机构:DeepMind

主题:利用 AlphaFold 增加蛋白质结构数据库的覆盖范围

2、ColabFold: making protein folding accessible to all

引用次数:1162

机构:多家合作完成

主题:一种开源且高效的蛋白质折叠模型

3、Hierarchical Text-Conditional Image Generation with CLIP Latents

引用次数:718

机构:OpenAI

主题:DALL·E 2

4、A ConvNet for the 2020s

引用次数:690

机构:Meta 和 UC 伯克利大学

主题:在 Transformer 繁荣时期成功实现 CNN 现代化

5、PaLM: Scaling Language Modeling with Pathways

引用次数:452

机构:谷歌

主题:谷歌的 540B 大型语言模型,一个新的 MLOps 范式,包含它的实现过程

2021 年

1、Highly accurate protein structure prediction with AlphaFold

引用次数:8965

机构:DeepMind

主题:AlphaFold,利用深度学习进行蛋白质结构预测的巨大突破

2、Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

引用次数:4810

机构:微软

主题:ViT 的强大变体

3、Learning Transferable Visual Models From Natural Language Supervision

引用次数:3204

机构:OpenAI

主题:CLIP

4、On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?

引用次数:1266

机构:美国华盛顿,Black in AI,The Aether

主题:著名的立场论文,对不断增长的语言模型的趋势持批评态度,强调了它们的局限性和危险

5、Emerging Properties in Self-Supervised Vision Transformers

引用次数:1219

机构:Meta

主题:DINO,揭示了图像的自监督如何导致 Transformers 中出现某种原型对象分割

2020 年:

1、An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

引用次数:11914

机构:谷歌

主题:第一个展示普通 Transformer 如何在计算机视觉领域中表现出色的作品

2、Language Models are Few-Shot Learners

引用次数:8070

机构:OpenAI

主题:GPT-3

3、YOLOv4: Optimal Speed and Accuracy of Object Detection

引用次数:8014

机构:中国台湾“中研院”

主题:YOLOv4

4、Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

引用次数:5906

机构:谷歌

主题:对 Transformer 的迁移学习进行了严格的研究,产生了著名的 T5

5、Bootstrap your own latent: A new approach to self-supervised Learning

引用次数:2873

机构:DeepMind 和帝国理工学院

主题:表明 negative 对于表征学习来说不是必需的

想必大家能从中找到不少“熟悉的面孔”。

接着,Zeta Alpha 就对近三年的高引用论文背后的信息进行了一番分析。

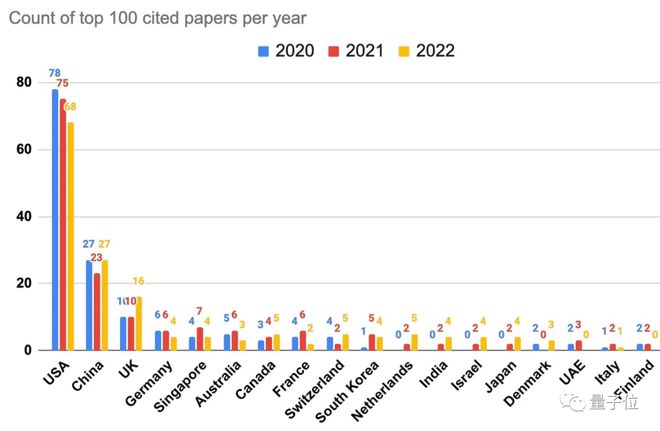

首先是“每年论文引用次数进前100 最多”的国家(地区)。

可以看到美国强势第一,中国与之的差距比较明显。

因此 Zeta Alpha 也认为,此前关于“中国在 AI 方面的研究可能超过美国”的说法至少在这项数据上是不成立的。

除此之外,新加坡和澳大利亚的排名也比较出人意料,分别为第五和第六。

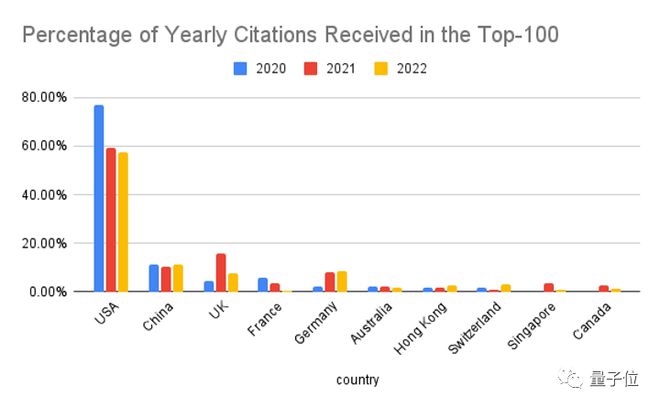

“为了正确评估美国的主导地位”,Zeta Alpha 又换了一种统计方式,计算引用次数前 100 的百分比。

当然,美国仍然第一,但可以看到三年间的占比有所下降。

英国是中美以外最大的竞争对手,不过英国表现突出的 2022 年,其实主要都是由 DeepMind 贡献的(占比 69%)。

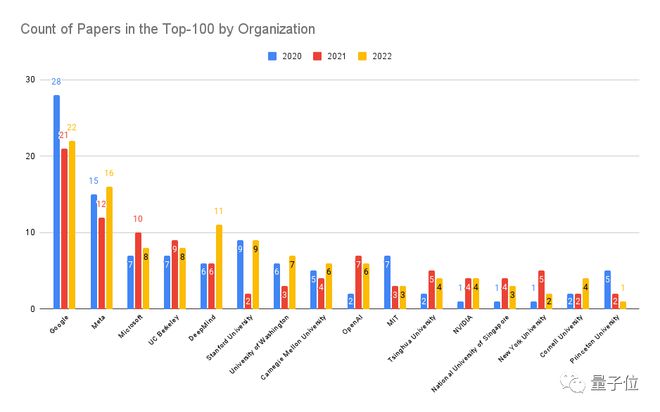

接下来是按组织或机构评比论文引用次数进前 100 最多的个体。

不太意外,谷歌与 Meta 微软分列前三,随后是 UC 伯克利、DeepMind 和斯坦福。

OpenAI 也收获了一个还不错的名次,第九。第十是 MIT,第十一是清华大学。

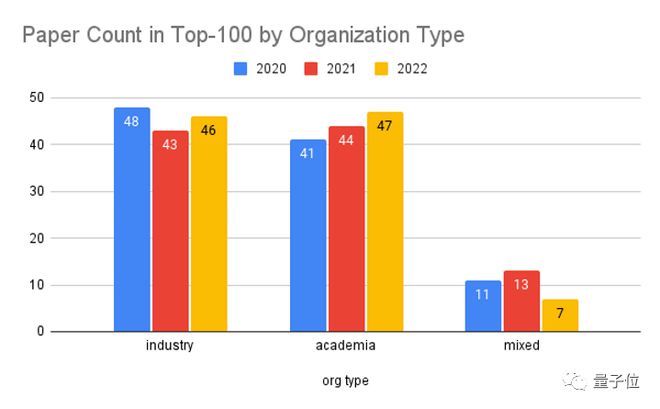

尽管前三名选手都来自工业界,但是如果只按照机构类型来分,学术界和它的表现其实基本不相上下。

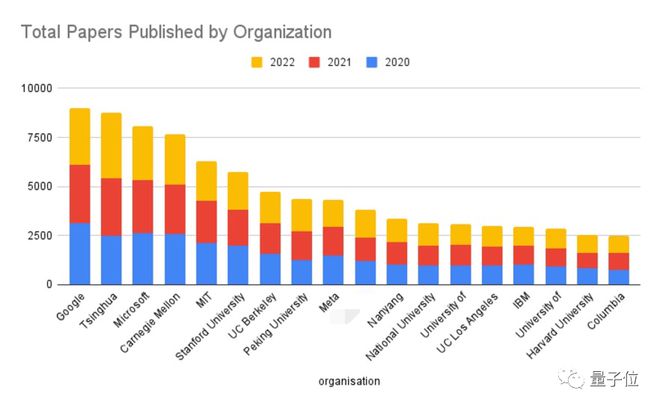

再接着,是过去三年各组织或机构发表的论文总数排名。

老大还是谷歌。第二名比较亮眼,是清华大学,随后是微软、CMU、MIT、斯坦福、UC 伯克利、北京大学(第八)、Meta……

可以看到,前十里隶属于学术界的机构或组织占据了大片江山。

而我们找了半天,也没有看到 OpenAI 和 DeepMind 的名字——

显然它们发表的论文数量较少,主要靠质量取胜。

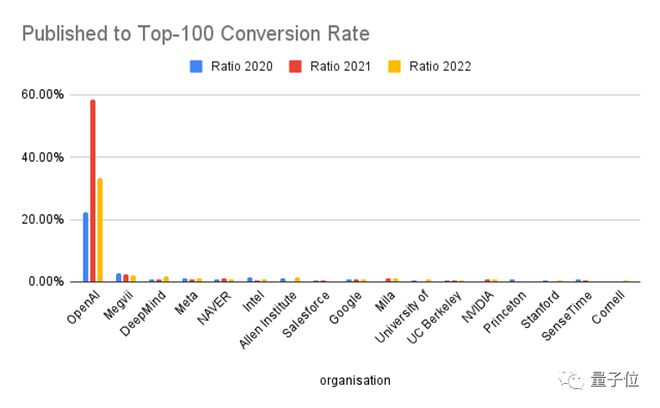

为了验证这一猜测,Zeta Alpha 也做了一个高引论文转化率的排名。

果不其然,OpenAI 摘得桂冠,DeepMind 获得第三。

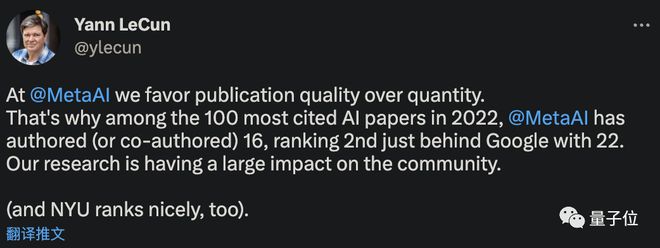

当然,Meta 也不错,第四,引得 LeCun 都出来“现身说法”了一下:我们 Meta 确实是更注重质量而不是数量的。

相比之下,高引多但发得更多的谷歌才排第九,差点出前 10。

除了这几位,第二名也是亮点——它就是旷视。

以及国内还有商汤也上榜了。

附 2022 引用 Top100 完整名单

ChatGPT 的火着实盘活了 AI 产业,最新前沿研究究竟会指往哪些方向?我们也需要更加敏锐地进行观察。

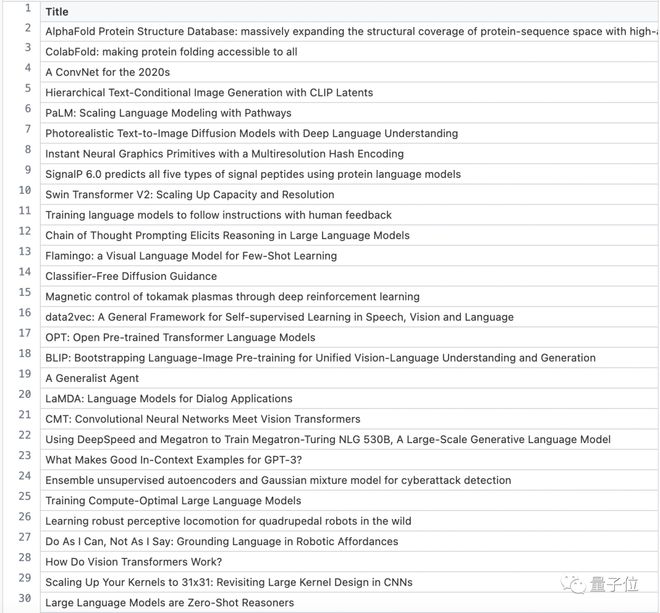

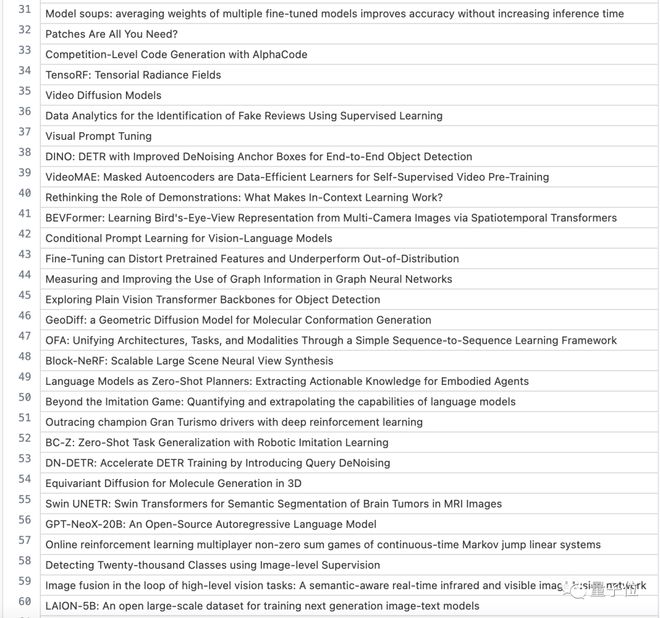

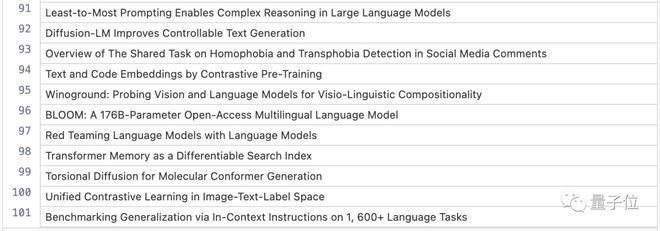

为此,Zeta Alpha 也给出了 2022 年引用进 100 的所有 AI 论文的名单,或许对大家有所启发。

1-30:

31-60:

61-90:

91-100:

那么,Zeta Alpha 这份报告的全部内容就是这些。

原文可戳:

https://www.zeta-alpha.com/post/must-read-the-100-most-cited-ai-papers-in-2022