白交发自凹非寺

量子位公众号 QbitAI

Mistral-Medium 竟然意外泄露?此前仅能通过 API 获得,性能直逼 GPT-4。

CEO 最新发声:确有其事,系早期客户员工泄露。但仍表示敬请期待。

换句话说,这个版本尚且还是旧的,实际版本性能还会更好。

这两天,这个名叫“Miqu”的神秘模型在大模型社区里炸了锅,不少人还怀疑这是 LIama 的微调版本。

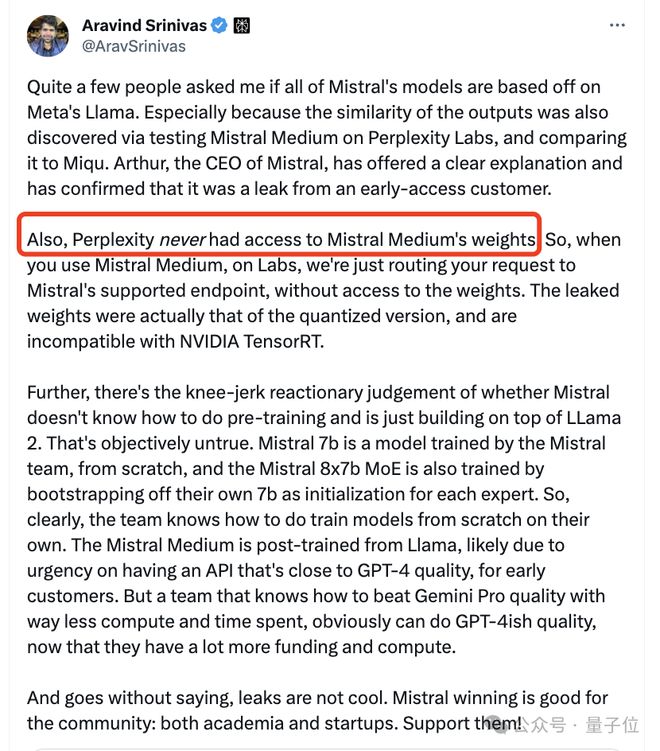

对此 Mistral CEO 也做出了解释, Mistral Medium 是在 Llama 2 基础上重新训练的,因为需尽快向早期客户提供更接近 GPT-4 性能的 API, 预训练在 Mistral 7B 发布当天完成。

如今真相大白,CEO 还卖关子,不少网友在底下戳戳手期待。

Mistral-Medium 意外泄露

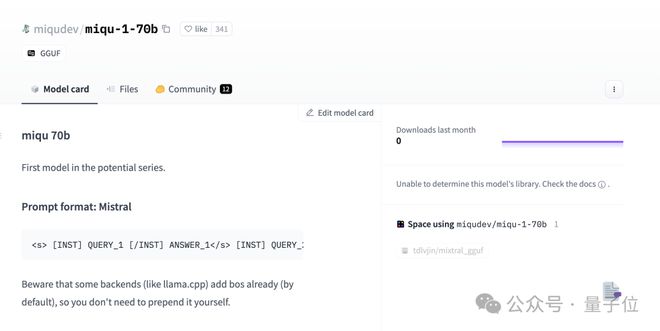

我们还是重新来回顾一下整个事件。1 月 28 日,一个名叫 Miqu Dev 的神秘用户在 HuggingFace 上发布一组文件“miqu-1-70b”。

文件指出新 LLM 的“提示格式”以及用户交互方式同 Mistral 相同。

同一天,4chan 上一个匿名用户发布了关于 miqu-1-70b 文件的链接。

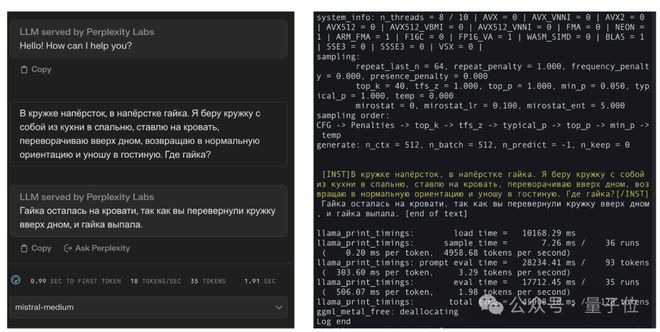

于是乎一些网友注意到了这个神秘的模型,并且开始进行一些基准测试。

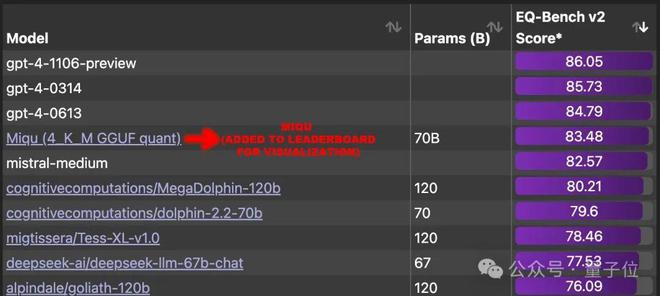

结果惊人发现,它在 EQ-Bench 上获得 83.5 分(本地评估),超过世界上除 GPT-4 之外的所有其他大模型。

一时间,网友们强烈呼吁将这个大模型添加到排行榜中,并且找出背后的真实模型。

大致怀疑方向主要有三个:

- 与 Mistral-Medium 是同一个模型

有网友晒出了对比效果:它知道标准答案还说得过去,但不可能连俄语措辞也跟 Mistral-Medium 完全相同吧。

- Miqu 应该是 LIama 2 的微调版本。

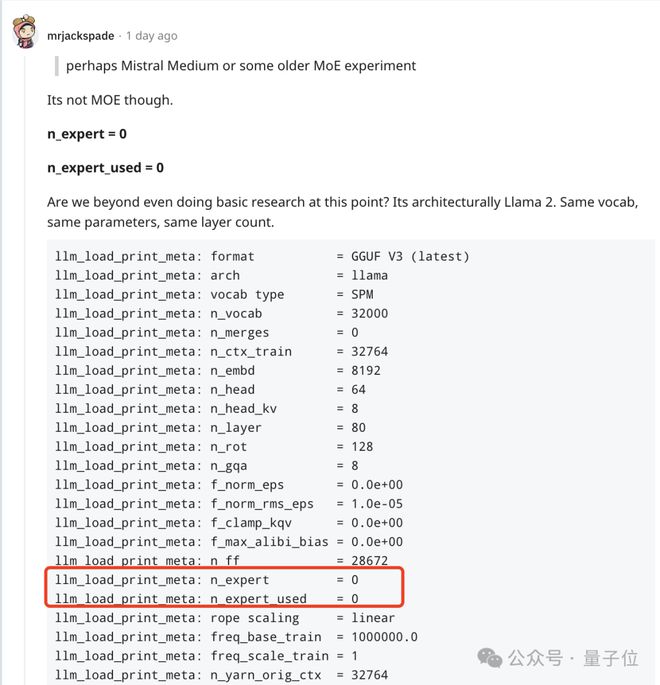

但另外的网友发现,它并不是 MoE 模型,并且同 LIama 2 架构相同、参数相同、层数相同,。

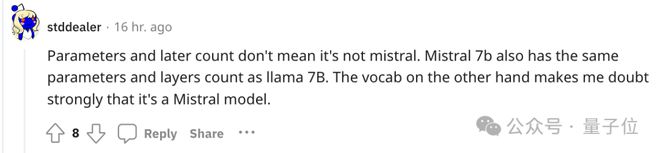

不过马上就受到其他网友的质疑,Mistral 7b 也具有与 llama 7B 相同的参数和层数。

相反,这更像是Mistral 早期非 MoE 版本模型。

不过讨论来讨论去,不可否认的是在不少人心中,这已经是最接近 GPT-4 的模型了。

如今,Mistral 联合创始人兼首席执行官 Arthur Mensch 承认泄露,是他们一位早期客户员工过于热情,泄露了他们训练并公开发布的一个旧模型量化版本。

至于 Perplexity 这边 CEO 也澄清说,他们从未获得过 Mistral Medium 的权重。

网友担心是否会撤下这个版本。

有趣的是,Mensch 并没有要求删除 HuggingFace 上的帖子。

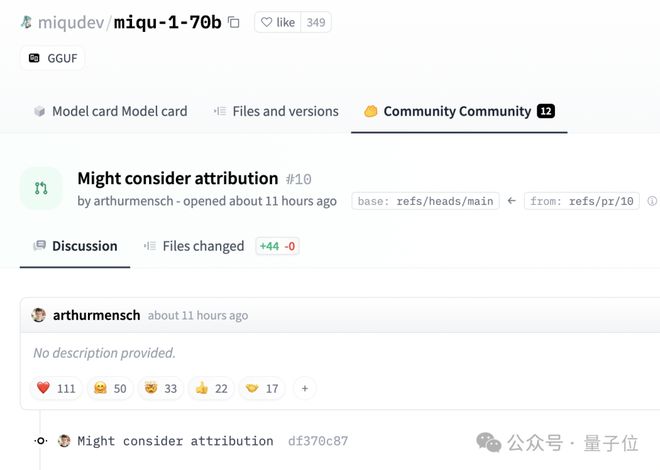

而是留下评论说:可能会考虑归属问题。

参考链接: