Meta 公司本月早些时候发布了 Quest v64 更新,正式为 Quest 3 带来了改进的透视质量、外部麦克风支持和躺卧模式,并移除了头显摘下时停止投屏的限制。然而,细心的 Quest 用户们发现,除了官方提到的功能之外,v64 更新还悄悄加入了两个重要特性:家具识别和手部追踪与手柄的混合使用功能。

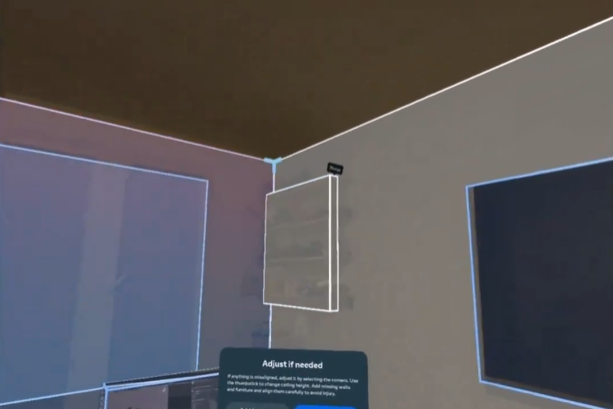

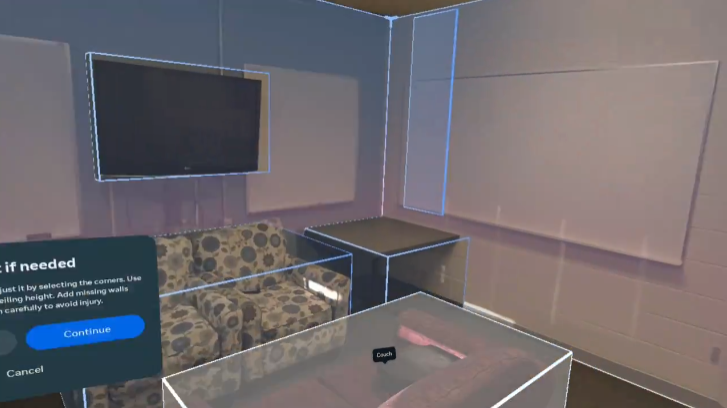

更新后的 Quest 3 在混合现实设置过程中会生成房间的 3D 模型,并能识别墙壁、地板和天花板的位置。过去,Quest 3 无法识别诸如门、窗户、家具和电视等更具体的元素,用户只能手动标记这些元素,这对于开发者来说并不友好。

IT 之家注意到,v64 更新后,在完成混合现实房间扫描之后,Quest 3 将会自动识别并创建以下物品的矩形标记框:

-

门

-

窗户

-

床

-

桌子

-

沙发

-

储物柜 (衣柜、架子等)

-

屏幕 (电视和显示器)

开发者可以通过 Meta 的场景 API 访问这些标记框,并利用它们自动放置虚拟内容。例如,他们可以将棋盘游戏板放在房间里最大的桌子上,用传送门取代窗户,或者在纯 VR 游戏中绘制出用户的电视,防止玩家误撞。

需要注意的是,目前这项家具识别的功能还比较粗糙,例如对于沙发,v64 只会生成一个简单的矩形框,而相比之下,Meta 上个月展示的场景脚本 (SceneScript) 研究项目则可以将沙发分开识别为座位区、扶手区和靠背区。显然,场景脚本需要更多的计算能力,而本次更新的家具识别功能更像是实用化的第一步。

另一个被加入到 v64 更新中的特性则是“混合输入”功能。自去年以来,Quest 开发者就可以尝试同时使用手部追踪和 Quest 3 或 Quest Pro 手柄,并且也可以将使用该功能的应用发布到 Quest 商店和 App Lab。v64 更新将“混合输入”功能加入到了 Quest 主页面的透视模式和 VR 模式中,需要注意的是,该功能仅适用于 Quest 3 或 Quest Pro 手柄。

“混合输入”功能可以让玩家在手部追踪和手柄追踪之间即时切换,无任何延迟。还允许用户仅用一只手柄进行操作,同时还能追踪另一只手。