梦晨金磊发自凹非寺

量子位公众号 QbitAI

医学影像,越来越需要 AI 的帮助了。

根据数据统计,目前我国医学影像数据年增速在 30%,但影像科医生年增速却只有4%,医生面临较大的工作压力。

那么,AI 医学影像市场发展得如何呢?

AI 影像行业,是人工智能在医疗领域里面探索最久的赛道之一,近年来人工智能辅助诊断三类证的获批数量持续增长,整个人工智能医学影像市场预计会在 4 年左右的时间突破百亿,保持高增长。

参考亿欧智库发布的《2023 年中国人工智能医学影像产品生态路线研究报告》,2023 年我国 AI 医学影像市场规模为 24 亿元,2030 年将达到 137.4 亿元,年复合增长率为 33.8%。

虽然有了 AI 帮忙,能提升诊疗效率、改善患者就医体验,但同时也带来一个问题:

医院对于医学影像系统的花费越来越高了,患者看病的成本也大幅提高。

所以在这个技术飞速进步的时代,医院不是简单采用新技术就能造福患者的,也要综合考虑投入产出,才能关怀到每个病人。

在这样的背景下,医学影像系统如何在满足功能、性能需求的同时降低总体拥有成本(TCO),就成了关键问题。

以东软智慧医学影像信息系统 PACS/RIS 为例,该系统提供了覆盖检查预约、到诊排队、用药管理、检查管理、影像诊断等在内的一体融合全医学影像管理能力,可辅助医生更好地开展工作。东软在新一代的 PACS/RIS 产品中,就采用了基于 CPU 的方案运行三维可视化、AI 推理等工作负载。

在三维可视化加持下,融合影像分析等技术,让医务人员通过旋转、缩放、分割、图像增强等操作,从多角度清晰了解到医学影像中各结构之间的空间位置关系,在疾病诊断的可视化、术前评估、手术规划、手术实时指导等方面发挥重要价值。

要知道三维可视化、AI 推理都是非常吃硬件性能的,好在经过指令集、软件等方面做性能优化后,东软将 PACS/RIS 系统的三维可视化效率提升达 2.45 倍,AI 推理性能提升高达 8.49 倍,并有效地控制了成本。

到这里看似圆满结局了,但其实过程中还有更多的细节更值得关注和借鉴,比如系统性能是如何优化提升上去的,CPU 又为什么是破局的关键?

性能如何搞上去?

东软集团相信大家并不陌生,作为中国第一家上市软件公司,在医疗健康领域已深耕多年。

这次他们之所以选择英特尔当合作伙伴,正是因为在三维可视化和 AI 推理这两大性能杀手面前,第五代英特尔® 至强® 可扩展处理器拥有两大法宝:

OpenMP 与 SSE4 指令集(Streaming SIMD Extensions 4),和英特尔® AMX 加速器。

首先来看三维可视化部分。

东软主要采用了体渲染(Volume Rendering)技术,通过 OpenMP 与 SSE4 指令集支持光线合成的实现。

SSE4 指令集不仅扩展了 Intel® 64 指令集架构,还加入了图形、视频编码及处理、三维成像等方面的指令,使涉及音频、图像和数据压缩算法的应用程序性能大幅提升。

为了找出执行三维可视化任务时,其产品在部分应用中性能不足的瓶颈所在,东软使用了英特尔提供的 VTune™ Profiler 工具,最终确定了瓶颈函数 SafeGradz。该函数主要利用 SSE4 指令集进行三线性插值,从而实现光线上点的梯度计算。通过对该函数的代码进行优化,东软成功提升了三维可视化应用的性能。

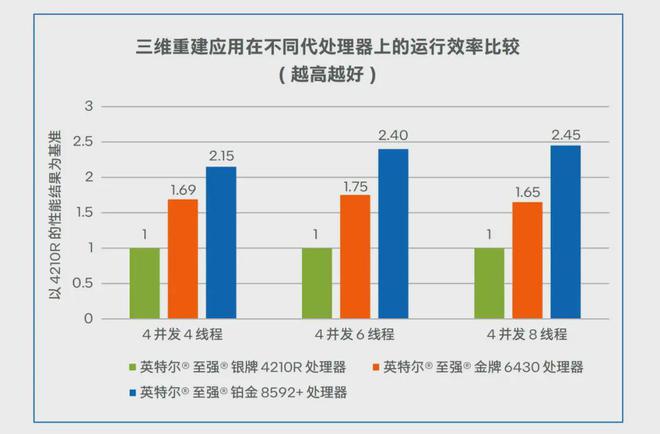

在不同代英特尔® 至强® 可扩展处理器上进行测试,结果显示,在处理器开通 4 并发 8 线程时,第五代英特尔® 至强® 铂金 8592+ 处理器的三维重建效率,相比第二代的英特尔® 至强® 银牌 4210R 处理器提升达 2.45 倍,让三维影像的交互更加流畅顺滑。

△PACS/RIS 系统的三维重建应用运行效率比较

值得注意的是,第五代英特尔® 至强® 铂金 8592+ 的主频为 1. 90 GHz,比第二代英特尔® 至强® 银牌 4210R 的 2. 40 GHz 主频还要低。

更进一步说明了,性能提升靠的不是主频提升,而是靠适合工作负载的指令集和各种优化工作。

接下来看 AI 推理部分,同样用这两款 CPU 做对比。

东软借助处理器内置的英特尔® AMX(高级矩阵扩展)技术,让 CPU 也能轻松驾驭深度学习任务。

英特尔® AMX 针对广泛的硬件和软件进行了优化,在前代 VNNI 和 BF16 技术的基础上,进一步增强了矩阵计算能力,最大限度地利用计算资源,改善高速缓存利用率,避免潜在的带宽瓶颈。

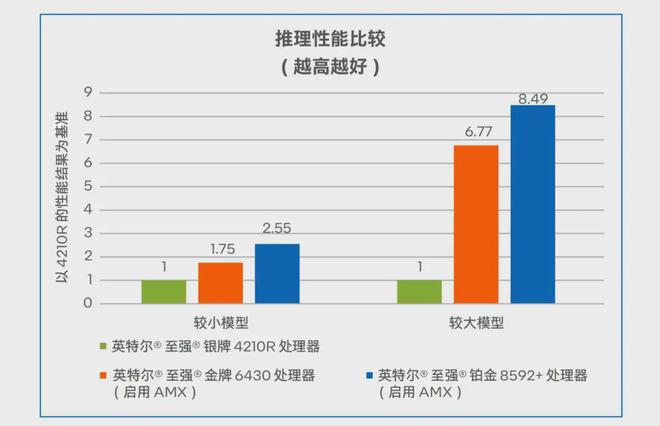

东软在第二代/第四代/第五代英特尔® 至强® 可扩展处理器上,测试了不同参数规模的 AI 模型在同步和异步模式下的推理表现。

测试数据显示,对于参数量为 31,185,568 的较大模型,在 BF16 精度和异步模式下,第五代英特尔® 至强® 铂金 8592+ 处理器相比第二代英特尔® 至强® 银牌 4210R 处理器,推理性能提升高达 8.49 倍。这意味着 AI 辅助诊断能以更快的速度为医生提供洞见。

△BF16 精度下的异步推理性能比较

之所以选择第五代英特尔® 至强® 可扩展处理器,除了其本身性能够强之外,还有一些额外的好处。

比如辅以英特尔提供的 OpenVINO™ 工具套件优化和部署各类模型,还可跨英特尔® 硬件扩展计算机视觉和非视觉工作负载,从而大幅提高性能,达到软硬协同的效果。

又比如第五代至强® 与上一代产品在软件和平台上兼容,因此在部署新系统时可以大大减少测试和验证工作。

在减少测试和验证这里,其实也起到一些节省成本的效果了。

不过在省钱这件事上,除了与具体技术优化相关,还有更多行业经验可以分享。

成本怎么打下来

其实医疗行业在选择硬件这件事上,CPU 早已成为各大玩家们眼中的“香饽饽”。

原因也是很简单,GPU 固然在性能方面存在一定的优势,但“硬伤”也是比较明显,那便是成本过高。

并且从宏观角度来看,大模型的火热确实催动了 GPU 需求的激增,在训练阶段尤甚;但现如今到了以推理为主的阶段,如何能让 AI“快好省”地用起来成为了关键点。在部署时盲目堆 GPU 不仅可能会造成算力过剩,出现“大炮打蚊子”的现象,更是会导致成本的“水涨船高”。

而诸如第五代英特尔® 至强® 这样的高端 CPU,不仅能够很好地跟上性能的脚步,在成本的控制方面也是给出了满足成本条件的更加可行、更符合实际的方案。

一言蔽之,高性价比才是关键中的关键。

其次,CPU 也算找准了“赛道”——部分医疗场景的 AI 推理具备批处理特性,对 AI 推理时延性能不敏感,更适合采用 CPU 进行推理。

具体到性能方面,第五代英特尔® 至强® 的“打开方式”是这样的:

- 整体性能提升:21%

- 推理性能提升:42%

- 内存速度提升:16%

- 三级缓存提升:2.7 倍

- 每瓦性能提升:10 倍

也正因如此,第五代英特尔® 至强® 在处理多样化的任务负载时,可以显著提升每瓦特性能,尤其在人工智能、数据中心管理、网络操作和科学计算领域,而且还能显著降低总体拥有成本(TCO)。

而这也还仅是东软等医疗行业选择 CPU 的原因之一,广泛的兼容性和成熟的技术也是不可忽视的。

众所周知,CPU 技术的发展相对来说较为成熟,几乎所有软件应用和操作系统都能在 CPU 上良好运行。

而在医疗行业中,存在大量基于传统架构开发的软件,这些软件通常设计为在标准的 CPU 上运行。因此,使用 CPU 可以确保与现有系统和软件的广泛兼容性。

其次,CPU 易于维护和升级也是重要的一点,而 GPU 在这方面会显得更为复杂。医疗行业依赖于稳定运行的系统来保证服务的连续性,因此更倾向于选择维护简便、升级路径明确的硬件解决方案。

加之 CPU 早已在医疗行业上岗,广泛用于电子病历系统、医院资源规划系统等,培养出成熟的技术团队,也建立了完善的采购流程。

因此,为什么医疗行业青睐于 CPU、为什么越来越多的人会选择 CPU 做 AI 推理,也就不难理解了。

在这一点上,或许也正应了英特尔 CEO 帕特·基辛格曾经表达过的观点:从经济学的角度看推理应用的话,很多客户并不需要高端的 GPU 设备,因为它成本太高、耗电太多,并且需要构建新的技术架构,增加 IT 设施,一切都是全新的挑战。

如果我能在标准版的英特尔芯片上运行 AI 应用且满足需求,就不会出现这些问题。

能用起来才是硬道理

如果说东软选择第五代英特尔® 至强® 这件事是一个“点”,它其实能够带出来的是一个更大的“面”——

技术,需得广泛用起来,这才是硬道理。

诚然现在是以大模型为主流的时代,但回看 2023 年至今的发展,其实也是在印证着这一点。

起初大模型的发展先是掀起了以训练为主的百模大战,而后又迅速转向了推理阶段,也就是技术要落地。

到了今年,这一趋势也是越发明显,不论是 OpenAI、谷歌等巨头,还是乘 AIGC 东风起家的初创,都在发力于如何让 AIGC 更好地用起来。

一言蔽之,现在已然是应用为王的阶段。

而要让前沿技术做到真正落地,就必须要在性能和成本之间做好平衡;或许这也正是近期国内大厂们掀起疯狂“价格战”的原因之一。

但无论 AI 如何发展,算力,永远是绕不开的一个话题。

因此,站在现在这个“AI 一日,人间一年”的时代,纵使技术日新月异,要想让它们广泛被用起来,性能和成本之间的这杆秤,需是得从最底层的基础设施抓起。

而东软和英特尔的合作模式,是一个可以值得借鉴的“范本”了。

最后让我们打个小广告:为了科普 CPU 在 AI 推理新时代的玩法,量子位开设了《最“in”AI》专栏,将从技术科普、行业案例、实战优化等多个角度全面解读。

我们希望通过这个专栏,让更多的人了解 CPU 在 AI 推理加速,甚至是整个 AI 平台或全流程加速上的实践成果,重点就是如何更好地利用 CPU 来提升大模型应用的性能和效率。

参考链接:

[1]https://www.intel.cn/content/www/cn/zh/artificial-intelligence/neusoft-pacs-ris-solution.html

[2]https://www.intel.cn/content/www/cn/zh/artificial-intelligence/ai-guidebook-healthcare.html

[3]亿欧智库《2023 年中国人工智能医学影像产品生态路线研究报告》https://www.iyiou.com/analysis/202401101048186