新智元报道

编辑:乔杨桃子

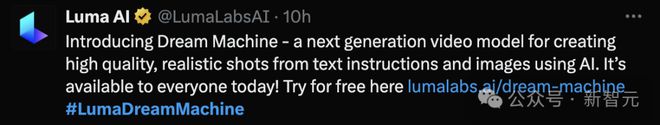

继 Pika 宣布上新 2.0 版本后,视频生成领域又有新模型加入。成立于 2021 年的 Luma AI 今天刚刚官宣了文生视频/图生视频模型 Dream Machine,而且提供免费使用 API,高质量的生成效果获得了很多网友的好评。

视频生成领域,又添一员猛将!

就在今天,Luma AI 首发了自己的视频生成模型 Dream Machine,可以通过文字或图片生成高质量的逼真视频。

更重要的是,API 对全球免费开放!进入官网后用谷歌账号登录即可马上试用。

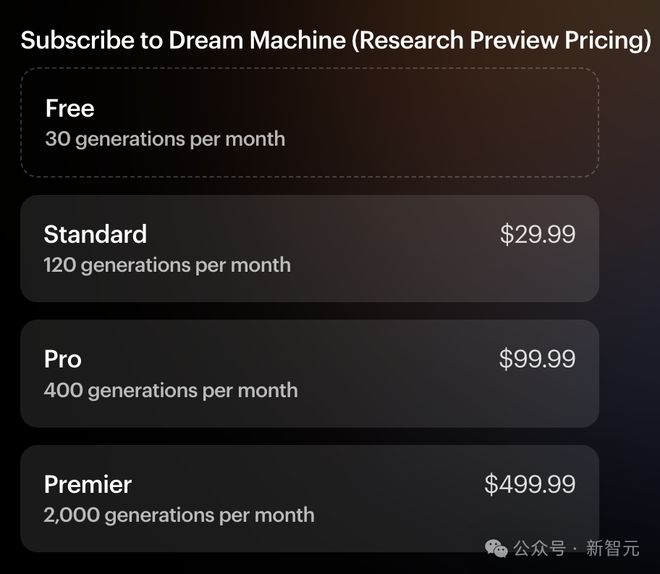

每个用户每月有 30 次免费生成的额度,但比较遗憾的是,每条视频时长只有 5 秒。

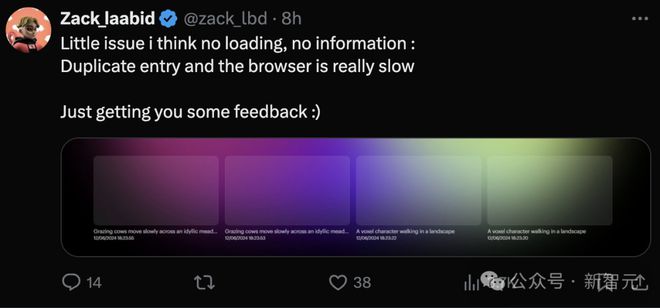

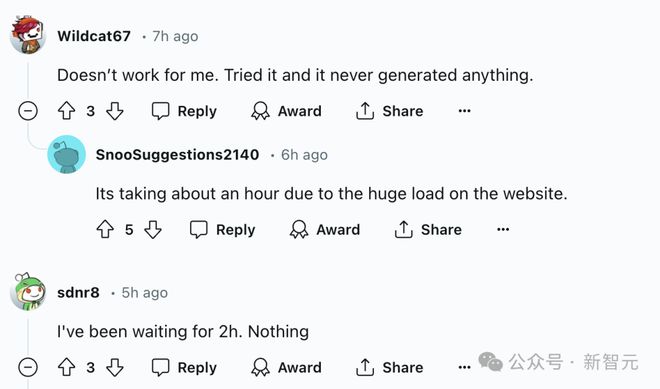

免费试用的消息一出,热情的网友们纷纷挤入服务器,结果发现 Luma AI 囤的算力好像不够,于是开始了一场漫长的等待。

刚发布后,有些人等了 2 个小时还没生成出来,Reddit 社区中一片怨声载道。

果不其然最后「真香」了,这个视频质量是值得等一会儿的。

接下来,看看这个「造梦机」究竟有多疯狂?

电影级画质,逼真感拉满

官方放出的 demo 涵盖了各种不同风格和题材的视频,能感觉到最突出的特点就是「电影感」拉满。

不仅有比较好的连贯性,镜头的艺术感也非常不错。

此外,demo 还单独强调了一些模型能力,比如生成各种动态以及具有表现力的人物。

不得不说,Luma 的审美真的在线,视频中的小姐姐都有一种超模般的「高级美」。

下面这个黑白色调的仰拍镜头,人物动作自然丝滑、一气呵成,裙摆飞起时的幅度虽然有些夸张,但还在可接受范围内。

最重要的是动作符合自然规律,没有出现「手臂融化」、「膝盖外折」这种神奇情况

下面这个 demo 可以让日漫迷们浅浅兴奋一下,不仅风格对味儿,而且镜头很有意境,可以开始幻想「人均新海诚」了。

比官方 demo 更精彩的,是各路大神网友们的脑洞创意。

比如在人眼中嵌入一个手绘地球仪。

原本需要几千个高斯点染图的工作,一个 Dream Machine 就能瞬间完成了。

Sora 发布时,很多人惊叹于模型对于光影效果的理解,Dream Machine 在这方面的表现也很不错。

这位网友用自己拍摄一张的照片作为提示,生成出来的视频可以延续之前的光感,丝毫不会割裂。

将世界名画《带珍珠耳环的少女》输入给 Dream Machine,就可以让艺术史上这位著名模特瞬间「复活」。

但是模型似乎有它自己的想法和审美,比如视频后半段自行更改了模特的相貌和头巾材质,感觉从 17 世纪的荷兰少女无缝衔接到 21 世纪T台。

之前在视频生成模型中很少见到的风格,Luma 也搞出来了。

比如下面这个 demo,狠狠拿捏住了好莱坞老电影的感觉。

提示:意大利黑手党家族站在桌子周围,一边抽雪茄一边数黄金和金钱

但槽点也不是没有,比如香烟的烟雾扩散似乎不够自然,而且没有遵守提示中的「站在桌子周围」(可能是黑手党老大只会坐着吧)。

专业创作者们放出的 demo 更加惊艳。

Reddit 上放出了一段时长 10 秒的 4K 视频,作者用 MidJourney 生成的图片喂给 Dream Machine。

没有经过换脸或变速处理,一条很有质感的预告片素材就生成出来了。

虽然主角的表情几乎没什么变化,但环境和皮衣质感的渲染非常到位,五官和额头的皱纹也比较自然。

这位创作者更是重量级,他借助 Luma 的工具生成了一条超过 1 分钟的视频,作为自己电影项目的宣传片。

来欣赏大片级别的模型应用 demo——

视频地址:https://www.163.com/dy/article/J4IMRCAP0511ABV6.html?spss=dy_author

只看视频,你能判断出这里面有 AI 模型的参与吗?

作为勇敢拥抱 AI 浪潮的急先锋,这位创作者不仅借助 Dream Machine 生成视频,还使用 Udio 制作配乐,「没有什么是比 AI 视频更颠覆性的时刻了」。

https://x.com/cfryant/status/180092390443913626 7

亲测史密斯吃面

看了这么多 demo,有比较严谨的 Reddit 网友坐不住了。模型都放出来了,应该跑下基准测试吧——

哪个好心人帮忙生成下 Will Smith 吃面条?

「唯一的真实基准测试。」

已经等不及的小编决定自己动手,成果如下——

没想到 Dream Machine 虽然不太爱听指令,但还挺有幽默感的。在其他模型中还没见过因为吃不到面条气成这样的 Will。

如果输入更详细的指令呢?

面条的形态也很自然,但手指似乎不太对劲,但更明显的问题是,Will 吃着吃着居然变脸了。

如果直接将这张图片输入给模型,能否解决变脸的问题呢?

很遗憾,似乎并没有。

AI 视频三大王者 PK

那么相比 Pika、Sora 等同行竞品,Dream Machine 的性能究竟是个什么水平?

有试用者大胆宣称,Luma 是目前我们见到最好的模型!

毕竟 Sora 还没公开,没有人能准确评价其实力。但大家似乎都认同,Luma 的表现要优于 Runway 和 Pika。

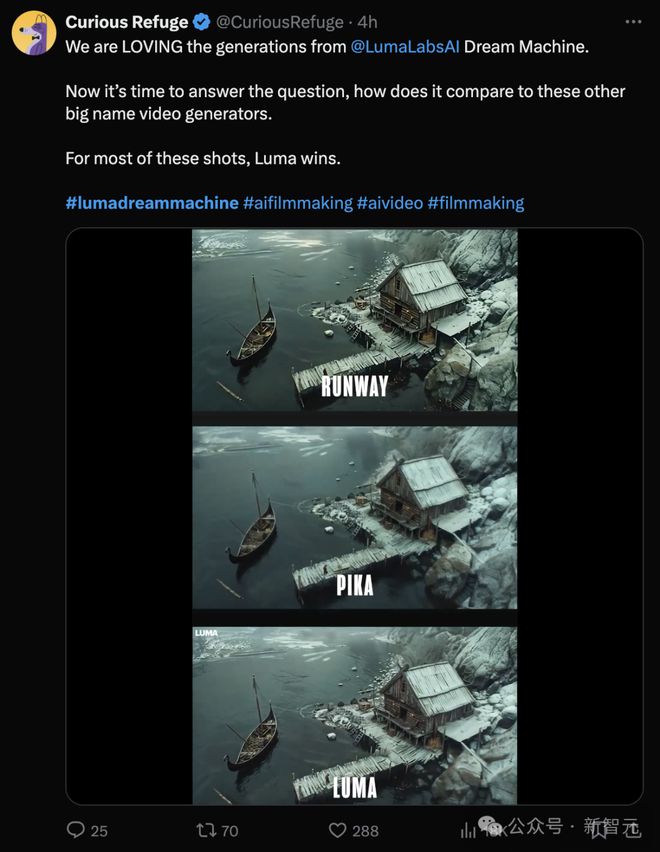

甚至还有 Luma 真爱粉在推特上直抒胸臆。通过输入相同的提示对比 Pika、Runway 和 Dream Machine 三个模型,他认为最终还是 Luma 赢了。

从完整视频中可以看到,三个模型都可以生成和渲染很高质量的画面。

但 Luma 模型之所以「电影感」更强,一方面是似乎有更丰富的「想象力」,能脑补出更多表情和动作;

另一方面则是源于更自然的镜头节奏,人物的行动速度适中,既不过快,也不过慢。

视频地址:https://www.163.com/dy/article/J4IMRCAP0511ABV6.html?spss=dy_author

刚刚发布半天,网上似乎就充斥着对 Dream Machine 的溢美之词,但这并不代表模型生成的视频已经完美无缺了。

Luma 官网上就非常坦诚地放出了很多有缺陷的 demo,表明他们今后计划的改进方向。

比如刚才 Will Smith 吃面条的视频中出现的「变形」,不仅人脸会有,跑车也会有。

更惊悚的是,在水中游泳的北极熊会突然从身后长出另一个头。

此外,其他模型存在的问题,Dream Machine 也没能幸免,比如有时会生成错误的文字,或者没能实现想要的动态效果。

而且小编在尝试官方推荐的文本 prompt 时,还偶遇了模型的「精分」现场。

输入下面这个 prompt,可以得到官网同款的惊艳 demo:

Low-angle shot of a majestic tiger prowling through a snowy landscape, leaving paw prints on the white blanket 一只雄壮的老虎在雪地中徘徊的低角度镜头,在白色的雪地上留下了爪印

但视频后半段就突然画风一转,不仅虎爪的形态不自然了,变脸的程度甚至达到了「惊悚」级别。

虽然有诸多不足,但是 Luma 能在官网上坦然放出缺陷 demo,并放出了一系列「未完待续」的动图,暗示着下一步的更新很可能就在不久之后。

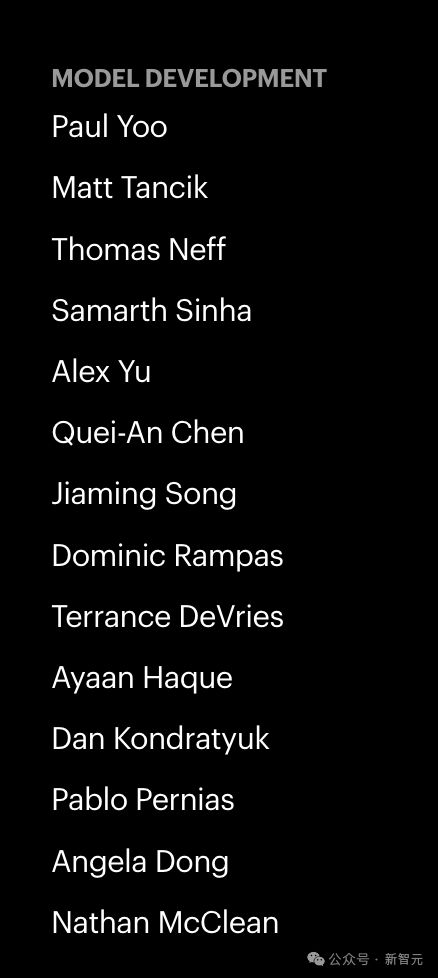

背后团队,5 位华人

发布模型的同时,Luma 也公布了模型开发团队的名单。从名字来看,14 人中应该有 5 名华人成员。

其中,Alex Yu 是公司联创兼 CTO。他毕业于加州大学伯克利分校,曾在 Adobe 工作,研究方向是神经渲染和实时图形领域。

Yu 在 2021 年毕业后,就和另一位创始人 Amit Jain 创办了 Luma 公司。

Jain 在学校修读的是物理和数学学位,曾在苹果工作,在 3D 计算机视觉、机器学习、系统工程和深度技术产品方面有丰富经验。

根据 crunchbase 的数据,Luma AI 已在 3 轮融资中筹集了 6730 万美元,最新一轮融资是今年 1 月 9 日通过的B轮融资,最新的投资方包括英伟达公司。

参考资料: