主旨演讲:Aditya Ramesh |OpenAI Sora 及 DALL·E团队负责人

对话嘉宾:谢赛宁|纽约大学助理教授

关键信息:

-

语言将是获得更智能系统的重要组成部分。

-

通过学习压缩图像,模型学会了视觉世界的基础结构,并最终获得了良好的图像表示。

-

现有的数据可能已经足够让我们走得很远。

-

当模型足够强大,能够成为自己的世界模拟器时,会发生很多有趣的事情。

-

发布强大的视频生成系统时最关心的是安全性及其对社会的影响。我们希望确保在发布 Sora 模型时,人们不会用它来传播虚假信息,并且模型的行为在预期范围内。

速记全文(中文):

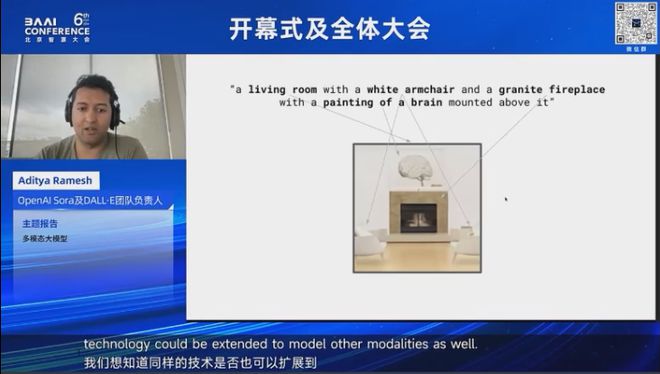

使用 Transformer 进行语言建模取得了相当不错的成果,我们希望将同样的技术扩展到其他模态的建模中。最终,我们成功地开发了一个模型,能够将标题作为输入并将其转化为量化的图像块,其工作方式类似于普通的语言模型对提示进行建模。此外,我们还为图像训练了一个 BPE 自编码器。图像的块与用于建模文本的普通词汇进行增强,整个展开的字符串被单个 Transformer 建模为一个序列。

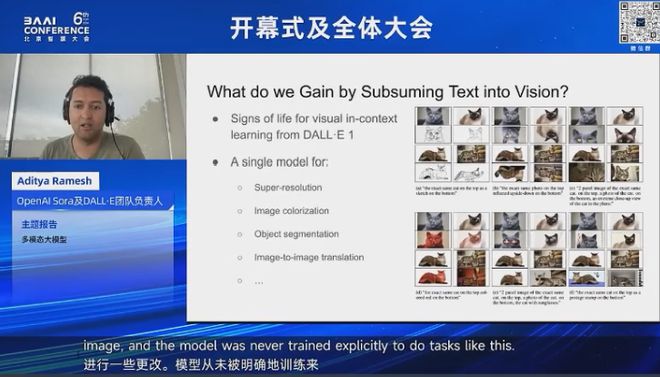

令人惊讶的是,我们发现 DALL-E 的扩展效果与我们在语言模型中看到的扩展效果相似。最初,如果训练一个小规模的自回归图像模型,你可以看到光照和反射、重复的对象以及在小规模上为物体着色的能力;然后在稍大规模上,你可以绘制具有多个属性的物体,改变艺术风格等等。一旦增加规模,你可以看到诸如文本渲染、组合泛化以及图像的上下文学习的迹象。

我们尝试给 DALL-E 进行 Raven 的渐进矩阵测试,这是一种视觉智商测试。模型会看到网格中的第一个元素并填充最后一个角落。我们还尝试了图像到图像的翻译,即给模型上半部分的图像并让其在下半部分绘制内容。这些尝试在参数达到十亿时有时会成功。

因此,我们想知道,如果进一步扩大规模会发生什么?之后,我在想这是否是学习智能的好方法,因为你是在训练一个模型来压缩视觉世界中的所有像素?这似乎是一项非常困难的任务,有太多的信息需要建模。有一些研究表明,这并不是理想的方向。

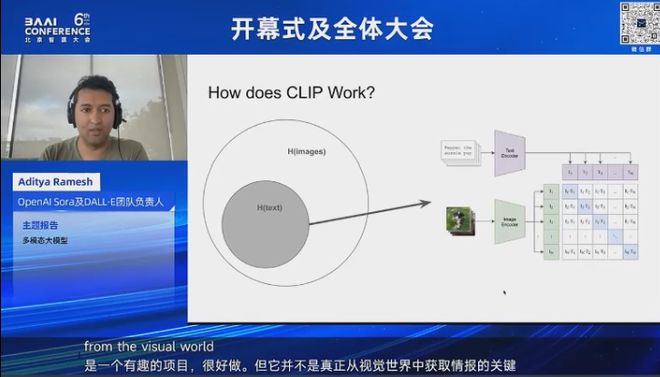

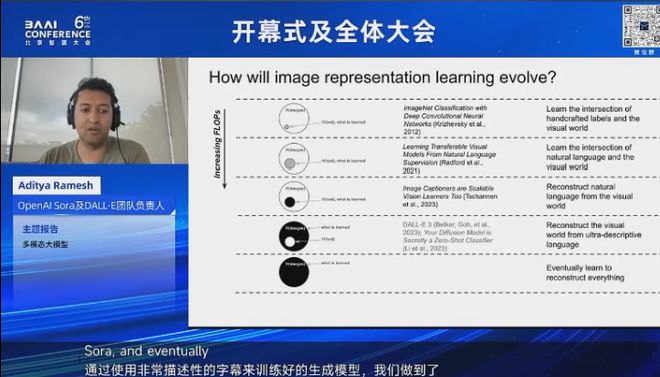

Marc 之前训练了 iGPT,这是第一个大规模自回归 Transformer 图像模型。这个模型没有基于文本,但有趣的发现是,通过学习压缩图像,模型学会了视觉世界的基础结构,并最终获得了良好的图像表示。例如,随着 iGPT 模型的扩展,它们在 ImageNet 探测中开始表现良好。然而,这远没有 CLIP 高效,CLIP 与 DALL-E 1 的出现几乎同时。CLIP 的理念是学习文本和图像交集处的内容。如果你想象一个文本和图像的维恩图,CLIP 使用对比损失来学习两者交集的信息,这比 iGPT 从图像中提取智能的效率高出几个数量级。因此,我当时的结论是,DALL-E 1 是一个有趣的项目,工作也很不错,但它并不是真正提取视觉世界智能的关键路径。

接下来,我会讲一点关于 CLIP 如何工作以及它如何提取图像和文本交集处的信息。我相信你们中的很多人已经对这些有所了解,但 CLIP 学习了一个图像编码器和一个文本编码器。文本编码器接受一个提示,图像编码器接受一张图像。在训练期间,CLIP 模型会获得一组带有标题的配对图像。文本编码器编码所有标题,图像编码器编码所有图像,损失函数鼓励两个编码器匹配每个图像及其关联标题的表示。

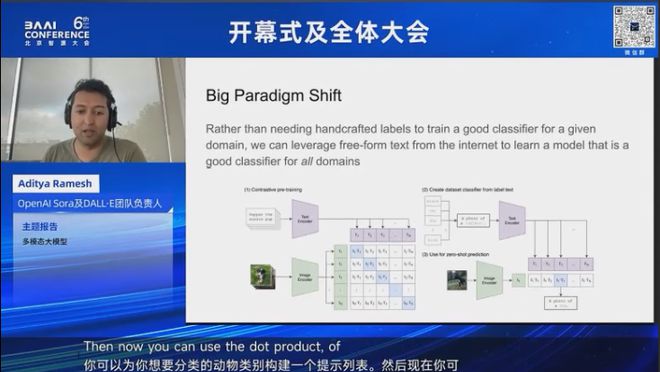

CLIP 的出现标志着范式的重要转变,我们不再需要手工制作标签来训练分类器,而是可以利用互联网上的重构文本来学习一个适用于所有领域的通用分类模型。例如,如果要对动物进行分类,只需构建一个待分类动物种类的提示列表,然后使用图像嵌入与所有标题的点积,并通过 Softmax 来确定图像所属的类别。

图像表示学习也在不断演变。深度学习的成功最初体现在图像分类论文中,分类器仅从图像中提取类别标签等少量信息。CLIP 的出现使得我们可以利用互联网的重构文本来学习通用的分类模型,减少了手工特征工程的需求。不久后,图像描述生成器也被证明是可扩展的视觉学习器。我们可以训练一个感知模型,该模型作为图像编码器,查看图像并重建标题,就像一个从图像学习预测文本的语言模型。

随着时间的推移,事情似乎变得越来越简单。我们可以思考,当我们的浮点运算预算增加时,我们最终会做什么?目标函数和我们从图像中学习的方式似乎已经改变。随着计算能力的增加,事情似乎变得更简单。

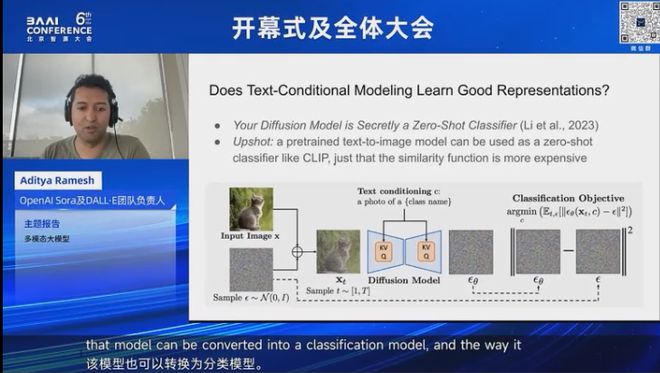

iGPT 表明,大规模生成模型自动学习数据的基础结构,最终产生良好的图像表示。类似的结果也适用于文本到图像模型。论文 "Your Diffusion Model is Secretly an An Ensemble of Classifier-Free Guidance Samplers" 的基本思想是,即使在建模给定文本的图像分布时,该模型也可以转换为分类模型。其工作原理与 CLIP 非常相似,给定图像和候选标题,可以使用扩散模型计算图像与标题匹配的评分。这比 CLIP 更昂贵,但其工作方式类似,即在图像和候选标题之间提供兼容性或相似性评分。该论文表明,实际上稳定扩散能够获得良好的 ImageNet 探测结果 。

现在,这使我们能够从一个模型基于图像学习文本的范式转变到一个模型基于文本学习图像剩余信息的范式。但不清楚这样做是否有效,或者我们需要花费多少额外计算来做到这一点。

在研究 DALL-E 时,我们发现训练一个文本到图像生成模型在使用更具描述性的标题时变得更高效。如果用非常描述性的标题训练模型,那么训练更短标题的性能也会更好。这表明,也许我们可以通过使用语言作为支架来获得更好的无条件模型。

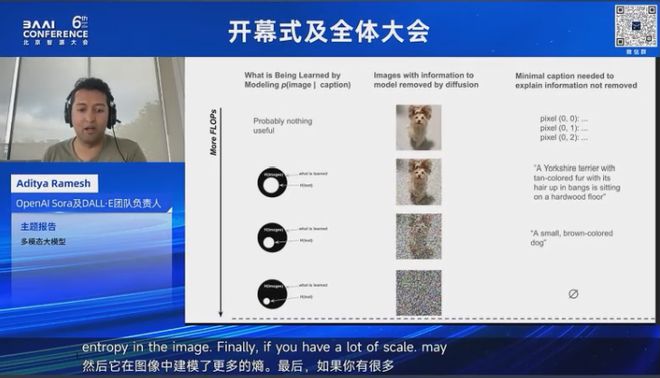

直观地说,如果图像中没有噪声,并且你想解释图像中的所有内容,那么你会用一个描述每个像素颜色的简单标题来做到这一点。如果你想象训练一个获得如此描述性标题的文本到图像模型,图像中没有不确定性,因为它可以直接读取像素值并渲染它们,不需要深度学习。

如果你在图像中添加一点噪声,那么模型需要学习的内容很少,比如表面细节和纹理等。所以现在有一些不确定性,已经确定的不确定性可以通过一个非常描述性的标题来解释。如果你向图像添加大量噪声,那么不确定性会增加,为了解释图像中剩余的信号,只需要一个简短的标题。最终,如果你向图像添加大量噪声,模型必须学习所有内容,并且没有标题与纯噪声一致,因为任何事情都是可能的。

所以我们在每个阶段学到了什么?如果你有一个仅学习像素值到图像转换的模型,它可能没有学到任何有用的东西。如果你有更多的计算资源,你可以学习一个将非常描述性的标题转换为图像的模型。直观上,它可能没有学到很多,因为你给它的标题非常描述性,图像中没有太多不确定性供它学习。如果你有更多的计算资源,你可以期望模型即使在短标题下也能工作。所以现在标题对模型的指导减少了,它在图像中建模更多的不确定性。最后,如果你有大量的计算资源,也许你可以在没有任何条件的情况下建模图像的不确定性。

这个想法是,也许在超描述性标题上进行训练是一种帮助在小规模上优先处理感知相关位的方法。你可以期望从训练非常描述性的标题中获得的迁移到训练简短标题上,这样最终你可以扩展模型,在小规模上希望它在你给它非常描述性的标题时仍然是一个好的图像生成模型。在大规模上,它可以学习那些无法用语言轻易描述的内容,并填补剩余的空白。这表明,也许我们可以从学习在图像中建模文本转向学习在文本中建模图像,而在计算效率方面可能不会受到太大影响。最终,如果你在非常描述性的标题上扩展模型,我们有一些证据相信,无条件建模任务的性能也可能会提高。

随着时间的推移,我们对模型训练方式的思考发生了变化。最初,我们试图通过固定数据集并找到更好的目标函数和架构来改进感知。但最近,趋势有所转变,我们固定了目标函数和模型架构,目标函数只是一些简单的最大似然,模型架构只是 Transformer。我们将专注于数据集的攀登,即我们如何建模我们试图重建的内容,例如使用更描述性的标题,我们如何优先学习数据中的内容。

最初我们从图像中建模文本,现在我们从文本中建模图像。随着计算能力的增加,语言的作用似乎被视觉所取代。我们在 DALL-E 1 中看到一些有趣的事情,例如风格迁移。你可以拍摄一张图像,并使用 CLIP 嵌入算术来对图像进行某种变化,保留所有其他细节,但只改变一些内容。在 DALL-E 1 中,我们看到视觉上下文学习的迹象,在足够大的规模下,你可以给模型一个上半部分的图像,并让它在图像的下半部分绘制内容,并对上半部分的图像应用一些变化。模型从未明确训练过执行这种任务,但在足够大的规模下,它最终学会了这些。

当时,这感觉像是一种通用界面,用于所有类型的图像操作任务。现在我们开始获得可靠的视频生成模型,这表明将来我们可能只需向模型展示我们已有的图片,并要求它生成一个我们想要的视频。这表明,也许学习压缩所有内容确实是正确的方法,而语言只是使其实际可行的必要支架,可能最终并不充分。为了高效地训练视频模型,我们可能需要其他技巧,通过重建我们看到的一切,但似乎语言将帮助我们达到目标,最终可以被视觉智能所取代,最终这将为我们提供一个通用的界面来模拟我们想要的任何内容。

1

问答环节

问:你曾说过语言模型被高估了。你能详细谈谈吗?你认为你的生成技术会成为 API 的关键路径吗?它会引导我们走向彼此吗?你如何看待建模人类语言与建模丰富的感官现实之间的关系?

答:我绝对认为是的。任何视频中都有大量信息,很多视频信息不能轻易通过语言表示。例如,我谈到 Raven 的渐进矩阵,有些类型的智能可以通过视觉学习,而仅通过学习语言很难建模。所以我认为语言将是获得更智能系统的重要组成部分,这些系统能够推理。但在某个时刻,我认为我们将语言纳入视觉,这是一个更通用的界面。我确实认为,能够模拟你想要的任何内容将是未来的一个重要里程碑。

问:你如何确保语言不会成为捷径?因为它提供了一个非常强的先验,可能只是补偿了我们当前表示的缺陷。你对此有何看法?

答:是的。我认为当你用非常描述性的标题训练文本到图像模型时,它没有太多需要学习的内容。但我们在 DALL-E 中看到,当你用非常描述性的标题训练模型时,短标题的性能由于接受了更长标题的训练而有所提高。所以方向上,这使我们认为也许我们可以使用语言来训练生成模型,并帮助提高训练效率。但随着规模的增加,模型对语言作为条件信息的依赖减少,并开始自己搞清楚东西。

问:开放 AI 或你的团队在这种文化背后有什么秘诀,让年轻研究人员能够真正发挥他们的激情和经验,做出这样的贡献吗?

答:我认为开放 AI 有几件事使这种情况成为可能。一个是我们的招聘策略,这与其他组织有所不同。我们更关注那些有潜力但可能没有机会获得正式学术信用的人。第二个是我们专注于一个长期的研究目标,而不是受日常或每月变化或领域进展的影响。最后,我认为拥有大量的 GPU 也有帮助。

问:你对高等教育的现状有何看法?你认为博士学位也被高估了吗?你对想在人工智能领域追求职业的下一代研究人员有何建议?

答:因为事情正统一到一个单一的范式,我们有一个可扩展的架构,即 Transformer,我们知道它们如何表示数据,即文本的 BPE 标记和视觉数据的补丁,事情正在趋同,计算是获得更好结果的最重要因素。这改变了你在学术界可能追求的项目的重点。我认为可解释性是一个方向,可能还关注于现有深度学习系统仍然失败的评估和任务。我认为现在做博士学位很难期望在某些领域获得最先进的成果,因为所需的资源比过去多得多。

问:你如何看待视频生成领域的竞争?我们是否期望从 Sora 中看到一些新的更新?

答:我认为我们在发布强大的视频生成系统时最关心的是安全性及其对社会的影响。我们希望确保在发布 Sora 模型时,人们不会用它来传播虚假信息,并且模型的行为在预期范围内。我认为这需要大量的工作来确保模型的安全,以便能够有信心地发布。

总的来说,我认为有竞争是件好事,看到其他实验室和公司也在发布视频生成模型很不错。我认为有更多的人在不同的方法上工作会促进创造力。

问:我认为时间快到了,也许我可以用一个关于创造性世界的问题来结束。你参加了纽约的 AI 电影节,我问所有的艺术家和电影导演一个问题:你最需要视频生成模型的什么功能?出人意料的是,他们都说控制性或更好的控制性。我想知道这是否是 Sora 的下一个版本会关注的内容,或者你在与不同艺术家的合作中学到了什么?你认为语言会成为创造性世界更好控制的最终界面吗?

答:是的,我在过去的演讲中谈到了语言在这些模型中的作用,我认为更好的控制性和减少老虎机效应可能是我们从合作的创作者那里收到的最重要的功能请求。我确实认为能够做到这一点,并重新利用以前场景中的角色和资产等元素,将是一个重大变革,因为这似乎是视频生成模型在制作环境中真正有用的关键因素。我认为这有点有趣,因为我提到在 DALL-E 1 中我们很早就看到了上下文学习能力的出现,现在这些能力正在走向生产。

问:我想问一个关于数据的问题。我知道 Sora 的大部分数据可能来自互联网视频,但你认为这是否足够支持通用人工智能的目标,还是我们需要发现新的数据源,甚至不同的感官媒介来帮助实现这个目标?

答:这是个好问题。我认为现有的数据可能已经足够让我们走得很远。我认为我们可以通过扩展模型继续取得很大进展,因为有大量数据可用。但是我认为当模型足够强大,能够成为自己的世界模拟器时,会发生很多有趣的事情。你可以在视频生成模型内部运行上下文模拟,这样我们可以开始从现实世界的环境中结合所有的多样性和有趣的约束,并在其中学习有趣的东西。