昆仑万维投稿

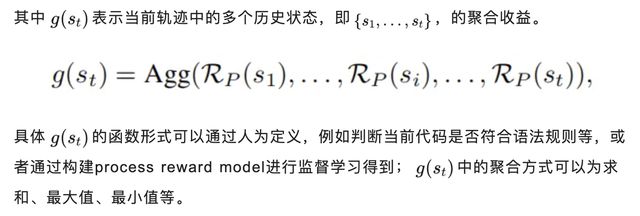

量子位公众号 QbitAI

Q*项目公开发布,可让小模型达到参数量比其大数十倍、甚至上百倍模型的推理能力。

自去年 11 月伴随着 OpenAI 内讧,其神秘Q*项目被爆出后,业内对 OpenAIQ*的讨论和猜测就没停过,而 OpenAI 这边一直避而不谈。

在当时,一些人就从名字猜测Q*可能与Q-Learning 有关,例如 Meta 科学家田渊栋提出Q*可能是Q-learning 和A*的结合:

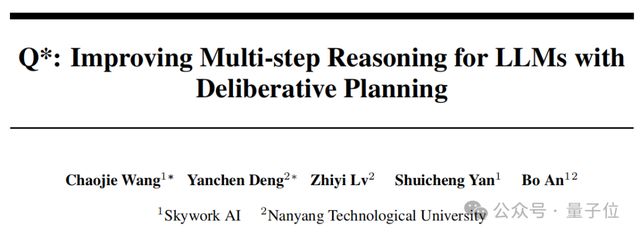

而现在,一项名为Q*的项目突然公开发布,而且真的和Q-Learning、A*有关。

不过,研究团队并非 OpenAI,更不是 DeepMind(相传,OpenAI 的Q*项目前身是 GPT-Zero,由 Ilya Sutskever 发起,名字致敬了 DeepMind 的 Alpha-Zero)。

而是来自国内昆仑万维颜水成团队与新加坡南洋理工大学的一项新工作。

团队表示,希望Q*算法能够打破 OpenAI 的封锁,提升现有开源模型的推理能力。实验中,Q*算法的表现也很给力:

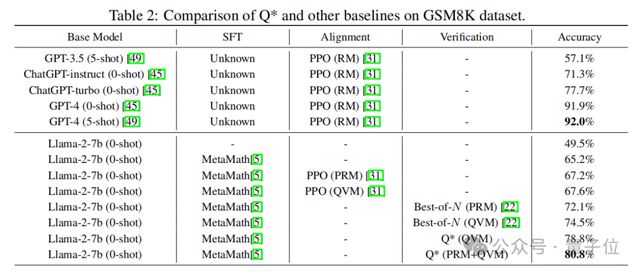

- 在 GSM8K 数据集上,Q*帮助 Llama-2-7b 提升至80. 8%的准确率,超越了 ChatGPT;

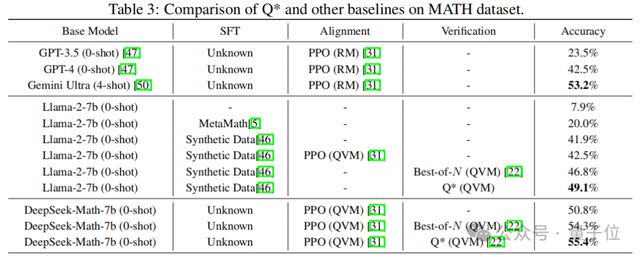

- 在 MATH 数据集上,Q*帮助 DeepSeek-Math-7b 提升至55. 4%的准确率,超越了 Gemini Ultra;

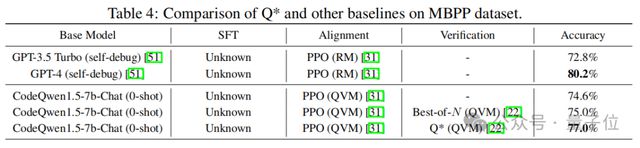

- 在 MBPP 数据集上,Q*帮助 CodeQwen1.5-7b-Chat 提升至77. 0%的准确率,缩小了与 GPT-4 的编程水平差距。

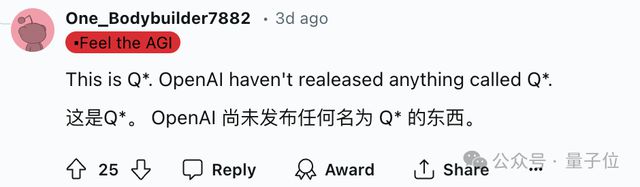

网友看到这项工作后一时间炸开了锅,研究命名无疑成为了讨论的一大焦点,网友的评论却很一致:

这就是Q*。

虽然不是那个Q*,但却是真正的Q*:

谁让 OpenAI 至今不发布任何名为Q*的工作:

抛开命名,从研究本身来讲,有网友看过论文后感叹这项研究真不简单:

越思考,就越觉得Q*的这个方法是正确的。

甚至有网友认为有种 AGI 的感觉:

那么,Q*到底长啥样?

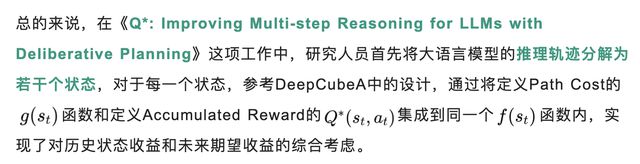

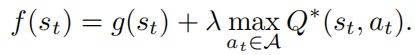

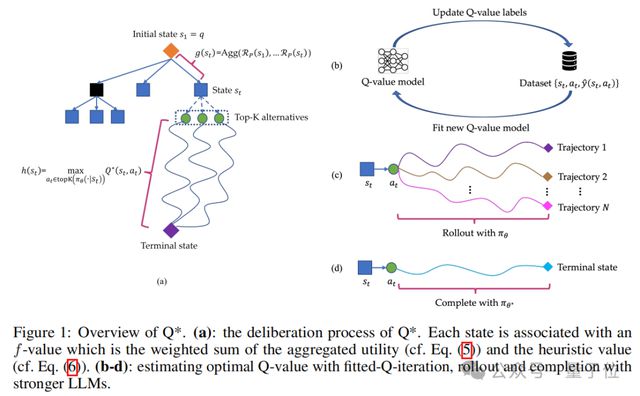

复杂推理任务全盘规划

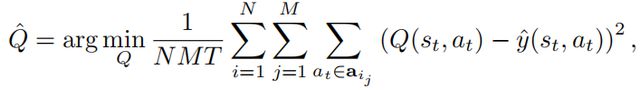

最后利用A*搜索算法对状态进行最佳优先搜索,实现了对复杂推理任务的全盘规划,从而提升开源模型在推理任务上的性能。

随后,研究团队通过一系列实验,证实了Q*框架可以显著提升 LLM 的推理能力。

如开头所述,在 GSM8K 数据集上,Q*帮助 Llama-2-7b 提升至 80.8% 的准确率,超越了 ChatGPT;在 MATH 数据集上,Q*帮助 DeepSeek-Math-7b 提升至 55.4% 的准确率,超越了 Gemini Ultra; 在 MBPP 数据集上,Q*帮助 CodeQwen1.5-7b-Chat 提升至 77.0% 的准确率,缩小了与 GPT-4 的编程水平差距。

具体结果见下图:

Q*能够帮助参数量仅为 7b 的小模型达到参数量比其大数十倍甚至百倍模型的推理能力,大幅提升模型的性能,并显著降低了计算资源的需求。

不过,昆仑万维团队也表示,Q*的研究尚在初级阶段,算法在各个环节还有进一步的改进空间。

未来,会继续深入此项研究,不断提升国产开源模型推理能力,打破 OpenAI 闭源封锁,为 AI 前沿技术发展带来全新可能。

更多细节,感兴趣的家人们可以查看原论文~