作者:DrChuck

来源:雪球

2015 年,我刚参加工作,第一个任务是识别图片里的物品。传统做法是,找到物品的特征,用机器学习设计特征工程,做成模版,拿着模版进行特征匹配。做了几个月,效果差强人意。

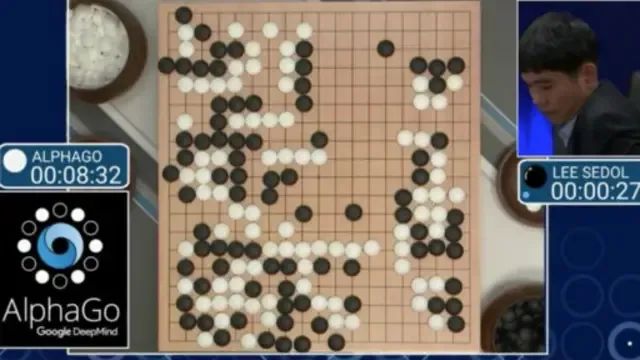

突然一则新闻吸引了我的注意力,谷歌旗下的 DeepMind 开发了一款围棋程序 AlphaGo,要与世界冠军李世石对弈。赛前大家并不看好 AI,甚至人工智能专家李开复也觉得 AI 赢不了。

事实让众人大跌眼镜,AlphaGo 以4:1 大胜李世石。这个结果给了我极大震撼,因为中国人知道围棋的难度。19 乘 19 的棋盘,状态空间复杂度高达 10 的 171 次方,远大于宇宙中原子的个数,单靠近似穷举不可能解出答案。

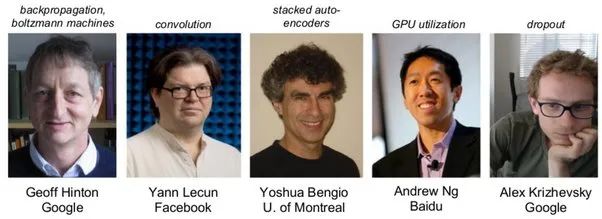

我疯了一般去寻找背后的故事。原来,AlphaGo 的核心是卷积神经网络。这是杨乐昆在 1989 年提出的一种图像识别算法。为什么这个技术在二十多年后才被人重视?因为数据和算力不足。

直到 2012 年,深度学习之父辛顿的两名学生在李飞飞主导的 ImageNet 超大规模视觉识别挑战赛上一鸣惊人,人们才终于见识到威力。他俩基于吴恩达的工作,创造性的将英伟达的 GPU 用于训练一个 600 万参数的深度神经网络 AlexNet。

AlexNet 在学习了 1000 万张李飞飞团队辛苦标注的图片后,将图像识别的准确率提高了 10% 以上,遥遥领先于亚军。

在 AlexNet 的基础上,科学家们再接再厉,提出了一个又一个更深更大的网络,ZFNet,VGGNet,GoogleNet,每年都在进步。

到了 2015 年,华人学者何恺明,曾经的广东高考状元,提出了 152 层的极深网络 ResNet,参数量过千万,至此,AI 的图像识别准确率终于超过了人类。

了解到这些背景,我兴奋得浑身发抖。开发人员再也不需要手工设计图像特征,深度网络通过海量数据学到的特征,远胜资深专家的多年经验。

为了深入学习,我开始使用亚马逊云服务 AWS,很快就被英伟达的 CUDA 惊艳到了。

CUDA 非常高效,吸引了众多研究员和工程师,英伟达的开发人员也热心解答各种 Bug 问题。渐渐的,越来越多的算法首发在 CUDA 上,更多的改进算法为了超越前者也只能用 CUDA,形成了网络效应,用的人越多越好用。

当年还没有现在这么完善的深度学习框架,我入门靠的是华人学者贾扬清在写毕业论文之余开发的 Caffe。

这位大神慷慨开源了他基于 CUDA 的研究框架,又在博士毕业后成为谷歌的 TensorFlow 和 Meta 的 PyTorch 两大当今最流行框架的主要贡献者。

有了这些武器,我总算可以把图像识别算法换成深度卷积网络,效果显著,准确率飞升。

但我知道永远不能自满,这是个眨眼十年的领域。得益于科学家们的开源精神,网络的架构不断进化。

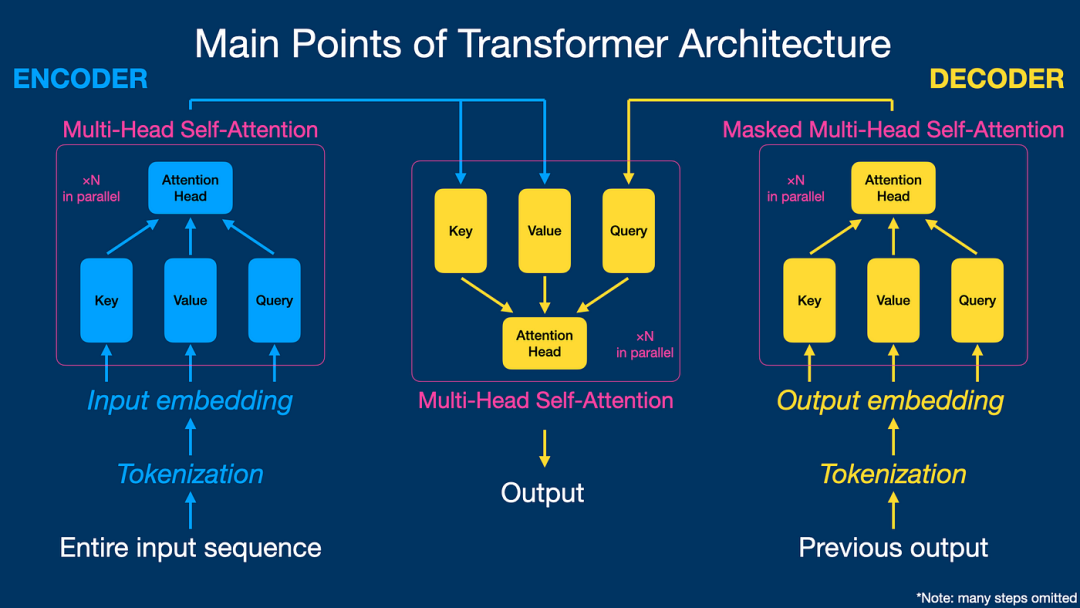

2017 年,谷歌提出了 Transformer 自注意力架构。所谓自注意力,简单说就是只关心输入之间的关系,而不再关注输入和输出的关系,这是一个颠覆性的变化。

这篇论文发布之前,虽然深度学习已经取得长足进展,但 AI 的各个分支,视觉,语音,语言理解等,还是相对割裂的,每个领域有自己的模型。

之后,则是 Transformer 一统天下,各领域专家的知识整合以及多模态融合变得愈加轻松。

李飞飞的高徒安德烈,甚至惊叹,也许人类偶然窥见了和自然界类似的强大架构,造物主沿着这个路径复制,造就了今天的大千世界。

Transformers 让 GPU 并行运算的效率进一步大幅提升,2018 年,OpenAI 和谷歌相继发布了参数量过亿的 GPT 和 BERT 模型。

2020 年初,OpenAI 发表了著名的 Scaling laws 规模法则,指出更大的模型,更多的数据,更长时间的训练是提升模型能力的可行路径。

2022 年底,ChatGPT 横空出世,参数量达到恐怖的 1750 亿,模型大到违背了许多科学家的直觉。

通常来说,如果一个模型训练几个月烧掉百万美金,效果还没有很大提升,研究员就放弃了。但伊利亚不是一般人,作为当年 AlexNet 的作者之一,他坚信规模法则,在烧了千万美金之后,终于捅破天花板,看到了推理智能的大幅涌现。

曾经,为了实现一个简单的小功能,我就需要训练一个 AI 模型。要完成一个复杂的商业系统,需要多个 AI 模型的协作,以及大量的底层逻辑代码。

但现在,借助 GPT 大模型,实现功能只需要写一句简单的提示语,生产效率大大提高了。

全世界都看到了大模型的威力,根据斯坦福大学 AI 研究院的最新报告,2023 年生成式 AI 的投资激增了 8 倍。训练模型也越来越昂贵,谷歌为了追赶 ChatGPT 开发的 Gemini 模型,成本接近 2 亿美金。大规模的金钱竞赛,成了巨头公司们的游戏。

在此背景下,依然坚持开源的英雄们,尤其值得尊敬。

著名开源社区 HuggingFace 的创始人分享了一个美妙故事,关于三大洲(欧洲,美国,中国)的人们如何合作共建并公开分享了一个紧凑高效,行业领先的 AI 模型。一个小团队在法国巴黎发布了他们的第一个模型:Mistral 7B。

该模型令人印象深刻,体积小,但在基准测试中表现出色,优于之前所有同尺寸的模型。而且是开源的,人们可以在其基础上继续开发。

瑞士伯尔尼的刘易斯和法国里昂的埃德都来自 HuggingFace 的模型微调团队,他俩在喝咖啡时聊到了这个模型:一个来自美国加州斯坦福大学的研究团队刚刚发布了一种新的方法,用这种方法微调 Mistral 怎么样?嘿,这是个好主意,另一个人答道。他们刚刚开源了一个很棒的代码库,让我们用起来吧!

第二天,他们开始深入研究 HuggingFace 上公开共享的数据集,偶然发现了两个有趣的大型高质量微调数据集,它们来自中国清华大学的团队 OpenBMB,也开放了源码:UltraFeedback 和 UltraChat。

几轮训练实验证实了这一直觉,由此产生的模型超级强大,是迄今为止他们在伯克利和斯坦福的基准测试(LMSYS 和 Alpaca)中所见过的最强模型。

开源模型排行榜的大咖克雷门汀也被吸引了,她对模型能力的深入研究证实了这一模型拥有令人印象深刻的性能。团队还邀请了康奈尔大学教授萨沙加入对话,他提议快速起草一份研究论文,整理并与社区分享所有细节。

几天后,起名龙卷风 Zephyr 的模型、论文和所有细节便席卷世人。

很快,世界各地的许多公司都开始使用它,有公司声称用它取代 ChatGPT 让其节省了一半的费用。众多研究人员在开源社区热烈讨论该模型和论文。

所有这些都在短短几周内发生的,这得益于世界各地(欧洲,北美,中国)发布的知识,模型和数据集的开放访问,以及人们在 AI 领域相互借鉴工作,为现实世界带来价值的高效理念。

开源社区的成就令人惊叹,理念更令人神往。

当 OpenAI 不再 Open,是这些胸怀技术开放理想的研究者,将大模型的秘密,展现给全世界。

进入 2024 年,大模型的进展依旧如火如荼:

1. Sora 模型通过简单描述生成栩栩如生的长视频,成为全球焦点。OpenAI 称之为世界模拟器,能深刻理解运动中的物理规律。华人学者谢赛宁揭示了背后原理,来自他发表的基于 Transformer 架构的扩散模型 DiT。很快,潞晨科技和北京大学推出 OpenSora,全面开源文生视频的模型参数和训练细节。快手公司也推出了可灵大模型,展示了图生视频和视频续写等功能,在顶级学术会议上引起积极反响。

2. 大模型的推理能力让许多互联网产品得到升级,Arc Search 加 Perplexity 的 AI 浏览器可以改善用户的搜索体验,自动整合全网资讯,给出要点,回答问题的精准度大幅提升。月之暗面的 Kimi 对话搜索引擎,被许多投资人推荐,因为其强大的文本总结能力和 200 万汉字的超长上下文窗口,让阅读上市公司财报和资料的工作不再繁琐。

3. GPT4o 展示了在文本,图像和语音上的多模态实时处理能力。上海人工智能实验室和商汤科技联合发布的书生大模型 InternLMM,开源了开放世界理解,跨模态生成和多模态交互的能力,在全球开发者社区备受欢迎。

4. 吴恩达力推智能体工作流,让 AI 学会使用工具,亚马逊的 AWS,微软的 Azure,阿里巴巴的百炼,百度的文心和字节的扣子等各大云计算平台都提供了便捷多样的插件,让 AI 如虎添翼。

5. 端侧 AI 开始落地,苹果发布 Apple Intelligence,在保护用户隐私的同时,将大模型直接部署到用户的手机里。因为某些客观因素,中国的算力受到限制,反而催生了一些另辟蹊径,以小博大的模型路线。面壁智能公司推出 MiniCPM 模型,只有 24 亿参数,性能却超越了比自己 5 倍大的巨人。

6.Mistral 开源了混合专家模型架构,由多个专家子模型组成,回答特定领域的问题只需要调用相应的,整体推理消耗大大降低。美国的 GPT 和 Claude 降价了 50% 以上,中国公司发扬卷的精神,阿里的通义千问,幻方的 DeepSeek 等领先模型直接降价 90%。各家大模型之间的竞争愈演愈烈,鹿死谁手,犹未可知。

展望未来,我是非常乐观的。虽然当今世界并不太平,各种冲突矛盾不断,但 AI 对生产力的促进是确定的。

有人担心 AI 会让很多人失业,但李飞飞认为,AI 取代的是任务,而不是工作。每项工作都由大量任务组成,让 AI 去完成繁重的任务,人类的创造力将进一步解放。

20 年前,随着生产力的提高,大部分国家开始实行一周五天工作制。在下一轮 AI 工业革命到来之际,一周休三天,也不是遥不可及的幻想。