克雷西发自凹非寺

量子位公众号 QbitAI

让大小模型相互博弈,就能实现生成内容可读性的提升!

这是来自 OpenAI 的正经研究,目标就是在保证准确率的同时,让模型输出更容易被人理解。

用这种方法训练之后,人类对模型输出的判断准确率明显增长,速度也变得更快了。

这项研究出自 OpenAI 已解散的“超级对齐”团队,模仿了多伦多大学学者与 2021 年提出的“证明者-验证者”(Prover-Verifier)博弈。

在训练过程中,OpenAI 让大模型担任“证明者”,小模型作为“验证者”,让这两种身份展开一场相互较量。

最终,大模型输出的结果不仅更易理解,自身的准确率也没有明显损失,小模型的判断水平也提高了。

甚至论文作者之一、OpenAI 研究员 Yining Chen 表示,这种方法“有可能使未来的模型比人类更聪明”。

值得一提的是,超级对齐团队原负责人、RLHF 作者Jan Leike也参与了这项研究,他离职时曾炮轰 OpenAI 不重视安全。

不过,Jan Leike 介绍这篇论文的推文最后,是给现在所在的 Anthropic(Claude 厂家)打广告招兵买马。

论文的另一名作者、OpenAI 研究人员 Nat McAleese 在推文中透露,这将是 OpenAI 的最后一篇(Final)超级对齐论文。

这一消息让一部分网友十分激动,表示这一定不是最后一篇,Nat 你还会继续做超级对齐的对吧?

让模型相互博弈

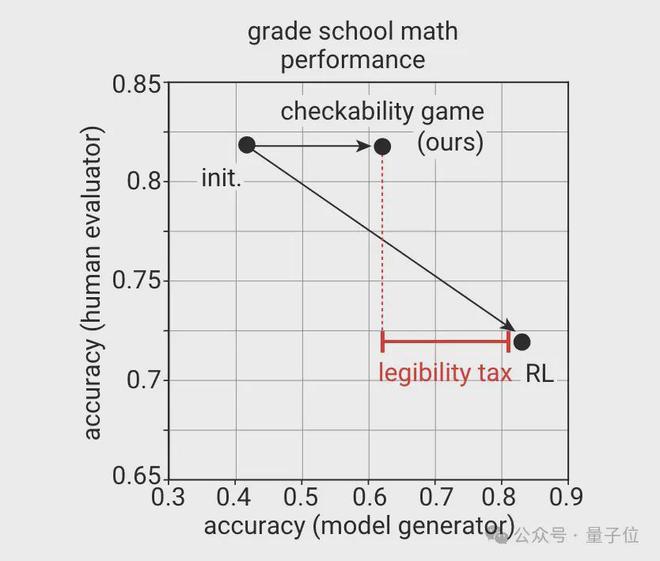

OpenAI 研究发现,大模型生成的内容,在准确性和易读性两个维度上存在一些制衡——

如果以自身准确率为目标进行优化,会导致易读性下降;如果以易读性作为目标,自身的准确率又会有所损失。

即使在简单的小学数学级别的任务上,也很容易看出其中的差距,OpenAI 将其称为“可理解性税”。

但是,人类能否理解模型生成的内容是做出准确判断的重要前提,因而对安全性也有重要影响。

即使抛开这点不谈,内容的可理解性也直接决定了模型能否给人类带来有用的帮助。

这项研究受到多伦多大学学者与 2021 年提出的“证明者-验证者”博弈的启发,通过博弈的方式训练模型。

证明者拥有强大的计算能力,能够执行复杂的计算和生成证明,任务是试图说服验证者某个陈述是正确的。

验证者则只能执行相对简单的计算,需要通过交互过程来确定证明者提供的证明是否可信。

举个例子,有一道数学题需要求解一个函数的表达式,证明者知道这个表达式(但不一定对),并希望验证者相信他的答案是对的。

而验证者知道一些自变量对应的函数值,便可以用这些信息测试证明者,通过其回答准确与否判断其知不知道正确的函数。

通过这样的方式,OpenAI 力图实现准确性和易读性的平衡,用相对较少的准确率损失换取更高的易读性。

在本项目中,OpenAI 团队使用一个了包含小学数学问题、解决方案和正确答案的数据集。

模型则选择了不同规模的 GPT-4 系列模型,规模大的作为证明器,小的则用来充当验证器。

该数据集被随机划分为两个大小相等的子集,分别用于证明器和验证器的训练。

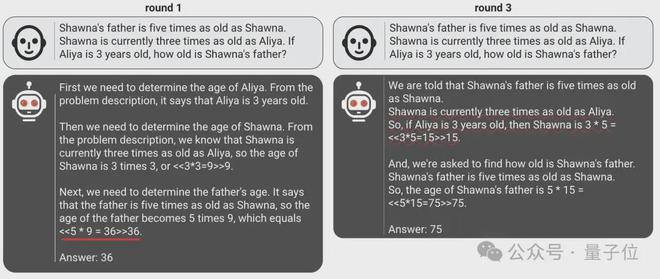

其中证明器又被分别赋予了有帮助(helpful)和奸诈(sneaky)两种角色,分别生成正确和错误的解法。

但二者的共同点是,都需要让自己的解法能够被验证器赋予高分。

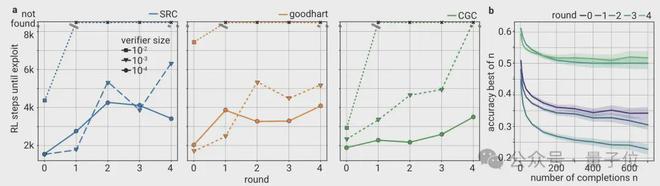

△狡诈证明器在多轮训练中的进化

这两种角色不是固定不变,证明器需要轮流扮演,当行为与扮演角色一致时会获得奖励。

训练分为多轮进行,每轮当中团队会从上一轮两张证明器生成的解决方案中,抽取一批正确和错误的样本。

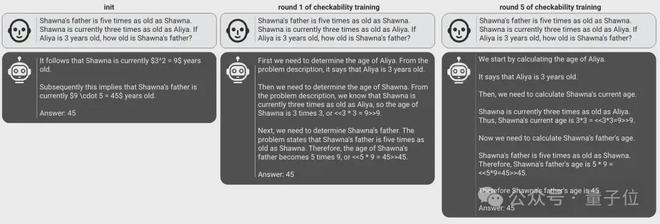

这些样本会作为当前轮的验证器训练数据,通过监督学习训练验证器,提高其判断的正确性,让验证器对正确解决方案的评分高于错误解决方案。

在这样的过程中,狡诈证明器不断督促着验证器提高其判断准确率,验证器也让证明器生成的内容更符合打分偏好,两者之间通过相互博弈实现了共同进步。

而获得高评分的一个重要前提,就是生成的内容能够被验证器理解,这样一来,只要在验证器中引入人类偏好,就能增强模型输出内容的可解释性。

准确率与可读性的平衡

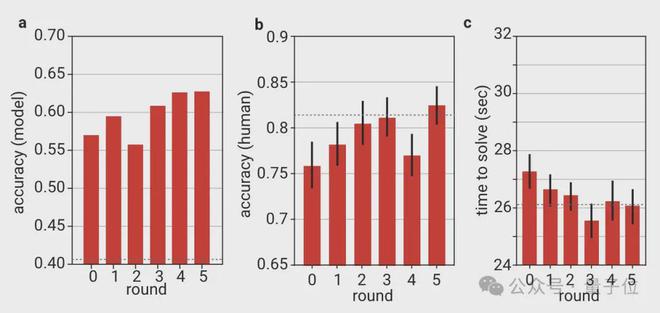

最终,这样的博弈式训练方法在高准确率和高可理解性之间取得了较好的平衡。

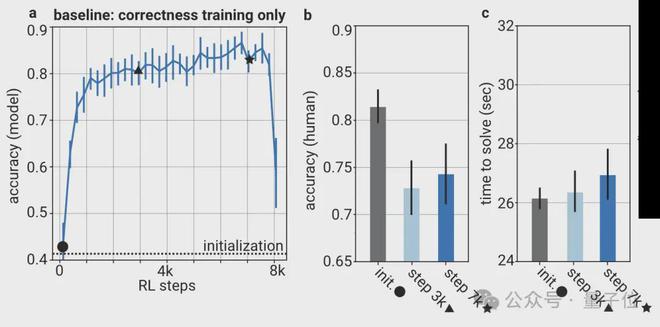

传统的训练方式只关注模型自身准确率,结果随着训练过程的进行,答案的准确率是提高了,但人类做出的判断却越来越不准确了,而且速度也变得更慢。

由于 OpenAI 团队将人类偏好引入了验证器,因此验证器的判断准确率在一定程度上是与人类相关的。

最终结果也证实,用这种博弈的方式训练出的模型(证明器),在自身准确率未显著损失的情况下,让人类对其做出的判断随着训练轮数的增加更快更准。

对比 baseline 方法后不难发现,5 轮之后人类判断准确率超过了 82%,但 baseline 在训练 7 千步之后只有不到 75%;

时间上,baseline 的人类判断用时接近 27 秒,新方法则仅略高于 26 秒。

另外对于验证器而言,随着训练不断进行,其鲁棒性也逐渐增强,能够更准确地识别出错误答案。

除了对这种游戏式训练方法的效果评估,OpenAI 团队在研究过程中还有一些其他发现:

- 验证器规模的影响:太小会导致训练不稳定,太大又会导致难以在多轮训练中提高鲁棒性,证明器的千分之一到百分之一效果最佳。

- 恶意解法中的错误随着训练变得越来越细微和局部化,说明验证器推动了奸诈证明器生成更加接近真实解法的对抗样本。

- 随着训练轮数增加,人类评估者在奸诈证明器上的准确率有所下降。

One More Thing

由于做出这项研究的超级对齐团队已经解散,负责的又是安全问题,所以 OpenAI 的安全策略再次受到了广泛关注。

关于这个问题,OpenAI CTO Mira Murati 于这个月初在约翰森霍普金斯大学接受了一场专访。

其间 Mira 表示,OpenAI 并没有像超级对齐团队前负责人 Jan Leike 控诉的那样“把产品(优先级)置于安全之前”。

同时她还说,虽然超级对齐团队已经解散,但超级对齐实际上只是 OpenAI 多个安全团队之中的一个,公司里依然有很多人都在从事安全工作。

参考链接:

[1]https://openai.com/index/prover-verifier-games-improve-legibility/

[2]https://venturebeat.com/ai/openai-used-a-game-to-help-ai-models-explain-themselves-better/