新智元报道

编辑:耳朵

大模型开源的热潮下,隐藏着诸多问题,从定义的模糊到实际开放内容的局限性,Lecun 再陷 Meta 大模型是否真开源的质疑风波只是冰山一角。

在热火朝天的大模型市场,早已形成了「开源派」和「闭源派」两大门派。

开源被视为技术共享和创新的一种重要方式。实际上,大模型开源相比传统软件开源,情况要更加复杂。

在开源的定义、性质、开放内容和开源策略上都有不同的标准和内容。

因此,「开源派」的帽子并不是那么好戴的。

Meta 发布了 Llama 系列生成 AI 模型的最新版本 Llama 3 8B 和 Llama 3 70B 并宣称是完全开源的,就引来了许多质疑。

Llama 3 模型并不是真正意义的开源,至少不是按照最严格定义的开源。

开源意味着研究开发人员可以自由选择如何使用这些模型,不受限制。

但在 Llama 3 的一些案例中,Meta 对于一些许可的授权进行了限制。

例如,Llama 模型不能用于训练其他模型;拥有超过 7 亿月活跃用户的应用程序开发人员则必须向 Meta 申请特殊许可证。

许多学者和研究机构也注意到了对于「开源」一词的滥用情况,许多标榜为「开源」的大模型都存在重大限制,「真假开源」存疑。

diss 闭源却「翻车」?

Meta 掌门人 Mark Zuckerberg 在上周四发表的一篇访谈中谈到了他对人工智能未来的看法,他深信「不会只有一种人工智能」。

Zuckerberg 着重强调了开源的价值,即把人工智能工具交到许多人手中。

他还不忘 diss 那些他认为不够开放的竞争对手,并补充说他们似乎认为自己在「创造上帝」。

小扎的采访句句绵里藏针,原话也有许多值得细品的点。

「I find it a pretty big turnoff when people in the tech industry…talk about building this ‘one true AI,’ It’s almost as if they kind of think they’re creating God or something and…it’s just—that’s not what we’re doing, I don’t think that’s how this plays out.」

当科技行业的人...谈论打造「唯一真正的人工智能」时,我觉得这让人非常反感。这几乎就像是他们认为自己在创造上帝之类的东西,而这根本不是我们正在做的事情,我也不认为事情会这样发展。

小扎认为,打造唯一真正的 AI 听上去刺耳又令人反胃,暗含一种垄断和控制的野心,你是「唯一真正的 AI」,那其他 AI 都是歪门邪道?

其次,创造上帝是用来讽刺追求「唯一真正的 AI」的人,狂妄地想要把握 AI 领域的绝对话语权。

最后,小扎赶紧和这些人划清界限,不是一路人。

可见,小扎认为 AI 世界应该是百花齐放、百家争鸣的,一家独大绝不可取。

CEO 的言论也代表了 Meta 的态度,Meta 一直以来都宣传秉持着开放的态度,Zuckerberg 更是开源的坚定支持者。

diss 一出也会面临各种评论「diss back」的挑战,你说你是开源,真的吗?

Meta 的首席人工智能科学家 Yann LeCun 上个月在 LinkedIn 上发布了有关 Meta 公司免费发布大型语言模型战略的帖子。

一些评论者对其做法大加赞赏,称其正在「重塑行业合作」。

也有人不同意 LeCun 将这一战略描述为「开源」。

一位评论者写道,「这绝对只能叫做开放模式而非开源,称某些东西为开源而实则并非开源,实在是对开源运动的曲解。」

另一位评论者说,「很遗憾,在这种情况下,开源只是数据洗钱的营销手段。」

第三位专家建议 Meta 将 Llama 模型称为「开放权重」,而不是「开源」。因为该公司共享模型权重,但不共享训练数据等信息。

这似乎是语义学上的争论。但是,一些模型,包括 Meta、法国 Mistral 和德国 Aleph Alpha 的模型,是否真正开源,已经成为人工智能工作者,尤其是学术研究人员之间反复争论的问题。

对于这个问题的答案也会带来相关政策的导向。

欧盟的《人工智能法》规定,开源模型不受某些法条的限制。

如果欧盟认为某个模型是开源的,那么它可能会要求模型制作者必须公开关于如何开发模型的信息。

什么才算「开源」?

这种争论源于开源人工智能缺乏一个明确的定义。

为开源软件制定标准的「开源计划」目前正在制定开源人工智能的定义。

它对开源软件的定义有几个标准,包括软件必须允许自由再分发并包含源代码。

除此之外,该非营利组织和其他开源软件的支持者还强调技术的透明度和同行评审制度。

但一些开源支持者表示,开源软件的传统定义并不能很好地诠释 AI 大模型开源。

软件开源是指源代码的开源,拿到源代码就能「知其然而知其所以然」,可以在源代码的基础上,进行修改优化或增加新功能。

然而,许多自称开源的大模型开发者并不是真正的开源,虽然这些大模型提供了部分代码和训练好的权重,但在训练数据和具体训练过程透明度却有所欠缺,或者很少分享他们的模型是如何训练和微调的。

例如,Meta 的 Llama3 要求月活跃用户超过 7 亿的公司申请许可证,而这些公司的申请后享有的权利可能比 Llama3 的一般协议还要少。

OSI 尚未批准 Meta 的许可证,这表明该组织认为开发者遵循了其开放源码软件标准。

OSI 执行董事 Stefano Maffulli 在接受 TechCrunch 采访时说,「参与评审的其他人都完全同意,Llama 本身不能被视为开源。与我交谈过的在 Meta 工作的人都知道,这有点牵强。」

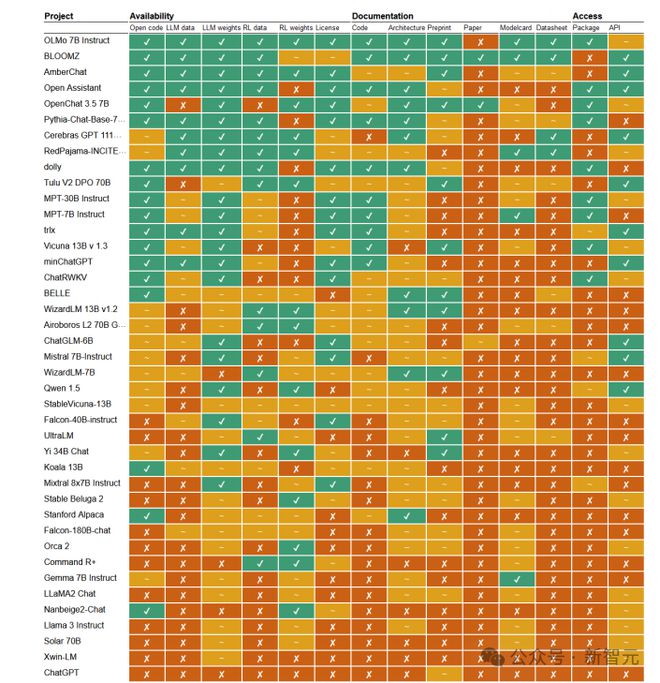

在 OSI 为开源人工智能下定义的同时,一些研究人员和学者也开始自己动手。

该框架并不敲定一个模型的代码是开放的还是封闭的,而是为 14 项标准中的每一项划定一个等级:开放、部分开放或封闭。

因此 ,在这一框架下,Meta 的 Llama2 被评为封闭代码,而不是开放代码。

因为「该模型的源代码都没有公开,而且只共享了运行该模型的脚本」。

相比之下,研究小组 BigScience Workshop 的 BloomZ 模型在这一标准上被评为开放,因为它「提供了用于训练、微调和运行模型的源代码」。

论文作者、拉德布德大学语言技术助理教授 Andreas Liesenfeld 表示,「我们发现,模型制造商存在过度营销的问题,他们将自己的产品宣传得比他们所说的更开放。」

他补充说,「如果不了解模型是如何训练的以及训练的内容,就很难解决法律责任和公平性的问题。」

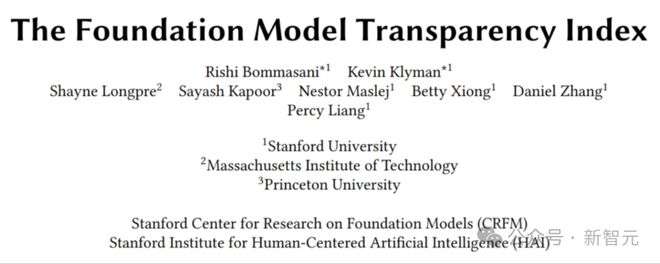

与此类似,斯坦福大学基金会模型研究中心的研究人员去年 10 月推出了基金会模型透明度指数,根据 100 项指标来衡量模型开发商的透明度。

该指数给 Meta 在模型基础知识、访问和能力方面的透明度打了高分,但在数据和劳动力方面的透明度较低。

该指数的共同创建者、斯坦福大学计算机科学副教授 Percy Liang 说,「拥有开放权重或开放源代码的模型、训练数据和代码,对于学术机构、研究人员或只想了解科学的公司来说,将是一个巨大的好处。」

大模型作为一个黑匣子,模型中可能存在各种不确定的东西,只有对模型所训练的数据有实际的保证,才能真正确保模型足够「开源」。

开源内容的局限性

一般开放的内容

在绝大多数宣称自己是开源模型的案例中,开源大模型通常只开放以下几部分内容。

代码:实现大模型训练和推理所需的代码,包括模型架构、训练算法、模型推理等核心代码。

这些代码让开发者能够理解模型的基本结构和推理过程,但无法完全复现或改进模型,增加功能等等。

权重:训练完成后得到的模型参数,这些参数是模型在推理过程中所需的核心要素。

权重数据使得开发者能够在现有模型基础上进行相关推理,但对模型的核心训练细节,例如如何进行模型训练却一无所知。

例如,Meta 的 Llama 系列模型只开放了模型的权重和部分代码,而对训练数据和具体训练过程的详细信息却守口如瓶。

这种有限的开放使得开发者只能使用现有模型进行推理,依葫芦画瓢,而无法深入理解或改进模型。

未开放的关键内容

然而,对于大模型来说,真正决定其性能的关键在于这些通常保密的训练数据和训练过程。

训练数据:原始训练用的数据集和数据来源,以及在训练过程中进行数据处理和预处理的细节。

这些数据通常包含大量的高质量、有代表性的文本数据,对模型的性能至关重要。

然而,大部分开源模型并未公开这些训练数据。

例如,Llama 系列模型虽然提供了训练好的权重,但并未公开其训练所用的数据集及其详细信息。

缺乏这些数据,开发者就无法对模型进行重新训练或在相似任务上进行微调。

训练过程:具体的训练步骤、参数设置、优化方法等。

这些细节决定了模型的训练效果和最终性能,但在所谓的「开源」大模型中,这些信息往往是闭源的。

例如,尽管一些大模型提供了部分代码和权重,但训练过程中使用的超参数、数据增强方法、训练策略等关键细节并未公开。

这种不完全开放的做法使得开发者在复现模型时面临诸多困难,无法真正掌握模型的核心技术,限制了他们对模型进行优化和改进的能力。

实际上,它们提供的只是使用现有模型的使用便利,而不是完全的技术透明和开发自由。

参考资料:

https://www.theinformation.com/articles/what-counts-as-open-source