新智元报道

编辑:耳朵乔杨

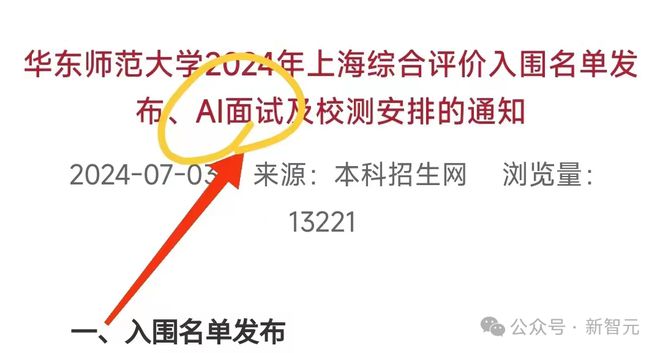

随着企业纷纷采用 AI 技术来自动筛选简历、评估面试,我们不禁会发出疑问:这些「AI 招聘官」到底是铁面无私、一视同仁,还是携带偏见越走越远?

宝宝你是一个即将毕业的应届毕业生,对未来充满希望,决定毕业后在职场也要叱咤风云。

然而,听多了 AI 取代人类的你也万万没有想到,找工作时遇到的第一个面试官,竟然是 AI。

到了时间,你登录系统,根据指示核对身份信息,检查摄像头是否开启,麦克风是否正常,坐得端端正正,最后在电脑前按下确认。

随着冷静而又停顿机械的 AI 考官出题,一场人机面试就开始了。

应聘新关卡:「铁面无私」人机交锋

又到一年毕业季,上面的「你」可能就是千千万万个毕业生的缩影。

人工智能革命已经开始,几乎遍及人们职业和个人生活的方方面面,包括学业面试和工作招聘。

企业管理层越来越意识到,在供应链管理、客户服务、产品开发和人力资源等各个环节,人工智能都有可能带来更高的效率。

其中,能用于招聘的,就是传说中的「AI 面试官」。

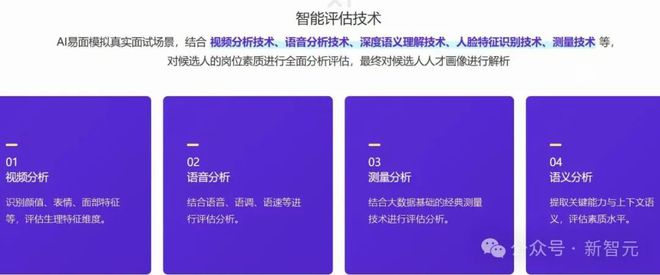

它实际上是一个能够实时交互的问答机器人,通过语义识别、表情识别和声音识别等多种算法,根据既定问题,对面试者的回答进行分析、梳理,最终给出参考评分。

例如,在按照职位要求筛选简历时,AI 比人类有更高的准确率和效率优势,而在相对简单、流程标准化的初试中,也能以最快的速度完成初筛。

此外,AI 面试官确实是物理意义上的「铁面无私」,能够避免面试官因偏见、歧视、亲缘等问题而造成的偏差,提高决策的公平性和一致性。

《2023 年中国网络招聘市场发展研究报告》显示,AI 视频面试在应用场景中的占比已经达到 31.8%,而这个比例在未来只会有增无减。

不仅是中国,在全球范围内用 AI 提升招聘效率也越来越常见。

快消巨头联合利华就曾发布过一组数据:AI 能够帮助节约 10 万小时的面试时间,每年能省下 100 万美元的招聘成本。

然而,虽然 AI 的引入能降本增效,但人工智能的本质以及背后的训练数据,都带着人的烙印,会不可避免地引入人类偏见,甚至还可能在原有偏见的基础上「变本加厉」。

放大人类偏见

虽然在招聘中使用人工智能的原因之一是为了更加客观,但多项研究发现,这种技术实际上很可能存在偏见。

之所以会出现这种情况,根本原因还是数据。如果数据有偏见和缺陷,人工智能也会复制这种缺陷。

The Decoder 与 22 位人力资源专业人士进行的访谈后,发现了招聘中常见的两种偏见——「刻板印象偏见」和 「同类相似偏见」。

「刻板印象偏见」顾名思义,来源于对某个群体的刻板印象。比如偏爱某个性别的应聘者,从而导致性别不平等。

「同类相似偏见」,则指的是招聘人员偏爱与自己有相似背景或兴趣爱好的应聘者。

这些偏见会严重影响招聘过程的公平性,它们可能流入历史招聘数据,然后被用来训练人工智能系统,就导致了 AI 偏见。

例如,从 2014 年起,亚马逊公司就开始开发用于简历筛选的人工智能,希望从海量的简历中,快速地筛选出最理想的候选人。

不过,这个技术仅仅过了一年,有人就发现,AI 的筛选结果中包含强烈的性别倾向。

即使候选简历里面并未明示性别,AI 也会在文本的蛛丝马迹里寻找「线索」,例如「女子棋社队长」,或者毕业于女子大学。

知情人士表示,这个人工智能的训练材料,是公司过去 10 年的雇佣历史,而在科技领域,长期的职业刻板印象以及「亲男文化」,都导致了男性雇员数量大于女性,尤其是技术岗位。

2017 年,亚马逊弃用了这个筛简历的 AI 模型。

这种偏见的持续存在表明,无论是否使用 AI,都有必要进行仔细规划和监测,以确保招聘流程的公平性。

人类能消除偏见吗?

除了人力资源专业人士,The Decoder 还采访了 17 位人工智能开发人员,希望研究如何开发人工智能招聘系统,以减少而不是加剧招聘偏见。

在访谈的基础上,他们建立了一个模型,让人力资源专业人员和 AI 工程师在研究数据集和开发算法的过程中,来回交换信息,质疑并去除先入为主的观念。

然而,研究结果表明,实施这种模式的困难在于人力资源专业人员和 AI 开发人员之间存在的教育和专业差异。

这些差异阻碍了有效沟通、合作,甚至是相互理解的能力。

人力资源专业人员传统上接受的是人员管理和组织行为方面的培训,而 AI 开发人员则精通数据计算和技术,这些不同的背景会导致合作时的误解和不协调。

如何优化 AI+HR

皮尤研究中心最近对 11004 名美国人进行了一项调查,发现 66% 的人不想向用 AI 招聘的雇主申请工作。

只有 32% 的人表示他们会申请,而其余的人则不确定。而 71% 的人反对 AI 做出的招聘决定。

因此,如果企业和人力资源行业想要解决 AI 招聘中的偏见问题,就需要做出几项改变。

首先,要对人力资源专业人员进行培训,以信息系统开发和人工智能为重点的结构化培训至关重要。

培训内容应包括 AI 的基本原理、如何识别系统中的偏见以及减少这些偏见。

此外,促进人力资源专业人员与 AI 开发人员之间更好的合作也很重要。

公司应该建立包括人力资源和 AI 专家在内的团队。这有助于弥合沟通鸿沟,更好地协调双方的工作。

此外,建立具有文化多样性的高质量数据集,确保 AI 的招聘流程中使用的数据能代表不同的人口群体。

最后,各国需要制定在招聘中使用 AI 的指导方针和道德标准,以帮助建立信任并确保公平。各组织应在 AI 的决策过程中实行问责制,提高透明度。

通过采取这些措施,我们可以创建一个更具包容性和公平性的招聘系统,既然 AI 擅长做客观数据的分析与决策参考,那么作为辅助工具使用,而不是携带着训练不够的「蠢」和复制偏见的「坏」贸然成为命运的判官。

最后,下拉海报新智元招聘中,全人工倾情对接无人机机械冰冷~

参考资料: