摩尔线程宣布开源音频理解大模型 —MooER(摩耳)。公告称,MooER 是业界首个基于国产全功能 GPU 进行训练和推理的大型开源语音模型,不仅支持中文和英文的语音识别,还具备中译英的语音翻译能力。

摩尔线程 AI 团队在该工作中开源了推理代码和 5000 小时数据训练的模型,并计划进一步开源训练代码和基于 8 万小时数据训练的模型。

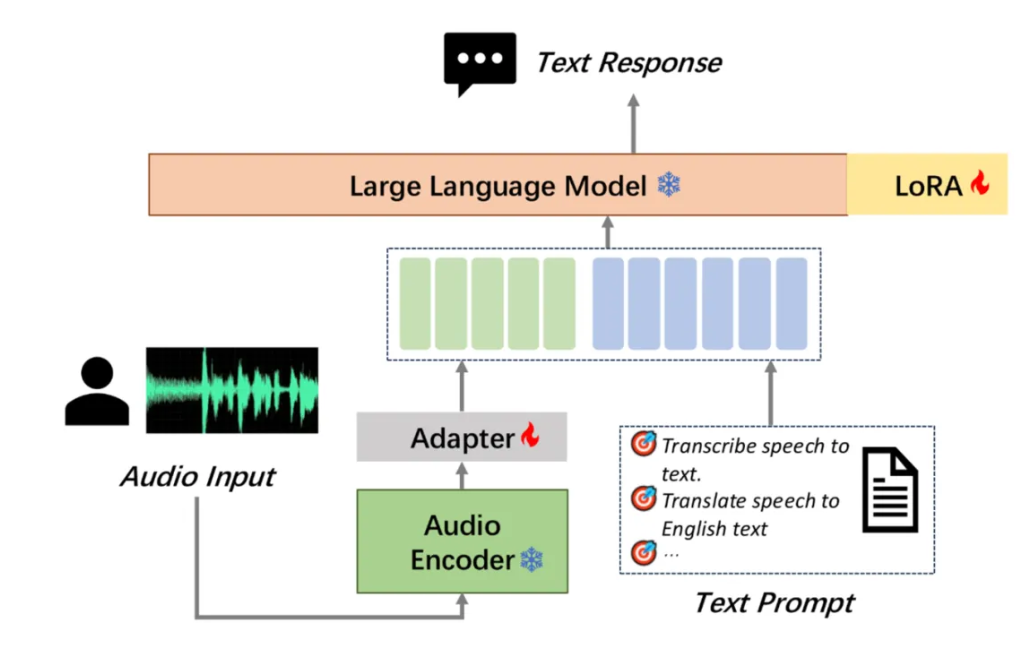

MooER 的模型结构包括 Encoder、Adapter 和 Decoder(Large Language Model,LLM)三个部分。其中,由 Encoder 对输入的原始音频进行建模,提取特征并获取表征向量。Encoder 的输出会送到 Adapter 进一步下采样,使得每 120ms 音频输出一组音频 Embedding。音频 Embedding 和文本的 Prompt Embedding 拼接后,再送进 LLM 进行对应的下游任务,如语音识别(Automatic Speech Recognition,ASR)、语音翻译(Automatic Speech Translation,AST)等。

在模型训练阶段,融合了语音模态和文本模态的数据会按以下形式输入到 LLM:

项目团队将 MooER 与多个开源的音频理解大模型进行了对比,包括 Paraformer、SenseVoice、Qwen-audio、Whisper-large-v3 和 SeamlessM4T-v2 等。结果显示,MooER-5K 在六个中文测试集上的 CER(字错误率)达到 4.21%,在六个英文测试集的 WER(词错误率)为 17.98%,与其它开源模型相比,MooER-5K 的效果更优或几乎持平。

特别是在 Covost2 zh2en 中译英测试集上,MooER 的 BLEU 分数达到了 25.2,显著优于其他开源模型,取得了可与工业水平相媲美的效果。基于内部 8 万小时数据训练的 MooER-80k 模型,在上述中文测试集上的 CER 达到了 3.50%,在英文测试集上的 WER 到达了 12.66%。

更多详情可查看技术文档:https://arxiv.org/pdf/2408.05101