新智元报道

编辑:桃子好困

LLM 若以每秒 1000+token 高速推理,当前最先进的 GPU 根本无法实现!Cerebras Inference 一出世,推理速度赶超英伟达 GPU,背靠自研的世界最大芯片加持。而且,还将推理价格打了下来。

LLM 若想高速推理,现如今,连 GPU 都无法满足了?

曾造出世界最大芯片公司 Cerebras,刚刚发布了全球最快的 AI 推理架构——Cerebras Inference。

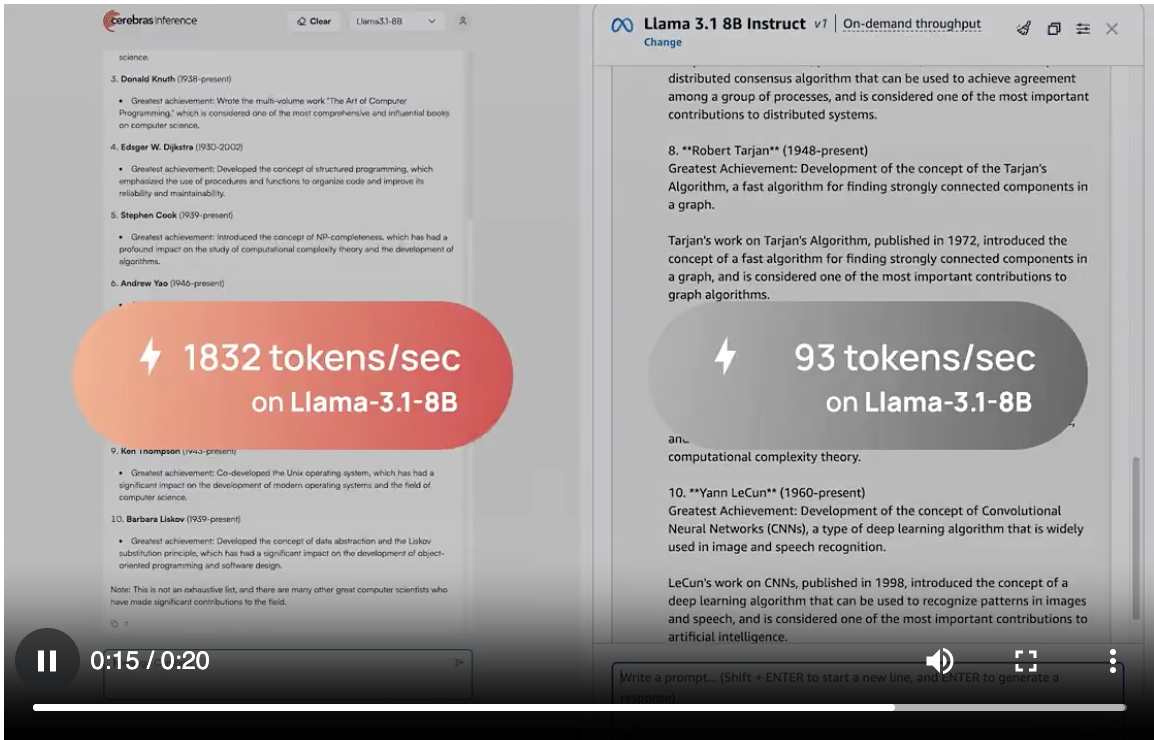

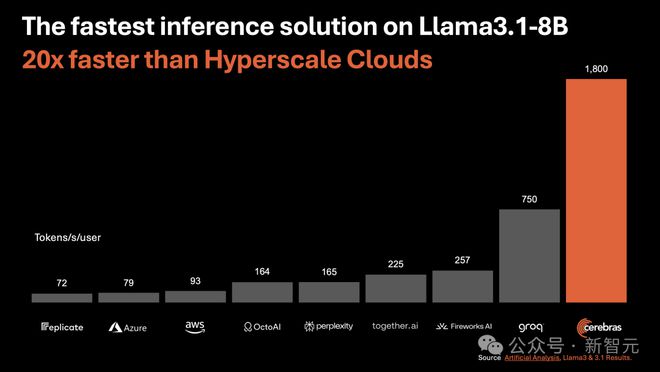

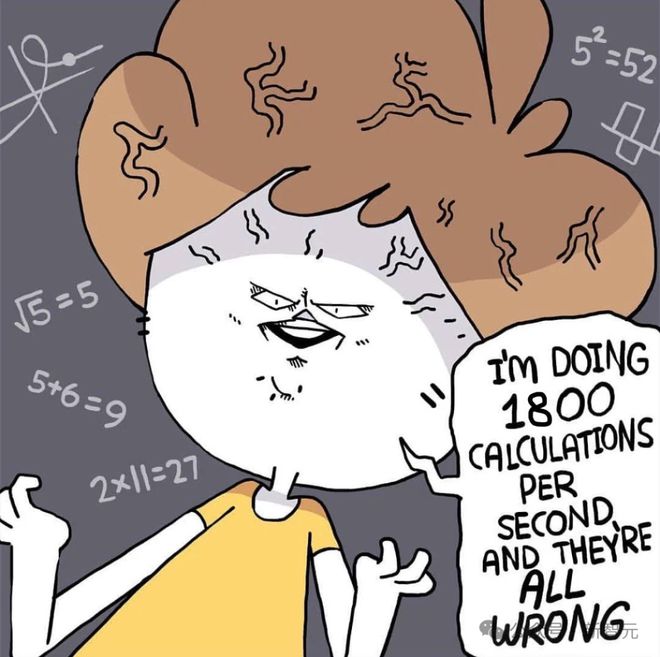

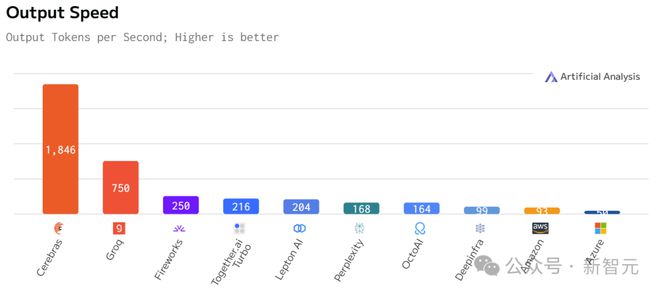

运行 Llama3.1 8B 时,它能以 1800 token/s的速率吐出文字。

不论是总结文档,还是代码生成等任务,响应几乎一闪而过,快到让你不敢相信自己的眼睛。

如下图右所示,以往,微调版 Llama3.1 8B 推理速度为 90 token/s,清晰可见每行文字。

而现在,直接从 90 token/s跃升到 1800 token/s,相当于从拨号上网迈入了带宽时代。

左边 Cerebras Inference 下模型的推理速度,只能用「瞬间」、「疯狂」两字形容。

这是什么概念?

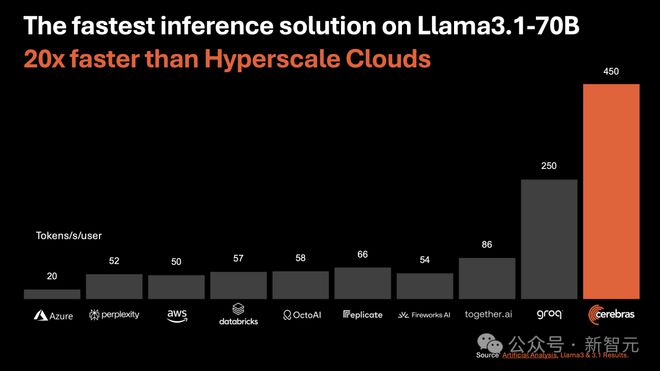

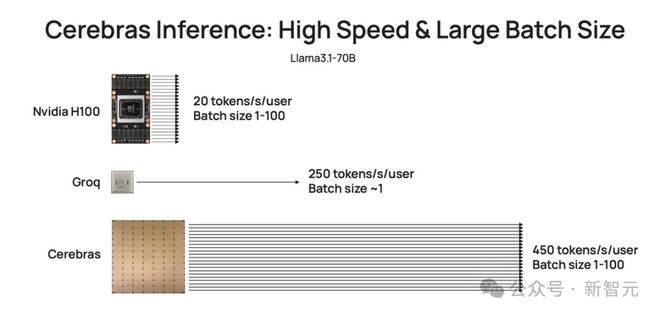

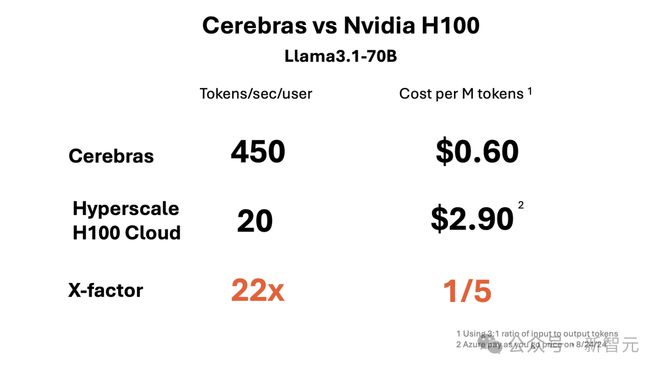

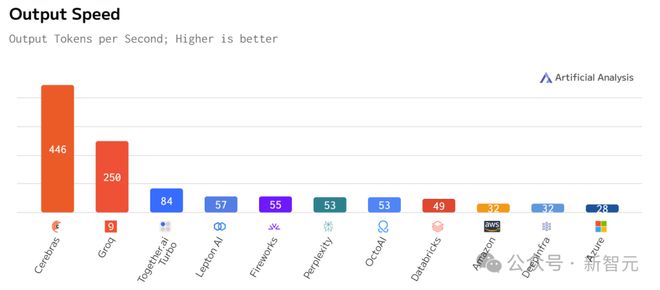

比起英伟达 GPU,Cerebras Inference 的推理速度快 20 倍,还要比专用 Groq 芯片还要快 2.4 倍。

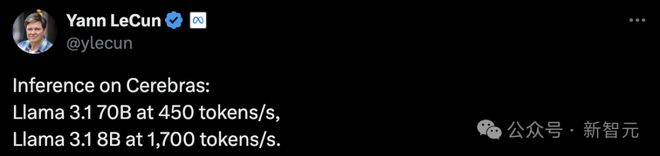

另外,对于 70B 参数的 Llama3.1,可达到 450 token/s及时响应。

值得一提的是,Cerebras 并没有因为提高 LLM 的速度,而损失其精度。

测试中,使用的 Llama3.1 模型皆是采用了 Meta 原始 16 位权重,以便确保响应高精度。

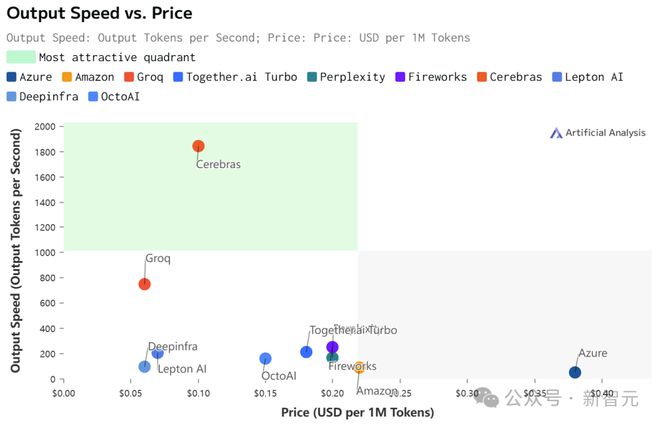

最关键的是,价格还实惠。

根据官方 API 定价,Llama 3.1 8B 每百万 token 仅需 10 美分,Llama 3 70B 每百万 token 仅需 60 美分。

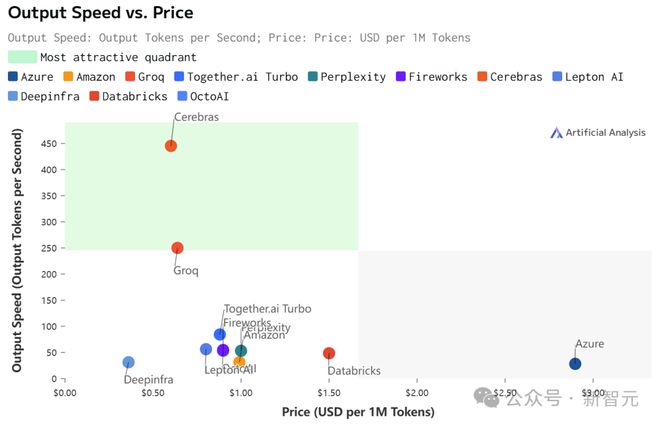

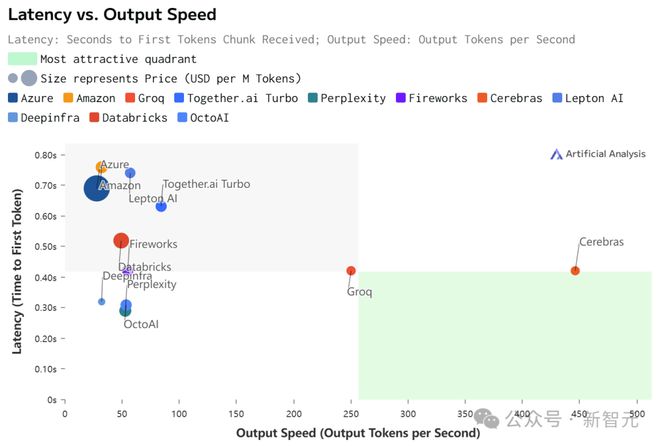

如此之高的性价比,更是打破了业界纪录——

不仅远超之前的保持者 Groq,而且和其他平台相比,甚至是隔「坐标轴」相望了。

Artificial Analysis

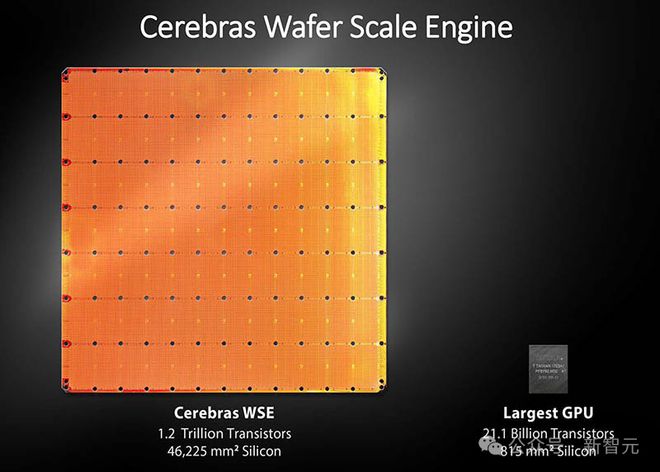

正是因为 Cerebras Inference 背后,是由自研的第三代芯片 Wafer Scale Engine 助力,才得以1/5 价格快速推理 Llama3.1。

看到自家模型推理如此神速,LeCun、Pytorch 之父纷纷动手转发起来。

还有网友看后表示,我想要!

推理很慢,英伟达 GPU 也不中用?

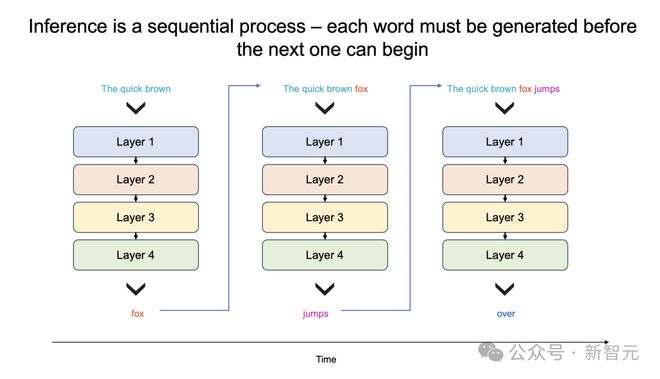

为什么 LLM 的响应,就像拨号上网加载网页一样,一个字一个字慢慢地吐出?

关键原因所在,大模型自身的顺序特性,以及需要大量的 GPU 内存和带宽。

由于 GPU 的内存带宽限制,如今推理速度为每秒几十个 token,而不是数千个。

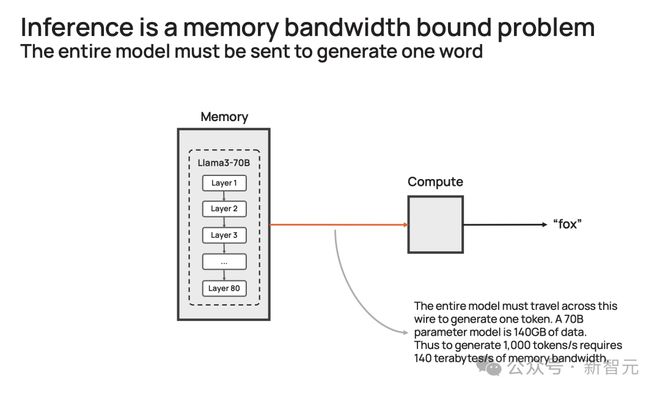

更进一步说,大模型每个生成的单词,都必须通过整个模型进行处理,即所有参数必须从内存投入到计算中。

而每生成一个单词,就需要一次处理,以此循环往复。

也就是,生成 100 个单词需要 100 次处理,因为「下一词」的预测,皆需要依赖前一个单词,而且这个过程无法并行。

那么,想要每秒生成 100 个单词,就需要所有模型参数,每秒投入计算 100 次。

由此,这对 GPU 内存带宽提出了高要求。

以社区流行的 Llama3.1-70B 模型为例。

模型有 700 亿参数,每个参数是 16 位,需要 2 字节的存储,那整个模型便需要 140GB 的内存。

想要模型输出一个 token,那 700 亿参数必须从内存,移动到计算核心,以执行前向推理计算。

由于 GPU 只有约 200MB 的片上内存,模型无法存储在芯片。

因此,每次生成的 token 输出时,需将整个占用 140GB 内存的模型,完整传输到计算中。

再细算下来,为了实现 10 token/s,则需要 10*140=1.4 TB/s的内存带宽。

那么,一个 H100 有 3.3 TB/s的内存带宽,足以支持这种缓慢的推理。

而若要实现即时推理,需要达到 1000 token/s或 140 TB/s,这远远超过任何 GPU 服务器/系统内存带宽。

或许,你想到了一种「暴力」解决方案,将多个 GPU 串联搭建 DGX 系统。

这完全是大错特错,更多的处理器只会增加系统的吞吐量(给出更长响应),并不会加速单个查询的响应时间。

自研世界最大芯片,打破推理想象

那么,Cerebras 如何打破这一困局呢?

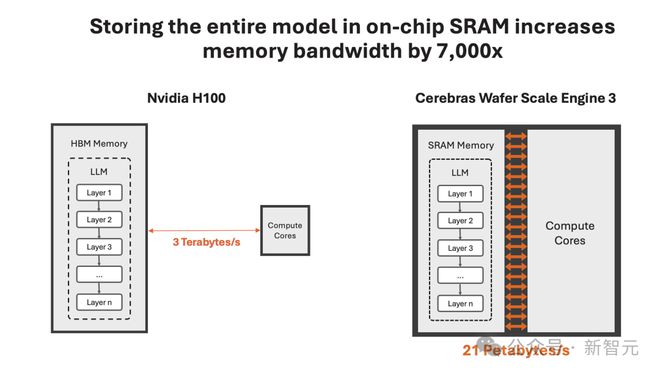

一直以来,这家公司就致力于打造世界上最大芯片,希望将整个模型存储在一个晶片上,以此来解决内存带宽瓶颈。

凭借独特的晶圆设计,WSE-3 单个芯片上便集成了 44GB SRAM,具备 21 PB/s的内存带宽。

单个芯片拥有如此大内存,便消除了对外部内存的需求,以及将外部内存连接到计算的慢速通道。

总的来说,WSE-3 的总内存带宽为 21PB/s,是 H100 的 7000 倍。

它是唯一一款同时具有 PB 级计算和 PB 级内存带宽的 AI 芯片,使其成为高速推理的近乎理想设计。

Cerebras 推理不仅速度超快,而且吞吐量巨大。

与小型 AI 芯片相比,芯片上内存多了约 200 倍,支持从1-100 的批大小,使其在大规模部署时,具有极高的成本效益。

正是有了如此强大的芯片,Cerebras Inference 的快速推理得以实现。

它的出现,是为了实现数十亿到万亿参数模型的推理。

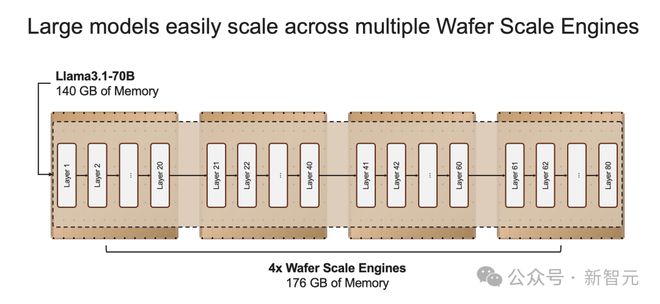

如果模型参数超过单个晶圆的内存容量时,研究人员将在「层边界」将其拆分,并映射到多个 CS-3 系统上。

20B 模型适合单个 CS-3,而 70B 模型则至少需要 4 个这样的系统。

官方表示,未来几周,将会测试更大参数版本的模型,比如 Llama3-405B、Mistral Large。

16 位精度,不做取舍

推理速率高,并非在模型权重上,做了取舍。

业界中,一些公司试图将模型权重精度,从 16 位减少到 8 位,来克服内存带宽的瓶颈。

这样方法,通常会造成模型精度损失,也就是响应结果的准确性、可靠性不如以前。

Cerebras Inference 之所以强就强在了,速率和原始权重,皆要顾及。

正如开篇所述,他们采用了原始 16 位权重运行了 Llama3.1 8B 和 70B。

通过评估,16 位模型准确率比 8 位模型,高出多达5%。尤其是在,多轮对话、数学和推理任务中表现更好。

最优性价比,百万 token 免费送

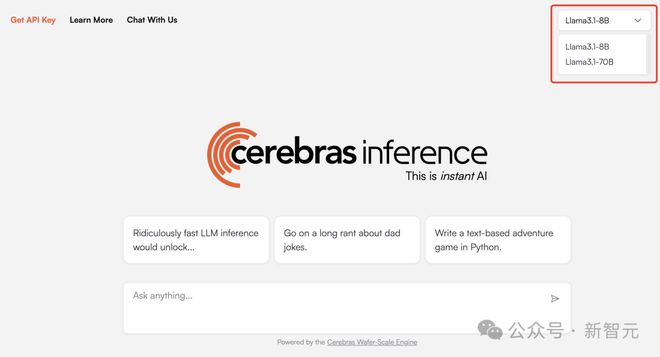

目前,Cerebras Inference 可通过聊天平台,以及 API 访问,任何一个人可随时体验。

体验传送门:https://cerebras.ai/blog/introducing-cerebras-inference-ai-at-instant-speed

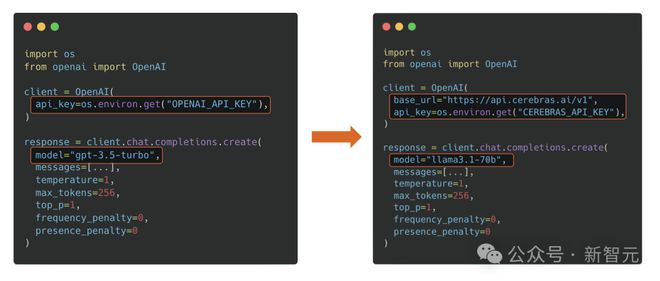

基于熟悉的 OpenAI Chat Completions 格式,开发者只需更换 API 密钥即可集成强大的推理功能。

Cerebras Inference API 提供最佳的性能、速度、精度和成本组合。

它是唯一能即时运行 Llama3.1-70B 的方案,可实现 450 token/s,同样使用的是原始 16 位模型权重。

在此,Cerebras 送上大福利,每天为开发者们提供 100 万个免费 token。对于大规模部署,其定价只是 H100 云的一小部分。

首次推出时,Cerebras 提供了 Llama3.1 8B 和 70B 模型,而且有能力每天为开发者和企业,提供数千亿 token。

接下来几周,他们将增加对更大模型的支持,如 Llama3 405B、Mistral Large 2。

有开发者问道,你们提供的 rpm(每分钟请求次数)和 tpm(每分钟处理 token 数)是多少?

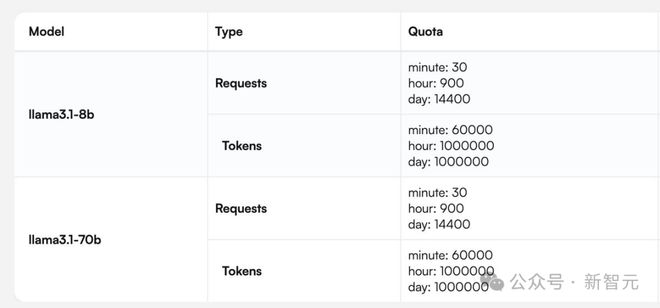

Cerebras 提供了一张针对 Llama 3.1 8B 和 70B 模型完整的请求/token 处理数的图。

快速推理,不只为速度

最后,让我们来聊聊,为什么快速推理非常重要?

通常,LLM 会即刻输出自己的全部想法,而不考虑最佳答案。而诸如 scaffolding(脚手架)这类的新技术,则如同一个深思熟虑的智能体,会在作出决定前探索不同的可能解决方案。

这种「先思考后发言」的方式在代码生成等严苛任务中,可以带来超过 10 倍的性能提升,从根本上提升了 AI 模型的智能,且无需额外训练。

但这些技术在运行时,需要多达 100 倍的 token。

因此可见,如果我们能大幅缩短处理时间,那么就可以实现更为复杂的 AI 工作流程,进而实时增强 LLM 的智能。

速度爆表,但上下文只有 8K

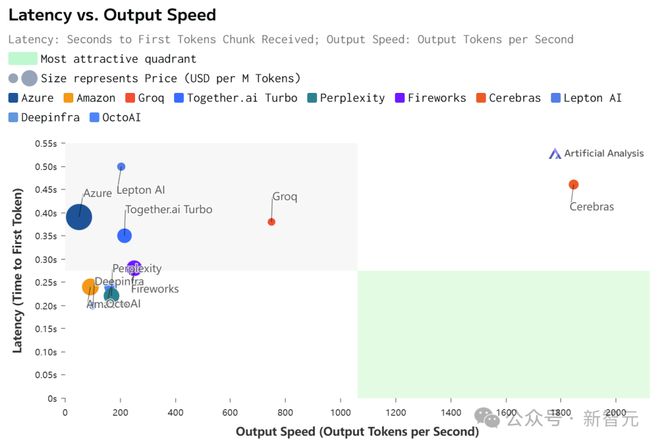

虽然在价格和延迟上,Cerebras 都不是最低的。

但极致的速度,确实为 Cerebras 带来了极致的速度-价格和速度-延迟比。

不过,值得注意的是,在 Cerebras 上跑的 Llama 3.1,上下文只有 8k……

相比之下,其他平台都是 128K。

具体数据如下:

Llama 3.1 70B

Llama 3.1 8B

参考资料:

https://cerebras.ai/blog/introducing-cerebras-inference-ai-at-instant-speed

https://x.com/CerebrasSystems/status/1828464491677524311

https://artificialanalysis.ai/models/llama-3-1-instruct-70b/providers