日前,PPIO 派欧云推出全新的 Serverless 和模型 API 服务产品,进一步完善派欧算力云产品矩阵,标志着 PPIO 的分布式云服务从边缘云延伸到 AI 基础设施,将为 AIGC 创新企业和开发者带来更高性价比、弹性、易用的一站式 AI 基础设施产品和服务。

与模型训练相比,AI 推理与产业应用关系更为密切。大模型在训练后需要通过推理应用于实际场景,这直接影响其可用性和实用性。然而,目前 AI 推理面临的主要问题是成本高昂,尤其是随着模型规模增大,计算需求和成本也随之增加。此外,推理效率普遍较低,加上复杂的业务场景和应用链路,进一步推高了推理成本。

为了解决 AI 推理的成本问题,实现大模型应用算力普惠,PPIO 派欧云通过算法、系统和硬件协同创新,推出了专为 AI 推理场景设计的 Serverless 产品,提供模型部署、运行优化、弹性伸缩及 API 服务,帮助客户在自定义模型时获得高效的弹性效率和极致的运行成本。Serverless 产品的推出使得开发者无需再管理和运维算力服务器,而是能够将精力集中于核心业务的应用逻辑开发与创新,从而帮助企业实现降本增效。

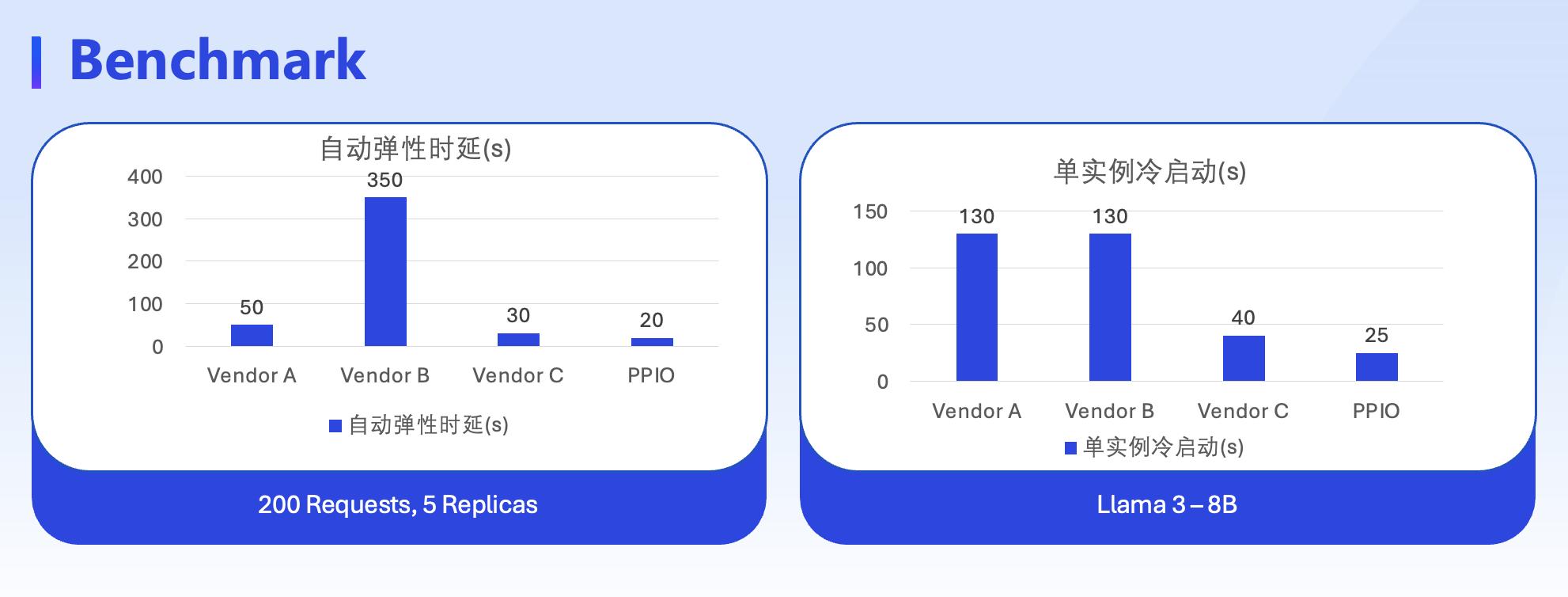

派欧算力云 Serverless 产品提供业界领先的自动弹性触发时延和单实例冷启动速度

此外,PPIO 派欧云还推出了全新的 Model API 服务产品,支持 AIGC 应用开发所需的全模态 API,开发者无需精通机器学习即可快速部署和调用大模型功能。结合 PPIO 强大的分布式计算能力和派欧算力云 Serverless 产品的弹性支持,Model API 服务不仅显著提升了 AI 应用的开发效率,还通过按需付费模式有效降低了企业的开发和运营成本。

派欧算力云产品可广泛应用于多个场景,提供灵活且高效的解决方案。例如,在中国铁塔的智能算力调度管理项目中,为了实现在城市广泛分布的产业园、写字楼、住宅、文娱和高校等园区进行算力入园的管理服务,PPIO 通过打造分布式算力网络,实现不同地区、不同时间、不同业务的弹性算力调度和大模型推理加速,为园区内的 AI 应用提供高性价比的智算服务,满足智能数据处理、大模型部署、AIGC 生成、AI 算法加速、渲染加速等一系列应用需求。

不仅如此,为了推动 AI 应用的持续创新,PPIO 派欧云联合 PingCap、Zilliz、AscentStream 和 CSDN,共同启动“Pioneers AI 初创加速计划”。该计划面向 AI 初创企业和开发者,提供包括分布式算力、分布式关系型数据库、分布式向量数据库、分布式消息队列等在内的全面资源和技术服务,助力初创团队在分布式云上实现快速成长,加速其创新成果的落地。

PPIO 派欧云联合创始人、董事长兼 CEO 姚欣在主题演讲中指出:“遵循尺度定律的基本原理,计算能力将决定大模型创新和应用的上限。在计算资源成本高昂而需求爆增的市场格局下,分布式算力将成为引领下一轮科技革命的重要推动力,正在逐步改变全球计算资源的供给和利用方式。”