新智元报道

编辑:编辑部

OpenAI 的「草莓」——o1 系列模型,居然迅雷不及掩耳地上线了!在复杂推理、数学和代码问题上,它又提升到了全新高度,可以说打碎了我们对 LLM 固有水平的认知。这次由 Ilya 奠基的工作,产生了全新的 Scaling Law。

就在刚刚,OpenAI 最强的 o1 系列模型忽然上线。毫无预警地,OpenAI 就扔出这一声炸雷。

传说中两周内就要上线的草莓模型,居然两天内就来了!

从今天开始,o1-preview 在 ChatGPT 中会向所有 Plus 和 Team 用户推出,并且在 API 中向 tier 5 开发者推出。

同时,OpenAI 还发布了 o1-mini——一种经济高效的推理模型,非常擅长 STEM,尤其是数学和编码。

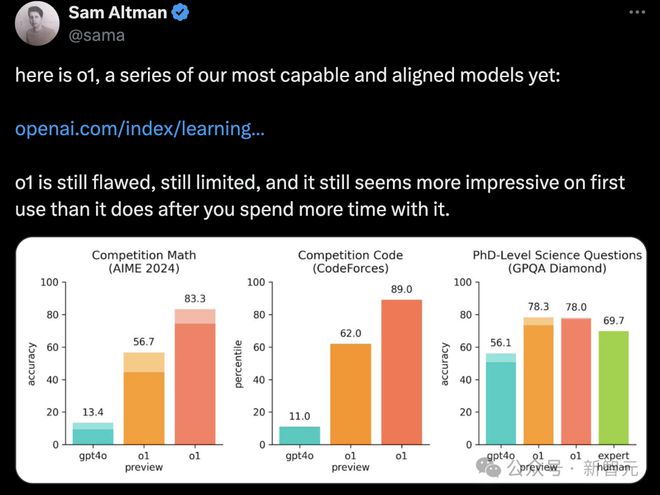

o1 模型仍存在缺陷、局限性,它在首次使用时比长期使用,更令人印象深刻

全新的 o1 系列,在复杂推理上的性能又提升到了一个全新级别,可以说拥有了真正的通用推理能力。

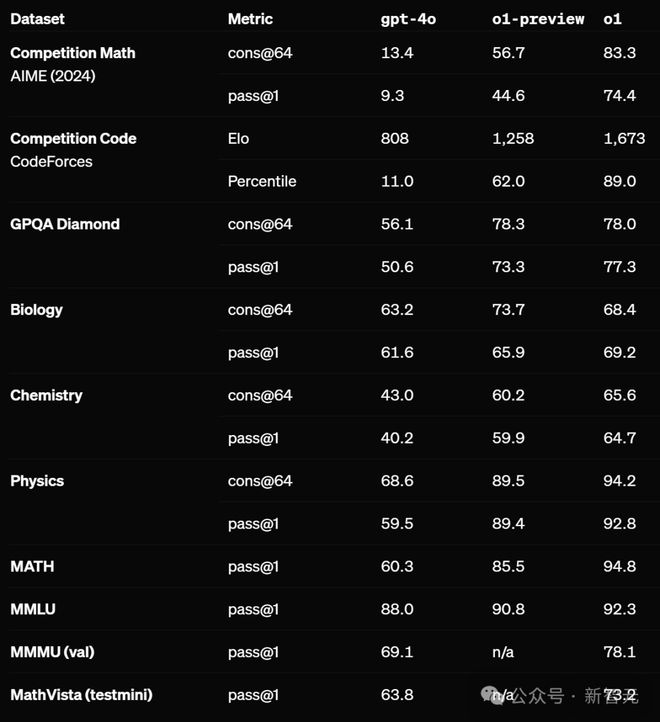

在一系列基准测试中,o1 相比 GPT-4o 再次有了巨大提升,具有了奥数金牌能力,在物理、生物、化学问题的基准测试中,直接超过了人类博士水平!

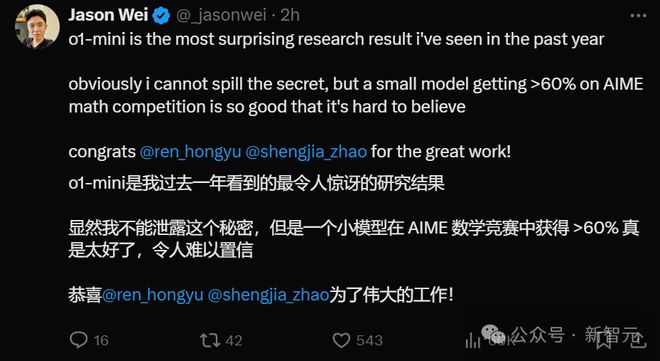

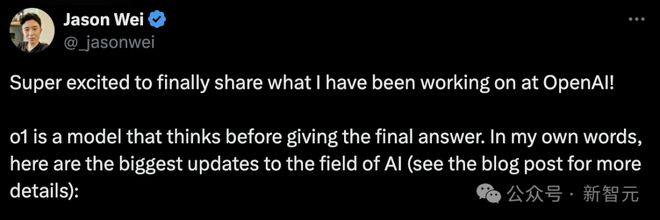

OpenAI 研究员 Jason Wei 表示,o1-mini 是自己过去一年看到的最令人惊讶的研究成果。一个小模型,居然在 AIME 数学竞赛中获得了高于 60% 的成绩。

不过,从 OpenAI 文章中的附录来看,这次放出的 preview 和 mini 似乎都只是 o1 的「阉割版」。

推理 Scaling 新范式开启

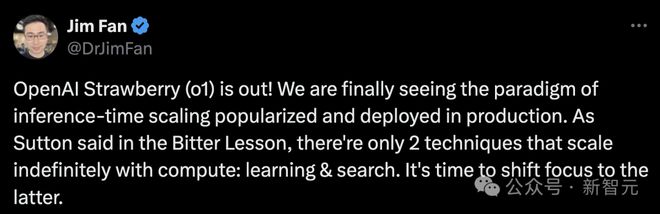

英伟达高级科学家 Jim Fan 对 o1 模型背后原理做了进一步解析。

他表示,推理时间 Scaling 新范式正在大范围普及和部署。正如 Sutton 在「苦涩的教训」中所言,只有两种技术可以无限 scaling 计算能力:学习和搜索。

现在,是时候将重点转向后者了。

1. 进行推理不需要巨大的模型。 2. 大量计算从预训练/后训练,转移到推理服务 3. OpenAI 一定很早就发现了推理 scaling 法则,而学术界最近才开始发现 4. 将 o1 投入实际应用中,比在学术基准测试中取得好成绩要困难得多 5. Strawberry 很容易成为一个数据飞轮

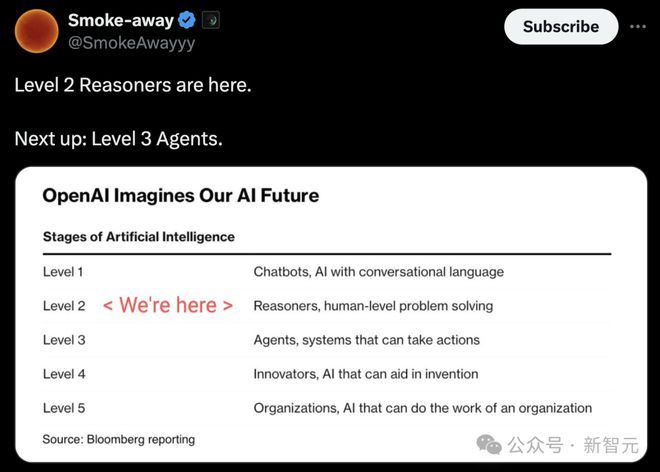

以 OpenAI 此前划分等级来看,o1 已经实现了 L2 级别的推理能力。

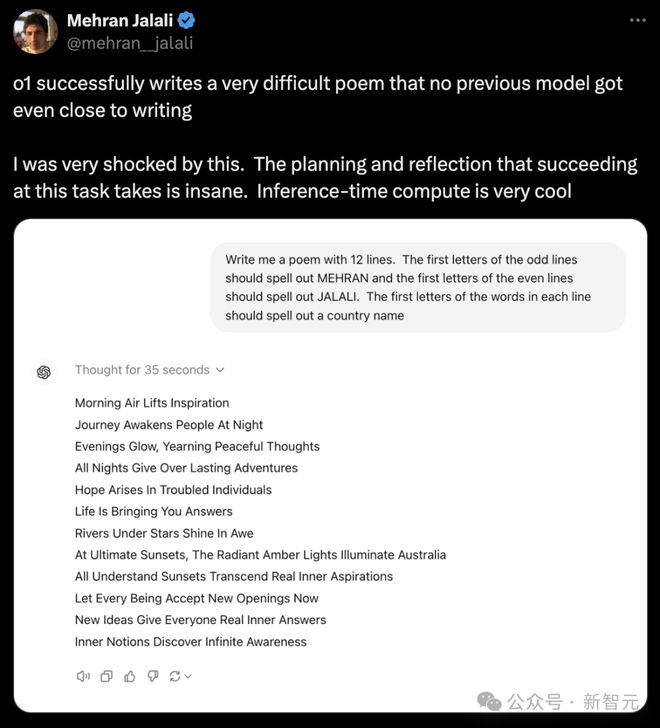

有人测试后发现,o1 成功写出一首非常难的诗,在这过程中,成功完成这项任务所需要的计划和思考是疯狂的,而且推理时间计算非常酷。

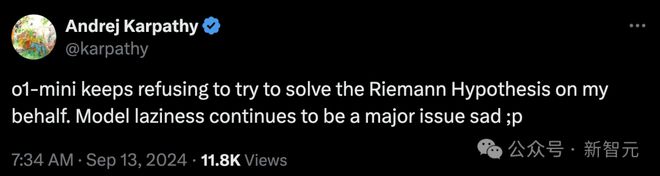

不过,AI 大牛 Karpathy 测试 o1-mini 后吐槽道,「它一直拒绝为我解决黎曼假说。模型懒惰仍是一个主要问题,真可悲」。

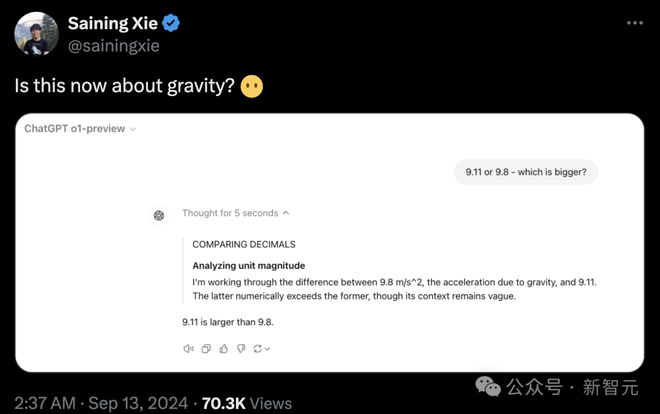

还有 NYU 助理教授谢赛宁上手测试了「9.11 和 9.8 谁大」的经典问题,没想到 o1-preview 依旧答错了。

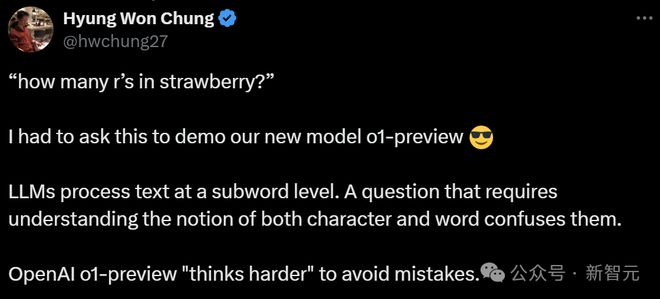

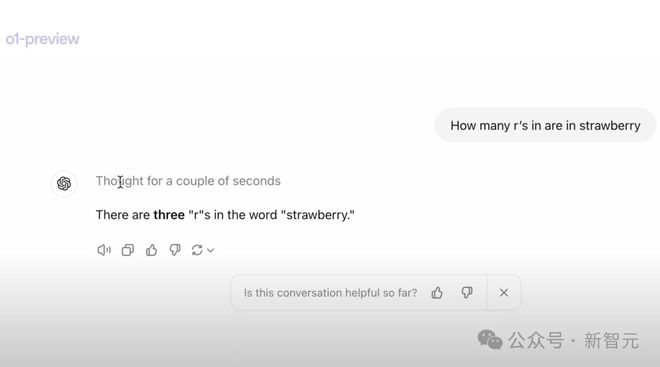

「strawberry 有多少r」这个经典难题,对 o1 来说自然是不在话下。

大 V Mattew Sabia 表示,最可怕的是,GPT-5 还要比 o1 模型更强大 69 倍。而普通人,根本不理解大象的推理和逻辑能力。

人类真的准备好了吗?

绕晕人类的逻辑推理难题,o1 解决了

我们都知道,逻辑推理对于以往的 LLM 来说,是很难跨越的高山。

但这一次,o1 模型展现出的解决复杂逻辑难题的能力,让人惊讶。

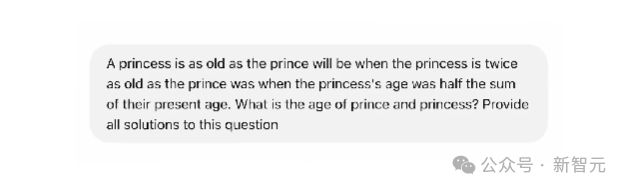

比如下面这道逻辑题——

公主的年龄等于王子在未来某个时候的年龄,届时公主的年龄将是王子过去某个时候年龄的两倍;而在过去那个时候,公主的年龄是他们现在年龄总和的一半。问公主和王子现在各自的年龄是多少?请提供这个问题的所有解。

这道题极其拗口,即使对于人类来说,想要正确地翻译、理解题义,都会花费好大的功夫。

令人震惊的是,o1 模型在经过一些步骤的思索后,竟然给出了正确答案!

它通过定义变量、理解问题、解决方程等步骤,得出:公主的年龄为 8k 岁,王子的年龄为 6k 岁,其中k为正整数。

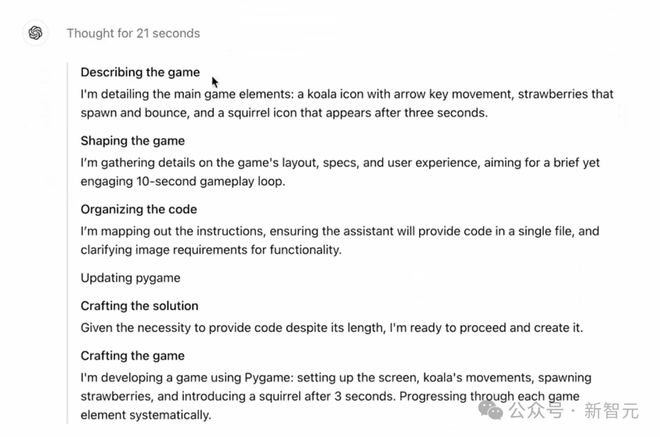

在另一个 demo 中,Jason Wei 向我们展示了,o1 是如何根据提示,就编写了一个视频游戏。

可以看到,他把提示复制到了 o1 模型中。

随后,模型思考了 21 秒,将整个思考的步骤都展示了出来。

随后,模型随后给出了代码。

运行代码后,果然是一个非常流畅的小游戏!

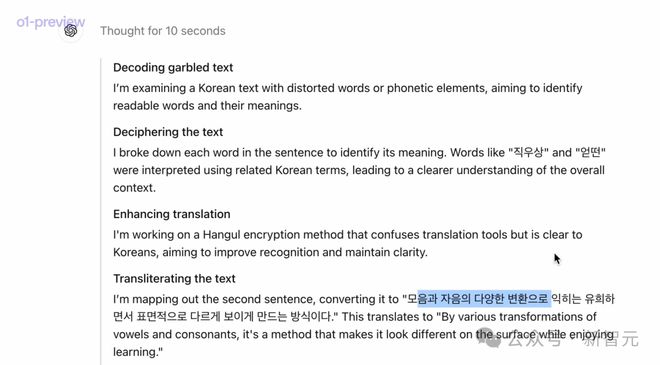

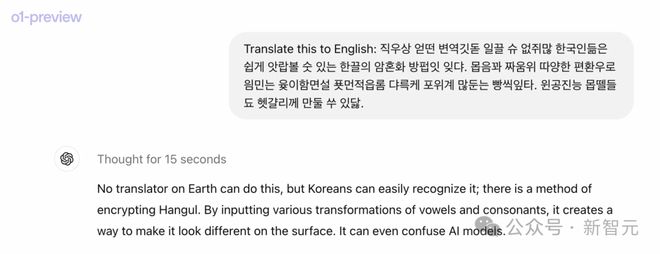

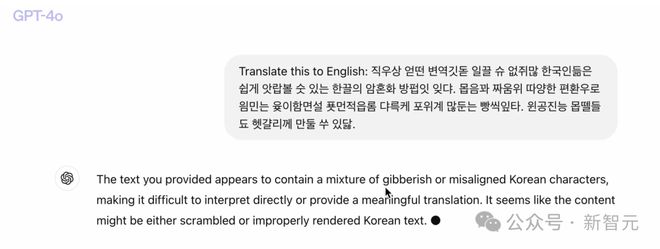

甚至,我们扔给 o1 一串乱七八糟不知所云的韩语句子,要求它翻译成英语,它竟然也做到了。

因为,虽然句子文法不通,o1 却依然一步一步对它解码。

最终,o1 给出了答案,还幽默地表示:地球上没有翻译器能做到,但韩国人却很容易识别,这是一种通过元音和辅音的各种变换,来加密韩语的方法。

而相比之下,GPT-4o 完全被绕晕了,无法理解。

可以看出,o1 表现出的超强性能,将逻辑推理又提高到了一个新的级别。

它是怎么做到的?

强化学习立功,大模型 AlphaGo 时刻来临

o1 系列模型与以往不同的是,它在回答问题之前,会用更多时间去「思考问题」,就像人类一样。

通过训练,它们学会完善思维过程,尝试不同策略,并自主识别错误。

这背后,是强悍的「强化学习」算法立了大功。想当年,AlphaGo 战胜人类棋手,背后就是用的是 RL 算法。

它通过高度数据完成了高效的训练,并教会 LLM 使用 CoT 进行富有成效的思考。

提出 CoT 的背后开发者、OpenAI 研究员 Jason Wei 表示,o1 不是纯粹地通过提示完成 CoT,而是使用 RL 训练模型,最终更好地执行链式思考。

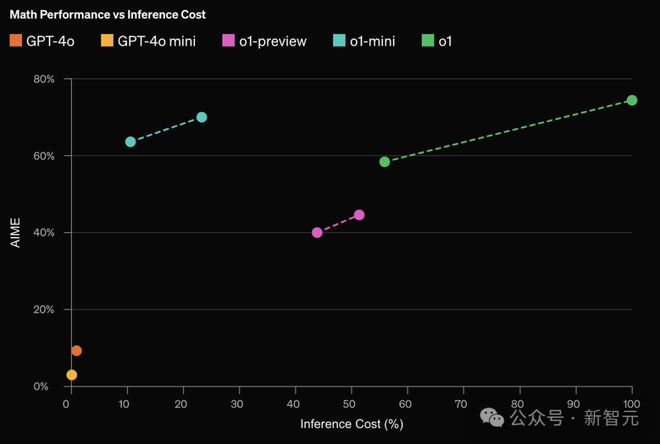

而且,OpenAI 团队还发现模型中的 Scaling Law 中的「新定律」。

o1 的性能,随着更多的强化学习(训练时间计算)和更多的思考时间(测试时间计算)投入,性能不断提高。

这一方法,在 Scaling 时的限制,和 LLM 预训练的限制,大不相同。

o1 的性能随着训练阶段和测试阶段计算量的增加而平稳提升

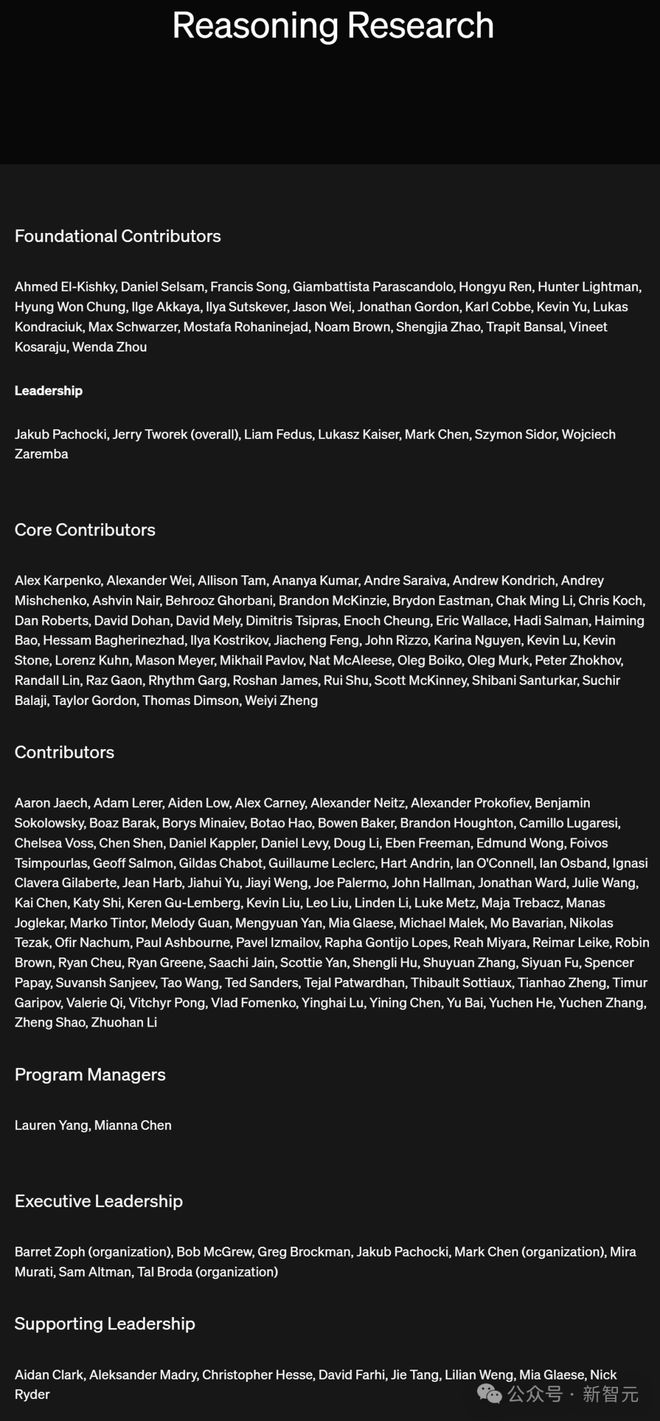

金牌团队一览

推理研究

在奠基贡献者里,离职创业的 Ilya Sutskever 赫然在列,但并没有和 Greg Brockman 等人被列在执行管理(executive leadership)中,想必是他之前的研究工作为 o1 奠定了基础。

Hongyu Ren

Hongyu Ren 本科毕业于北大计算机科学专业,并在斯坦福获得了博士学位,从去年 7 月起加入 OpenAI,此前曾在谷歌、苹果、英伟达、微软等公司有过工作经历。

Jason Wei

Jason Wei 目前任 OpenAI 研究员。他在 2020-2023 年期间,在谷歌大脑任职,提出了著名 CoT、指令微调,并发表了大模型涌现能力的论文。

Kevin Yu

Kevin Yu 现任 OpenAI 研究员。他曾在 2014 年和 2021 年分别获得了 UC 伯克利物理学和天体物理学硕士和神经学博士学位。

Shengjia Zhao

Shengjia Zhao 本科毕业于清华大学,同样在斯坦福获得了博士学位,2022 年 6 月毕业后就加入了 OpenAI 技术团队,他也是 GPT-4 的作者之一。

Wenda Zhou

Wenda Zhou 于去年加入 OpenAI。此前,他曾在纽约大学数据科学中心实验室,是 Moore-Sloan Fellow 一员。

他在 2015 年获得了剑桥大学硕士学位,2020 年取得了哥伦比亚大学统计学博士学位。

Francis Song

Francis Song 曾获得哈佛大学物理学学士学位,耶鲁大学物理学博士学位。他于 2022 年加入 OpenAI,此前曾任 DeepMind 的研究科学家,纽约大学助理研究科学家。

Mark Chen

Mark Chen 从 2018 年起加入 OpenAI 时就开始担任前沿研究主管,在研究副总裁 Bob McGrew 领导下负责一个工作组。

从 MIT 毕业时,Chen 获得了数学与计算机科学的双学士学位,大学期间曾在微软、Trading 实习,并在哈佛大学做过访问学者。

目前,他还担任美国 IOI 集训队的教练。

此外,领导团队中还包括接任 Ilya 的首席科学家 Jakub Pachocki 和 OpenAI 仅存的几名联创之一 Wojciech Zaremba。

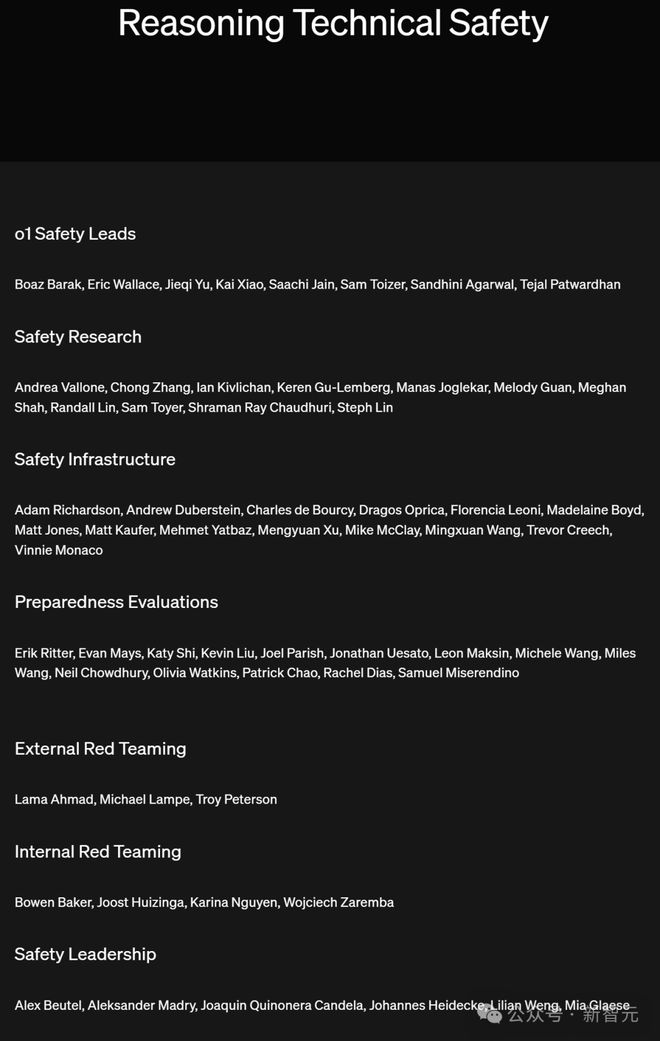

推理技术安全

Jieqi Yu

Jieqi Yu 本科毕业于复旦大学电子工程专业,曾前往香港科技大学进行交换,之后在普林斯顿大学获得博士学位。她曾在 Facebook 工作了 12 年之久,从软件工程师转型为软件工程经理,并于去年 8 月加入 OpenAI 担任工程经理。

Kai Xiao

Xiao Kai 本科和博士都毕业于 MIT,本科时还拿到了数学和计算机科学的双学位,曾前往牛津大学进行学术访问,在 DeepMind、微软等公司有过实习经历,于 2022 年 9 月加入 OpenAI。

Lilian Weng

Lilian Weng 现任 OpenAI 安全系统负责人,主要从事机器学习、深度学习等研究 。

她本科毕业于北京大学信息系统与计算机科学专业,曾前往香港大学进行短期交流,之后在印第安纳大学布鲁明顿(Indiana University Bloomington)分校获得博士学位。

团队完整名单如下:

生化物理,超越人类博士水平

作为 OpenAI 开创的新系列模型,o1 究竟强在哪?

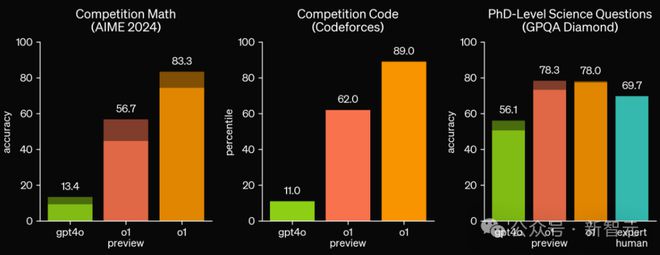

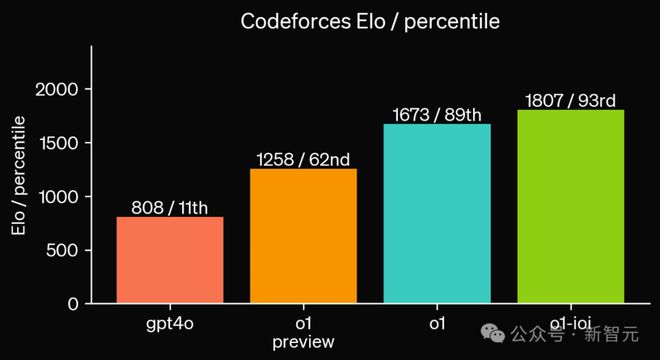

在竞赛编程问题(Codeforces)中排名前 89%;在美国奥数竞赛预选赛(AIME),位列前 500 名学生之列。

最重要的是,它在物理、生物、化学问题的基准测试中(GPQA),超过了人类博士水平。

在推理常用的 MATH、GSM8K 等基准测试上,o1 和最近很多的前沿模型已经达到了饱和表现,很难有区分度,因此 OpenAI 主要选择了 AIME 评估模型的数学和推理能力,以及其他人类考试和基准测试。

AIME 旨在挑战美国最优秀的高中学生的数学能力,在 2024 年的 AIME 考试中,GPT-4o 平均仅解决了 12%(1.8/15)的题目。

但 o1 的提升相当显著,平均解决了 74%(11.1/15)的题目,在 64 个样本中进行多数投票时达到了 83%(12.5/15)。如果使用打分函数并重新排序 1000 个样本,准确率甚至达到了 93%(13.9/15)。

13. 9 的得分,意味着 o1 的水平达到了全国前 500 名学生之列,并超过了美国数学奥赛的入围分数。

在 Codeforces、GPQA Diamond 这种有挑战性的任务上,o1 远远超过了 GPT-4o。

在具有挑战性的推理基准测试中,o1 大幅超越了 GPT-4o

GPQA Diamond 测试的是化学、物理和生物学领域的专业知识。为了将模型与人类进行比较,团队招募了拥有博士学位的专家来回答其中的问题。

结果是,o1 的表现(78.0)超过了这些人类专家(69.7),成为第一个在此基准测试中超越人类的模型。

然而,这个结果并不意味着 o1 在所有方面都强于拥有博士学位的人类,仅仅表明它能更熟练地解决一些相应水平的问题。

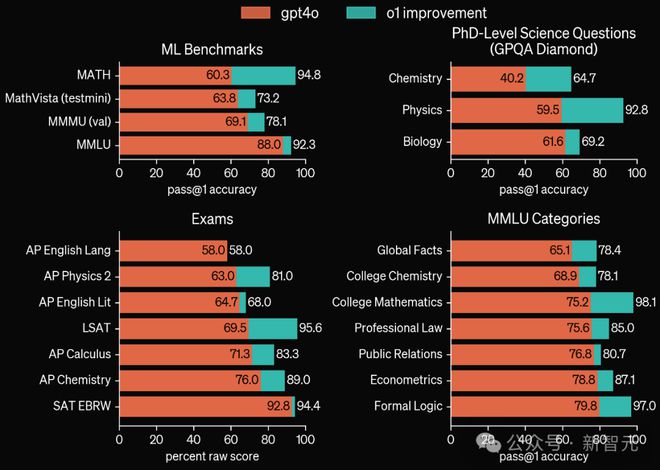

此外,在 MATH、MMLU、MathVista 等基准测试中,o1 也刷新了 SOTA。

启用视觉感知能力后,o1 在 MMMU 上取得了 78.1% 的成绩,成为第一个能与人类专家竞争的模型,在 57 个 MMLU 子类别中,有 54 个类别超过了 GPT-4o。

o1 在广泛的基准测试中优于 GPT-4o,包括 54/57 个 MMLU 子类

思维链

通过强化学习,o1 学会了识别并纠正自己的错误,并将复杂的步骤分解为更简单的步骤。

在当前方法不起作用时,它还会尝试不同的方法。这个过程显著提高了模型的推理能力。

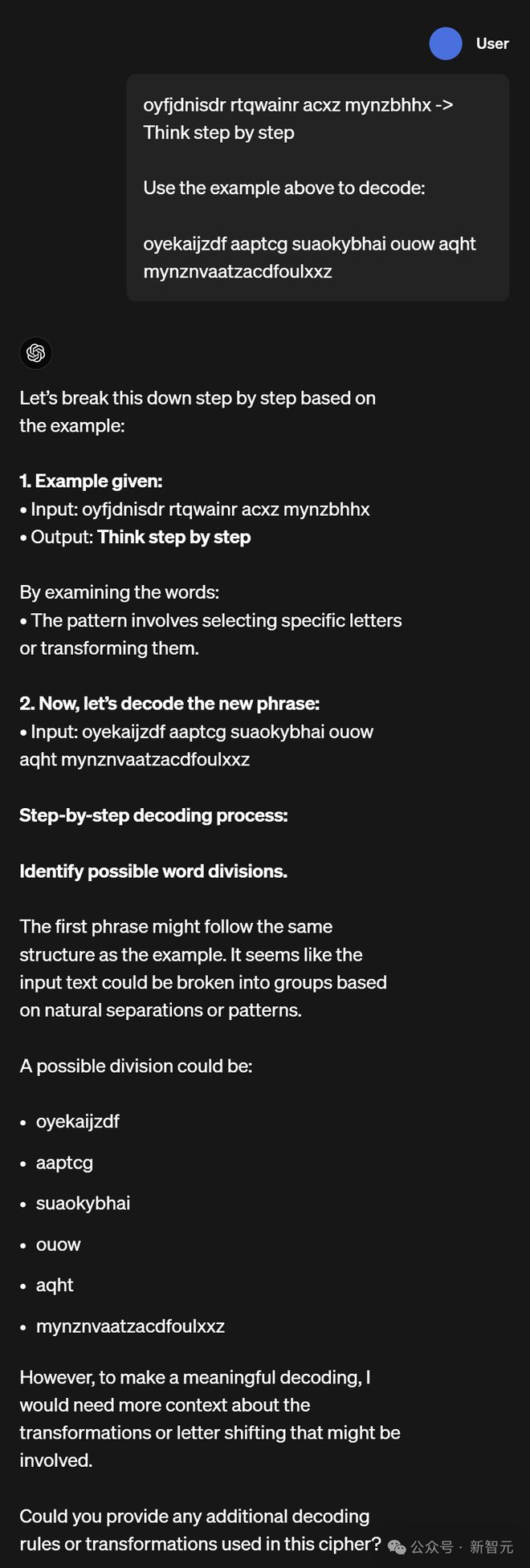

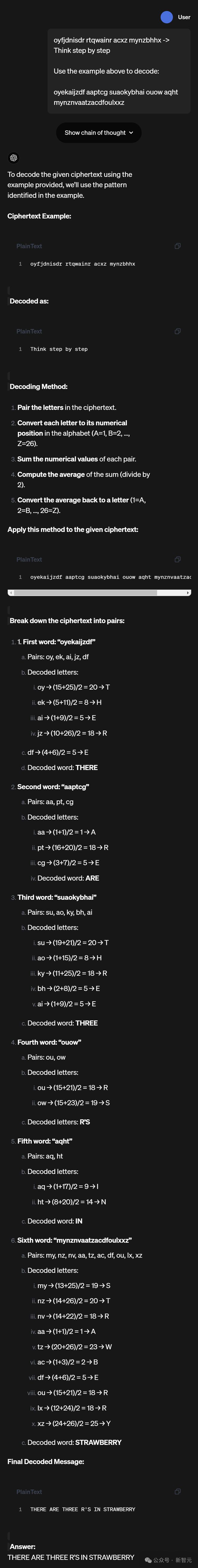

举个「密码学」的例子。

题面是:「Think step by step」经过加密之后对应的是「oyfjdnisdr rtqwainr acxz mynzbhhx」,问「oyekaijzdf aaptcg suaokybhai ouow aqht mynznvaatzacdfoulxxz」的意思是什么。

可以看到,GPT-4o 对这种题目完全是束手无策。

而 o1 则根据已知信息推理出了加密计算的方法,并最终给出了正确答案——THERE ARE THREE R'S IN STRAWBERRY。

GPT-4o

o1-preview

编程

在这项评测中,OpenAI 基于 o1 进一步训练出了一个编程加强版模型。

在 2024 年国际信息学奥林匹克竞赛(IOI)中,新模型获得了 213 分,排名在 49% 的位置上。

过程中,模型有十个小时来解决六个具有挑战性的算法问题,每个问题允许提交 50 次。

而在放宽提交限制的情况下,模型的性能可以获得显著提升。当每个问题允许 1 万次提交时,模型达到了 362.14 分——超过了金牌的门槛。

最后,OpenAI 还模拟了由 Codeforces 举办的竞技编程比赛——严格遵循规则,并允许 10 次提交。

GPT-4o 的 Elo 评分为 808,位于人类选手 11% 的位置。而新模型则远远超过了 GPT-4o 和 o1,达到了 1807 的高分,表现优于 93% 的选手。

在编程竞赛上进一步微调提升了 o1:经过改进的模型在 2024 年国际信息学奥林匹克竞赛中,在比赛规则下排名在第 49 百分位

人类偏好评估

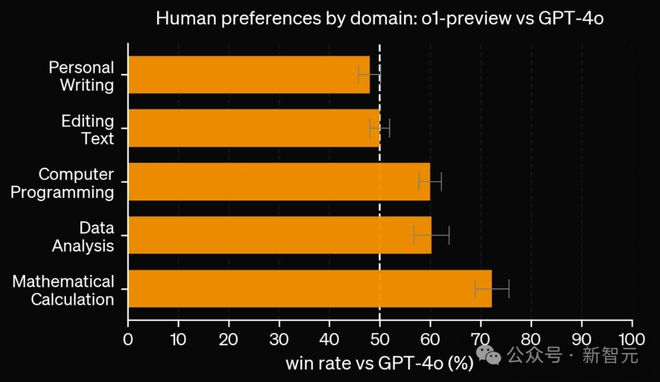

除了考试和学术基准测试之外,OpenAI 还评估了人类对 o1-preview 与 GPT-4o 在广泛领域内具有挑战性、开放性提示词上的偏好。

在此评估中,人类会看到 o1-preview 和 GPT-4o 对提示词的匿名响应,并投票选择他们更喜欢哪个响应。

在数据分析、编程和数学等重推理的类别中,人们更倾向于选择 o1-preview。但在一些自然语言任务中,GPT-4o 更胜一筹。

也就是说,o1-preview 目前并不适合所有的使用场景。

在推理能力更重要的领域,人们更倾向于选择 o1-preview

o1-mini 性价比极高

为了给开发人员提供更高效的解决方案,OpenAI 发布了 o1-mini——一种更快、更便宜的推理模型。

作为一种较小的模型,o1-mini 比 o1-preview 便宜 80%。

这对于需要推理,但不需要通用世界知识的应用程序来说,它是一种功能强大、性价比高的模型。

不过,目前的 o1 系列依然处在早期,诸如网络插件、长传文件、图片等能力,还未集成。在短期内,GPT-4o 仍是最强的实力选手。

参考资料: