文/温昀

“过去 22 个月,AI 发展速度超过任何历史时期。”9 月 19 日,阿里巴巴集团 CEO、阿里云智能集团董事长兼 CEO 吴泳铭在 2024 云栖大会上表示,阿里云正在以前所未有的强度投入 AI 技术研发和基础设施建设。

根据中国信通院数据,截至 2023 年底,中国算力总规模达到 230EFLOPS,存力总规模约 1200EB。过去一年,阿里云投资新建了大量的 AI 算力,但吴泳铭坦言,“还是远远不能满足客户的旺盛需求”。

一方面,市场对 AI 应用的热情前所未有的高。超过 30 万的企业客户通过阿里云百炼平台在千行百业用上了通义大模型。阿里云接触到的几乎所有客户、开发者、CTO,都在用 AI 重构自己的产品,很多应用看起来外壳没有变,但内核已经由 AI 驱动。

另一方面,AI 模型技术的迭代更新,推动 AI 计算成为计算体系的主导。以 CPU 主导的计算体系,正在加速向 GPU 主导的 AI 计算体系转移,新增算力需求超过 50% 来自以 GPU 为核心的 AI 计算,大模型正在倒推 AI 大基建加速快跑。

本次云栖大会上,阿里云宣布从服务器到计算、存储、网络、数据处理、模型训练和推理平台的技术架构体系的系列升级,真正让数据中心成为一台超级计算机。阿里云灵骏集群单网络集群已拓展至 10 万卡级别,连续训练有效时长可达 99% 以上,模型算力利用率提升 20% 以上。

但还不止于此,阿里云还正在从芯片、服务器、网络、存储到散热、供电、数据中心等方方面面,重新打造面向未来的 AI 先进基础设施。

下一代先进模型门槛将达到数十亿美金,但 AGI 的变革仍处于早期

过去一年多,生成式 AI 加速发展。投融资数据显示,2023 年度对生成式人工智能的投资激增,投资金额比 2022 年(约 30 亿美元)增长近九倍,达到 252 亿美元。相当部分投资涌入基础模型领域,生成式人工智能领域的主要参与者,包括 OpenAI、Anthropic、Hugging Face 和 Inflection,都获得了一轮可观的融资。不过,吴泳铭判断,这一切才刚刚开始,投入仍将继续飙升。

“要实现真正的 AGI,下一代模型需要具备更大规模、更通用、更泛化的知识体系,同时也将具备更复杂更多层次的逻辑推理能力。全世界先进模型竞争的投入门槛,将达到数十亿、数百亿美金的级别。”吴泳铭在论坛上表示。

本届云栖大会上,阿里云发布通义旗舰模型 Qwen-Max,参数规模升级,采用更多数据训练,模型效果更上一层,成为国内效果 GPT-4o 的大模型。同时,阿里云还发布了发布通义千问新一代开源模型 Qwen2.5,旗舰模型 Qwen2.5-72B 性能超越 Llama 405B,再登全球开源大模型王座。同时,通义的各类衍生模型和应用百花齐放,Qwen 系列衍生模型总数超过 5 万个,开源模型累计下载量已经突破 4000 万。不过,吴泳铭认为,这仍处于 AI 变革的早期,一切才刚刚开始。

“我们认为生成式 AI 将逐渐渗透数字世界,并接管数字世界,物理世界的大部分事物都会具备 AI 能力,形成下一代的具备 AI 能力的全新产品,并与云端 AI 驱动的数字世界连接产生协同效应。”吴泳铭说。

在他看来,AI 模型可以通过对物理世界数据的 Token 化,理解真实世界的方方面面。理解之后,AI 就可以模仿人类去执行物理世界的任务。这将带来新的产业革命。

吴泳铭举例称,汽车行业正在发生这样的变革。传统的自动驾驶技术依赖于人工编写的算法规则,即便拥有数十万行代码,也无法覆盖所有驾驶场景。而采用“端到端”的大模型技术进行训练后,人工智能模型能够直接从海量的人类驾驶视觉数据中学习,从而赋予汽车超越大多数驾驶员的驾驶技能。

机器人行业也是下一个迎来巨变的行业。未来,所有可移动的物体都可能转变为智能机器人,这些机器人可能包括工厂中的机械臂、建筑工地上的起重机、仓库内的搬运工、火灾现场的消防员,以及家庭中的宠物狗、保姆和助理等。

根据 IDC《2023—2024 年中国人工智能计算力发展评估报告》,67% 的中国企业已经开始探索生成式人工智能在企业内的应用机会或已经开始进行相关资金投入,2023 年人工智能在互联网 AI 渗透率高达 89%,而制造业的 AI 渗透率也已超过 47%。

“可以想见,AI 驱动的数字世界连接着具备 AI 能力的物理世界,将会大幅提升整个世界的生产力,对物理世界的运行效率产生革命性的影响。”吴泳铭表示。

50% 新增算力需求由 AI 驱动,

阿里云大举投入 AI 基建

云栖大会上,吴泳铭透露,“在新增算力市场上,超过 50% 的新需求由 AI 驱动产生,AI 算力需求已经占据主流地位。这一趋势还会持续扩大。”

想要改变物理世界,首先要做好基建。所有行业都需要性能更强、规模更大、更适应 AI 需求的基础设施。AI 技术的快速发展正推动着全球科技巨头在 AI 基础设施上的投资热潮。

近一年来,英伟达、AMD 等芯片制造商相继发布了新一代 GPU 产品,这些高性能计算芯片为大模型的训练和推理提供了强大动力;亚马逊表示下半年加大对其云服务(AWS)的资本支出,确保“供应与需求相匹配”;贝莱德和微软拟筹集 300 亿美元用于支持 AI 的基础设施;Google CEO Sundar Pichai 也强调了现阶段对 AI 基础设施进行投资的重要性,他认为当前投资不足的风险远大于投资过剩的风险。

看向国内,阿里云也在 AI 基建的投入上走在行业最前沿。阿里云正在以前所未有的强度投入 AI 技术研发和基础设施建设,以 AI 为中心,全面重构底层硬件、计算、存储、网络、数据库、大数据,并与 AI 场景有机适配、融合,加速模型的开发和应用,打造 AI 时代的最强基建。

大会现场,阿里云智能集团首席技术官周靖人展示了阿里云全面升级的 AI 基础设施产品家族。例如,最新上线的磐久 AI 服务器,支持单机 16 卡、显存 1.5T,并提供 AI 算法预测 GPU 故障,准确率达 92%;为 AI 设计的高性能网络架构 HPN7.0,可稳定连接超过 10 万个 GPU,模型端到端训练性能提升 10% 以上;人工智能平台 PAI 已实现万卡级别的训练推理一体化弹性调度,AI 算力有效利用率超 90%。

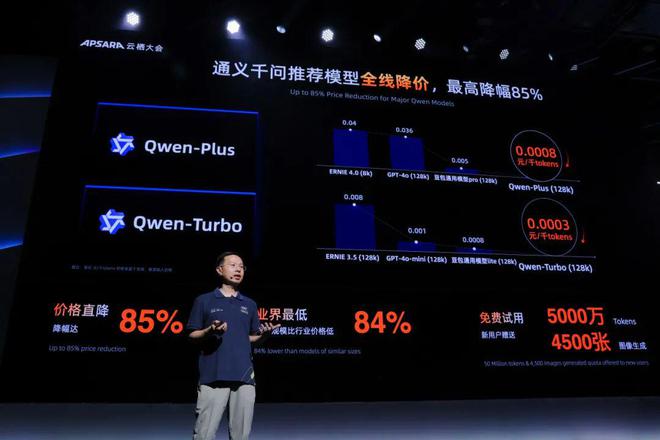

除了性能的不断提升,阿里云上 AI 算力成本也在持续下降,企业使用模型的成本越来越低。会上,阿里云宣布通义千问三款主力模型再次大幅降价,最高降幅 85%,百万 tokens 价格低至 0.3 元。过去半年,阿里云百炼平台持续降低大模型调用的门槛,进一步推动大模型的普惠。自首次宣布降价后,阿里云百炼付费客户数较上一个季度增长超过 200%,大批企业和开发者放弃私有化部署,选择直接在百炼上调用各类 AI 模型。

“我们降价的主要原因是技术优化。目前,模型不仅在快速迭代,其推理架构和系统优化也在不断提升。经过数月的努力,我们成功提高了模型推理的效率,这包括云基础设施和模型结构的改进,从而进一步降低了模型推理的成本。”周靖人表示。

随着 AI 基础设施的不断升级及算力成本的指数级下降,AI 在各行各业的渗透率还将继续提升。据悉,目前中国一汽、联想、微博、携程、喜马拉雅、三得利(中国)等 30 多万企业客户已经接入通义大模型;未来,生物医药、工业仿真、气象预测、游戏等行业还在加速拥抱大模型。

“我们希望企业和开发者能以最低的成本做 AI、用 AI,让所有人都能用上最先进的大模型。”周靖人表示。今天大模型的算力成本相比未来庞大的应用来说,仍然有降低的空间,阿里云还会继续将推进 AI 基础设施建设,将企业调用 token 的资费降到足够低,为未来应用的爆发创造条件。