阿里云视频生成大模型万相 2.1(Wan)重磅开源,此次开源采用 Apache2.0 协议,14B 和 1.3B 两个参数规格的全部推理代码和权重全部开源,同时支持文生视频和图生视频任务,全球开发者可在 Github、HuggingFace、魔搭社区下载体验。

此次开源的两个参数版本模型:

14B 版本万相模型在指令遵循、复杂运动生成、物理建模、文字视频生成等方面表现突出,在权威评测集 Vbench 中,万相 2.1 以总分 86.22% 大幅超越 Sora、Luma、Pika 等国内外模型,稳居榜首位置。

1. 3B 版本万相模型不仅超过了更大尺寸的开源模型,甚至还和一些闭源的模型结果接近,同时能在消费级显卡运行,仅需 8.2GB 显存就可以生成 480P 视频,适用于二次模型开发和学术研究。

从 2023 年开始,阿里云就坚定大模型开源路线,千问(Qwen)衍生模型数量已超过 10 万个,是全球最大的 AI 模型家族。随着万相的开源,阿里云两大基模全部开源,实现了全模态、全尺寸大模型的开源。

万相 2.1(Wan)模型技术解读

#模型性能

万相大模型在多个内部和外部基准测试中,均大幅超越现有的开源模型以及顶尖商业闭源模型。万相能够稳定展现各种复杂的人物肢体运动,如旋转、跳跃、转身、翻滚等;能够精准还原碰撞、反弹、切割等复杂真实物理场景。

在指令遵循能力方面,能够准确理解中英文长文本指令,还原各种场景切换、角色互动。

#关键技术

基于主流的 DiT 和线性噪声轨迹 Flow Matching 范式,万相大模型通过一系列技术创新实现了生成能力的重大进步。包括自研高效的因果 3D VAE、可扩展的预训练策略、大规模数据链路构建以及自动化评估指标,这些创新共同提升了模型的最终性能表现。

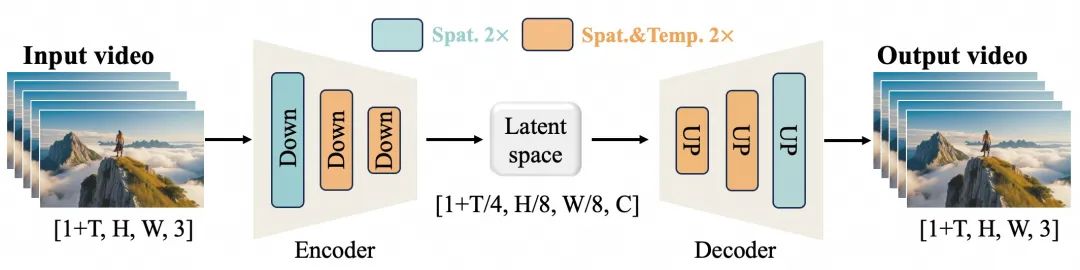

高效的因果 3D VAE:万相自研了一种专为视频生成设计的新型因果 3D VAE 架构,并结合多种策略来改进时空压缩、降低内存使用以及确保时间因果性。

万相大模型视频 VAE

视频 Diffusion Transformer:万相模型架构基于主流的视频 DiT 结构,通过 Full Attention 机制确保长时程时空依赖的有效建模,实现时空一致的视频生成。

万相视频模型架构图

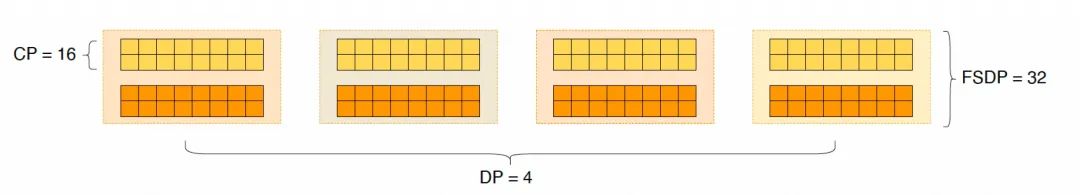

模型训练和推理效率优化:训练阶段,对于文本、视频编码模块,我们使用 DP 和 FSDP 组合的分布式策略;对于 DiT 模块,我们采用 DP、FSDP、RingAttention、Ulysses 混合的并行策略。在推理阶段,为了使用多卡减少生成单个视频的延迟,我们需要选择 CP 来进行分布式加速。此外,当模型较大时,还需要进行模型切分。

DiT 并行策略

#开源社区友好

万相已经在Github、HuggingFace、魔搭社区平台开源,全面支持了多种主流框架,已支持 Gradio 体验、xDiT 并行加速推理,Diffusers 和 ComfyUI 也在快速接入中,以方便开发者一键推理部署。这不仅降低了开发门槛,还为不同需求的用户提供了灵活的选择,无论是快速原型开发还是高效生产部署都能轻松实现。

-

开源社区链接:

Github: https://github.com/Wan-Video

HuggingFace: https://huggingface.co/Wan-AI

魔搭社区:https://modelscope.cn/organization/Wan-AI

- 相关新闻: