在人工智能领域风头正劲的 OpenAI,如今却陷入了硬件资源的 “泥沼”。

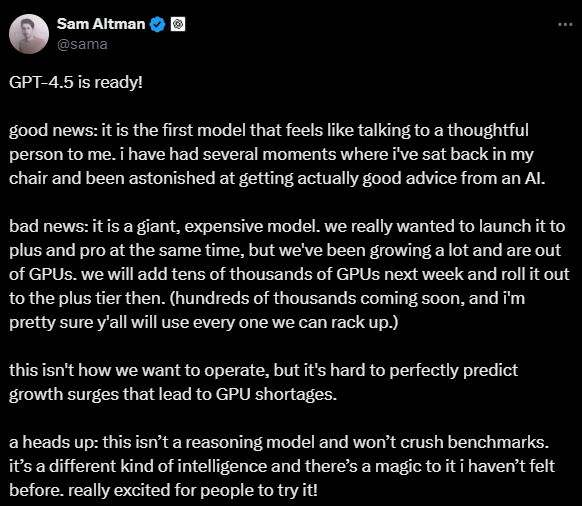

2 月 28 日在社交媒体上,CEO Sam Altman 大倒苦水,称公司因 GPU 供应不足,不得不 “挤牙膏” 式地分阶段推出 GPT-4.5 模型。

Sam Altman 表示,GPT-4.5 是“庞大”且“昂贵”的,而由于目前面临的 GPU 短缺问题,需要增加"数万个"GPU 才能支持更多用户访问。

从本周四开始,GPT-4.5 只能首先向 ChatGPT Pro 用户开放,随后在下周才能向 ChatGPT Plus 用户群体开放。"我们业务增长很快,现在 GPU 库存告罄,"Altman 表示,"下周我们将增加数万个 GPU。"

其实,OpenAI 的 “硬件之困” 早已露出苗头。

去年 10 月份,在 Reddit AMA 上,Sam Altman 就承认计算能力不足是产品按时出货的 “拦路虎”。面对下一代 AI 模型为啥这么久还没推出的灵魂拷问,他直言:

“这些模型太复杂了,我们得在众多好想法里艰难抉择,分配有限的计算资源。”

许多报道表明,OpenAI 一直在努力确保足够的计算基础设施来运行和训练其生成模型。据路透社报道,OpenAI 将专注于内部芯片设计。去年开始已经在与博通合作开发用于运行模型的 AI 芯片,该芯片最早可能在 2026 年问世。

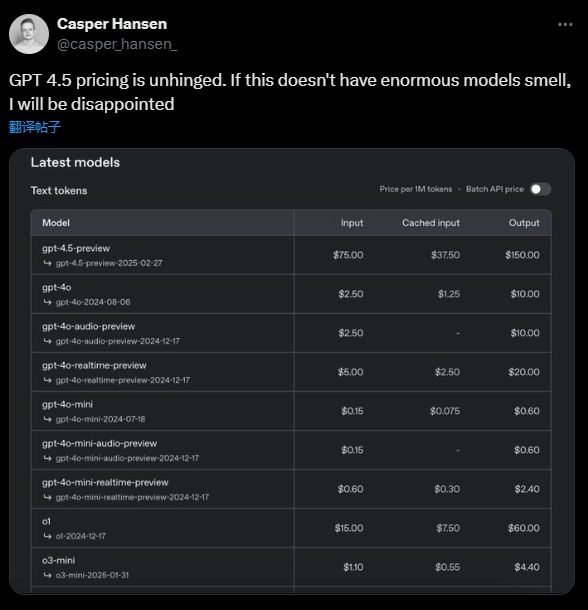

此外,GPT-4.5 的定价策略引人注目。OpenAI 对该模型的收费标准为:输入每百万 token(约 75 万字)收费 75 美元,输出每百万 token 收费 150 美元。这一价格相较于公司主力模型 GPT-4,输入成本增加了 30 倍,输出成本增加了 15 倍。

在这场 AI 军备竞赛中,硬件成本正呈指数级飙升。而此次 GPT-4.5 的定价策略,本质上是在将硬件成本转嫁给终端用户。