新智元报道

编辑:编辑部 HYZ

全球首个开源多模态推理大模型来了!38B 参数模型性能直逼 DeepSeek-R1,同尺寸上横扫多项 SOTA。而这家中国公司之所以选择无偿将技术思路开源,正是希望同 DeepSeek 一样,打造开源界的技术影响力。

刚刚,昆仑万维正式开源了全球首个工业界多模态推理模型 Skywork R1V(以下简称「R1V」)!

R1V 高效地将 DeepSeek-R1 这种强大的文本推理能力无缝 scaling 到了视觉模态,实现了多模态领域的领先表现,并以开源方式推动了技术进步。

由此,多模态推理的新时代即将开启。

R1V 的实力,究竟有多强?

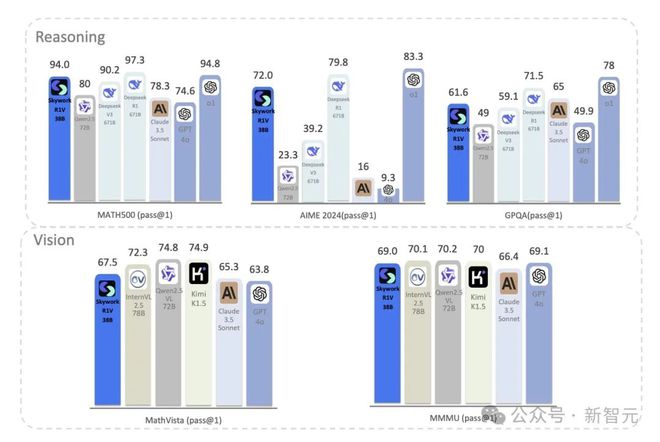

在视觉问答任务中,R1V 直接对标 Claude 3.5 Sonnet、GPT-4o 等闭源模型,同时还保留了顶级文本推理能力。

在 MMMU 基准测试中,R1V 以 69 分创下同等规模新高,在 MathVista 上拿下 67.5 分,达到领先的开源模型水平。

无论是复杂的数学推理,还是图像中的逻辑分析等,R1V 都能轻松驾驭,堪称多模态领域的「全能战士」。

总结来说,R1V 有以下三大亮点。

1. 全球第一个工业界开源多模态+推理模型

2. 性能接近甚至超越了规模大两倍的开源模型

3. 通过开源让技术可以惠及到更多人

这背后的缔造者,就是中国的 AI 科技公司——昆仑万维。

R1V 的问世,更以开放的姿态为全球 AI 开源社区注入了全新活力。

即日起,模型权重、推理代码、技术报告全盘开源。

GitHub:https://github.com/SkyworkAI/Skywork-R1V

Hugging Face:https://huggingface.co/Skywork/Skywork-R1V-38B

技术报告:https://github.com/SkyworkAI/Skywork-R1V/blob/main/Skywork_R1V.pdf

这标志着,昆仑万维成为全球首家开源多模态思考模型的公司,朝着 AGI 落地迈出重要的一步。

而选择开源 R1V 视觉思考模型,也正是昆仑万维为了更坚定地贯彻 AGI 的梦想,推动开源社区的技术进步。

R1V:全球首款开源多模态推理模型

此前,OpenAI o1 和 DeepSeek-R1 在全球带来了长思考模型的热潮,让大模型领域进入了全新的技术范式。

而不同于长思考模型专注于多步推理的特点,视觉思考模型则专注于从图像或视频中提取信息、进行逻辑推理。

如果要给它下个定义的话,什么是视觉思考模型?

简单来说,视觉思考模型是一种,能在文本、视觉复杂任务中,展现惊人推理能力的 AI。

它不仅能「读懂」文字,还能「看懂」图像,并基于此进行深度分析和逻辑推理。

首先来一道数学题:「用圆心角为 120°,半径为 6cm 的扇形纸片卷成一个圆锥形无底纸帽,则这个纸帽的高是?」

R1V 经过短暂纠错后,给出了清晰完整的解题过程,并得出正确答案,表现出了较强的逻辑推理能力。

接下来再来一道更难一些的:「函数f(x)=∣2x−3∣+1 在x=2 和x=5 处的导数关系是?」

可以看到,R1V 先找到了绝对值部分∣2x−3∣的零点:令 2x-3=0 得x=1.5。

然后得出,当x≥1.5 时,f(x)=2x-3+1=2x-2,导数f '(x)=2;当x<1.5 时,f(x)=-(2x-3) +1=-2x+4,导数f '(x)=-2。

由于题目中的x=2 和x=5 均大于 1.5,所以都属于f(x)=2x-2 部分。因此,f '(2)=2,f '(5)=2,即两点处的导数相等。

最后,R1V 给出了答案:(B)等于。

以上案例中不难看出,R1V 在视觉+推理上表现惊艳,所以,它是如何逆袭成功的?

炼丹之道,细节全公开

最新公开的技术报告中,揭秘了三大杀招。

昆仑万维的研究者,首次发现了跨模态的迁移学习。

R1V 首次实现了将大模型的文本推理能力高效迁移至视觉模态,通过 Skywork-VL 视觉投影器的有效训练,显著保留了原有的推理能力。

整个过程无需从头重新训练基座语言模型和视觉编码器,且有效保留了原有的文本推理能力。

具体来说,研究者提出了一种高效的多模态迁移方法,通过 MLP 结构,有效地将具有推理能力的语言模型与视觉骨干对齐。

这样,就大幅减少了对大量多模态推理数据的需求。

这种方法背后的关键洞察,就在于将视觉-语言表示的对齐与推理能力的保留解耦。

直接将具有推理能力的语言模型(fl)连接到视觉骨干(fv),会需要大量的 R1 风格格式的多模态推理数据,以同时实现这两个目标。

然而这种做法成本太高,不切实际。因此,研究者采用了一种相反的分阶段策略。

首先,他们训练一个 MLP 适配器,将 fv 与具有相同架构但无推理能力的替代语言模型( )对齐; 随后,他们利用和 fl 之间的潜在相似性,将预训练的 MLP 转移,以使 fv 与原始的推理能力模型 fl 对齐。

这样,所需数据量就大幅减少。

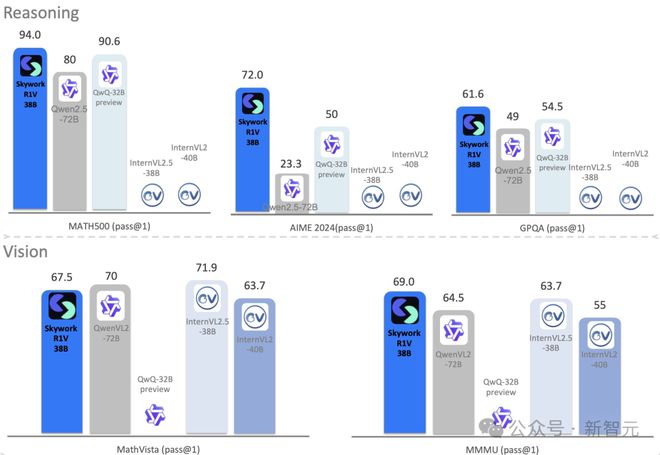

所导致的结果就是,正如前文提到的,R1V 在权威的数学推理基准测试 AIME 和 MATH500 中,分别取得 72.0 和 94.0 的高分,展现了强大的推理竞争力。

在同等规模大小模型中的推理能力遥遥领先,并且与闭源模型以及大尺寸模型相比,仍有很强的竞争力。

这样的优异的文本推理能力,直接「搬家」视觉领域,效率直接拉满。

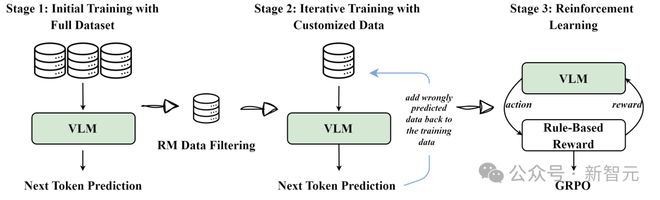

R1V 还采用了迭代监督微调(Iterative SFT)和 GRPO 强化学习相结合的混合训练方法,能够动态调整思维链长度。

这个过程,一共分为三个阶段。

阶段1:使用完整数据集,进行初始训练;

阶段2:使用定制数据,进行迭代训练;

阶段3:强化学习。

混合式训练策略

具体而言,在 SFT 阶段,研究人员迭代训练一系列模型M₀, ..., Mₜ,其中每个后续模型Mₜ₊₁,都在奖励模型选择的高质量数据和前一迭代中处理不正确的样本上进行训练。

在 RL 阶段,遵循了 DeepSeek R1 提出的方法,利用基于规则的奖励系统 GRPO,进一步提升模型的泛化能力。

强化学习训练完成后,研究人员选择一个在性能和推理合理性之间达到最佳平衡的模型作为最终模型。

经此训练后的模型,不仅提升了推理效率,还在开源模型中,率先实现 SOTA。

经过强化学习训练,R1V 在 MMMU 基准上达到 69 分的高分,同时在 MathVista 上取得 67.5 分,接近更大规模闭源模型的表现。

此外,研究团队还提出了一个自适应长度的思维链蒸馏(AL-CoTD)框架。

像 o1 这样的推理模型之所以表现出色,很大程度上归功于,它们在推理时能模拟人类长时间的思考过程。

然而,一个关键问题来了——推理模型有时会「过度思考」。

或许你也感同身受:输入一个问题后,AI 有时会反复思考很多遍。

最近,来自 UC 伯克利 CMU、UMass Amherst、上交大等国内外机构也通过研究实证,推理模型「过度思考」会导致计算资源浪费,甚至损害模型本身的性能。

某些情况下, AI 生成的序列可能长达数万个 token,收益却微乎其微。

昆仑万维提出的 AL-CoTD 框架,可根据需求动态调整思维链长度,有效缓解推理模型「过度思考」的问题,并显著提升了推理效率。

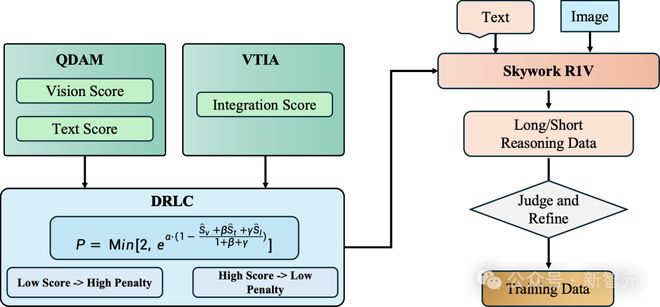

它一共包含三大核心组件:质量与难度评估模块(QDAM)、视觉-文本集成分析器(VTIA)、动态推理长度控制器(DRLC)。

自适应长度思维链蒸馏

· QDAM

质量与难度评估模块利用 GPT-4o 系统性地评估图文查询对,从视觉得分(Sv)和文本得分(St)两个主要维度进行分析。

视觉得分(Sv)会量化图像的视觉特征,具体包括图像清晰度和图像必要性。文本得分(St)则会分析语言特性,主要涵盖问题质量、难度级别和推理需求。

这个综合评估框架能够捕捉多模态查询中的感知复杂性和认知复杂性,从而能更准确地评估多模态任务的难度。

· VTIA

视觉-文本融合分析器(VTIA) 通过句法分析和语义分析确定跨模态融合的必要深度,并计算融合评分(SI)。

VTIA 依靠 GPT-4o 识别图文查询中的模式,并根据查询的复杂程度动态调整融合需求。

高融合模式常见于科学解释类问题,涉及多个视觉对象的空间关系理解,需要高阶视觉推理能力。低融合模式主要出现在物体识别任务,侧重于直接物体识别,不需要复杂推理。

这样,VTIA 就实现了针对查询复杂度的自适应跨模态融合,确保模型合理分配计算资源。

· DRLC

动态推理长度控制器(DRLC) 通过归一化的视觉得分( )、文本得分( )和融合评分( )来动态调节推理链的长度。

这些归一化得分通过最小-最大缩放归一化到区间 [0,1]。

推理链长度的调节遵循以下两大原则:

- 降低重复惩罚(促进深入推理):当图文质量高、认知难度大、视觉场景复杂时,降低重复惩罚,以允许更长的推理链。

- 高重复惩罚(减少冗余推理):当查询涉及低难度任务、简单视觉识别,且文本-图像的融合需求较低时,提高重复惩罚,从而缩短推理链,避免不必要的复杂推理。

· 多阶段自蒸馏管线

在 DRLC 模块的基础上,研究者进一步引入渐进式自蒸馏策略,以提高推理数据的质量。

总结来说,这篇论文的发表,也意味着相较于其他不开源或不免费的模型,昆仑万维无偿把上述技术思路给开源了。

这也就充分体现出 R1V 和 DeepSeek 的思路一样,希望通过开源持续打造技术影响力。

值得一提的是,当前想要打造一个全模态的模型,不仅需要在特定领域独立训练多个专业模型,而且还会面临跨模态协同的算力挑战。

为实现多模态到全模态的跨越,团队设计了一种全新的全模态扩展技术,使得 R1V 在单个模型中具备同时处理图像、视频、语音等多种模态信息的能力。

结果显示,「进化」后的 R1V 不仅能够在单个模型中同时实现图像、视频、语音的全模态思考能力,而且还能在语音和视觉理解评测中均斩获多项 SOTA 成绩。

敢为人先,中国 AI 企业硬核担当

作为中国 AI 领军企业,昆仑万维始终秉持着——实现 AGI,让每个人更好塑造和表达自我,持续深耕 AI 前沿技术。

过去 3 年,这家公司在音乐大模型、文本大模型、视频模型等领域,取得了一系列突破,并构建起了完整的 AI 产品矩阵。

当世界模型能够模拟物理世界时,虚拟实验、仿真和影视创作都将迎来爆发式增长。

从 AI 前沿基础研究,到基座模型,再到 AI 矩阵产品/应用的完整布局,昆仑万维正一步步将技术愿景变为现实。

下一步,他们还将陆续开源具有空间推理能力和世界理解能力的视觉思考模型,以及全模态思考模型。

而 R1V 的诞生,是中国 AI 向世界发出的洪亮声音。