OpenAI 在其开发者 API 中推出了价格最贵、性能更强的 o1-pro 模型。

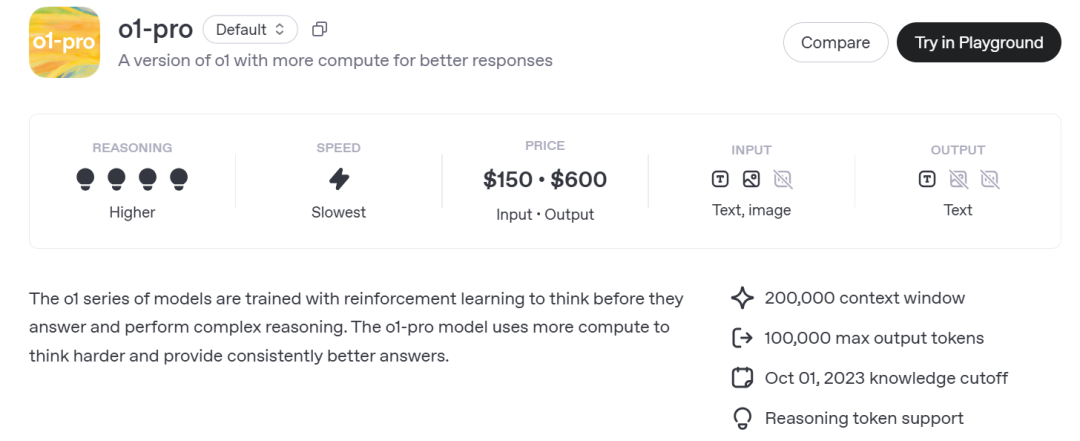

OpenAI 介绍称,o1-pro 使用比 o1 更多的计算资源来提供「更稳定、更优质的回答」。该功能仅对特定开发者开放(Tier 1–5 开发者),支持视觉、函数调用、结构化输出,并兼容 Responses API 和 Batch API。

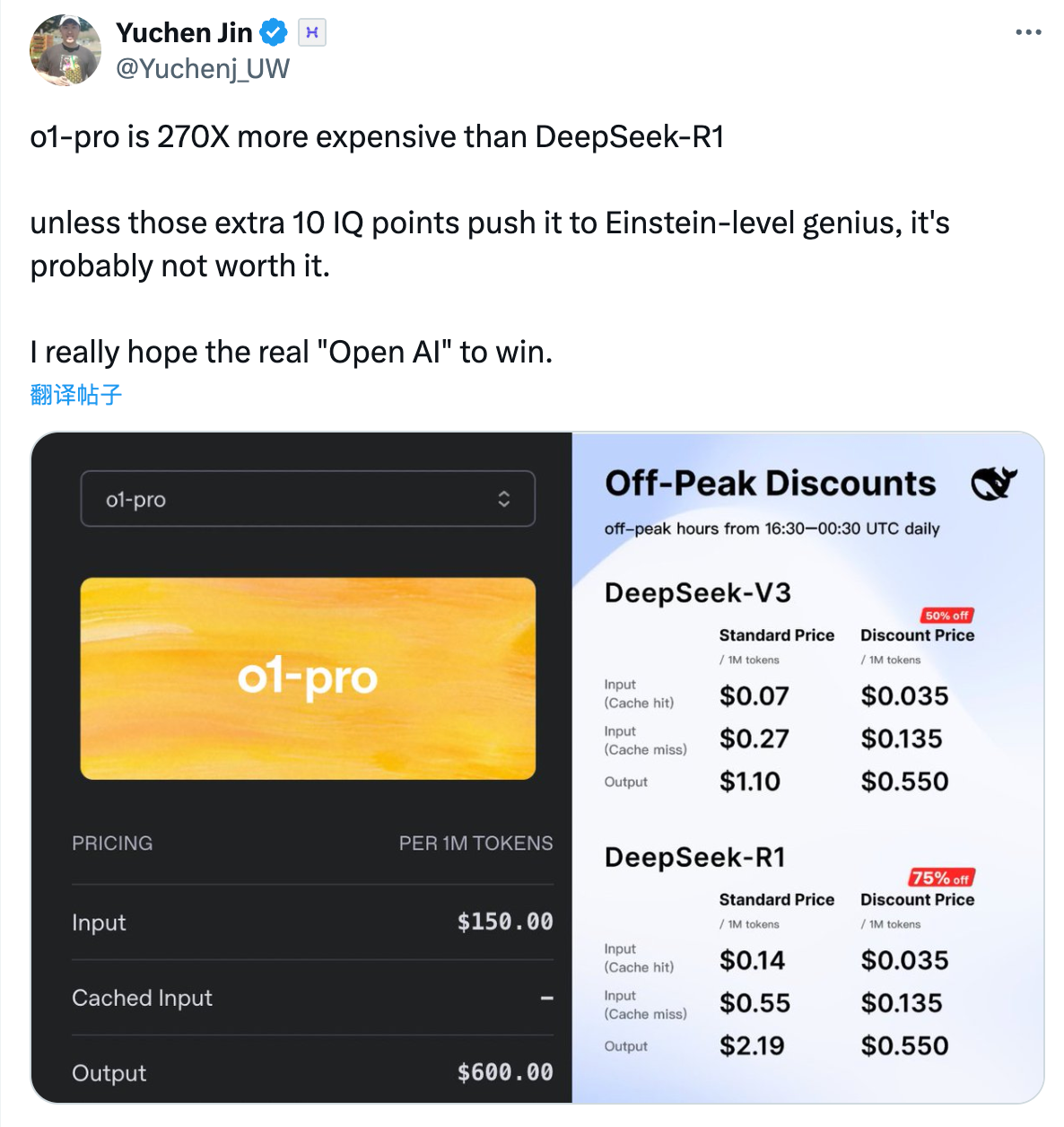

计算量增加的同时, o1-pro 的使用成本也更高:输入每百万 token 需支付 150 美元,输出每百万 token 则需 600 美元。

这一价格是 OpenAI 的 GPT-4.5 输入费用的两倍,是 o1 模型的十倍,堪称 OpenAI 最贵的模型。

相比之下,在标准时段,DeepSeek-V3 的每百万输入 token 价格分别为 0.07 美元(缓存命中)和 0.27 美元(缓存未命中),输出 token 价格为 1.10 美元。而 DeepSeek-R1 每百万输入 token 价格为 0.14 美元和 0.55 美元,输出 token 为 2.19 美元。

OpenAI 认为,o1-pro 的性能提升足以让开发者愿意支付这笔高昂的费用。

据外媒 TechCrunch 报道,尽管 OpenAI 公布的纸面参数很亮眼,但一些内部基准测试显示,在编程和数学问题上,o1-pro 的表现仅比 o1 略好一些。不过,测试结果也表明,它在回答问题时的稳定性也更高。

OpenAI CEO Sam Altman 曾在上月预测,使用固定级别 AI 的成本大约每 12 个月骤降 90%,将极大推动 AI 的普及化。然而,o1-pro 的定价却似乎有些背道而驰,反而走起了「高奢」路线。